Trés bon article deCowcotland donc voici un résumé d'expert pour les plus fénéants d'entre vous.

Et n'oublions pas la conclusion...pourraient

semblerait

Ce dernier pourrait avoir le droit

pourrait exploiter

tout cela reste pour le moment au gros conditionnel.

...

Affichage des résultats 211 à 240 sur 6054

Discussion: [Cartes graphiques v5] Discussions et conseils

-

29/12/2020, 17h05 #211

-

29/12/2020, 17h53 #212

Je réitère ce qui a été dit plus haut, faut déja réussir à trouver un site dont le stock ridicule n'a pas été pillé par les gros vilains scalpers pour trouver une des 30XX alors les 4080.... Ca serait pas un peu du foutage de tronche et la course à l'armement face a AMD ? Et comme le disait Qiou, les "entrée des gamme" 30XX sont déja monstrueuses pour les applis actuelles....

Le Pyro est le meilleur ami de l'ingé...

-

29/12/2020, 18h30 #213

-

29/12/2020, 18h42 #214

Cette discussion n'a rien à faire ici et tout dans le topic des rumeurs. Merci.

-

02/01/2021, 13h06 #215

Dites les coins, question tres conne, j'ai récup une 3070, et sur la boite est écrit 1 connecteur 8 fiche, mais sur la carte je vois 2 connecteurs 8 fiches, du coup j'ai branché les 2 connecteurs c'est pas grave ou dangereux ?

-

02/01/2021, 13h11 #216

Une 3070 avec un seul connecteur à 8 fiches ? Je ne pense pas que ça existe

De mon côté j'ai reçu ma carte Asus TUF RTX 3080 OC, je vais pouvoir pousser les réglages sur Cyberpunk avec mon 35 pouces UW en 3440x1440

-

02/01/2021, 13h27 #217

-

02/01/2021, 13h27 #218

-

02/01/2021, 13h30 #219

Ah merde, y avait cette histoire de connecteur proprio que nVidia essaie de pousser, j'avais oublié cette histoire et je m'étais fié à la photo du connecteur sur la carte

Merci d'avoir corrigé !

-

02/01/2021, 13h31 #220

-

02/01/2021, 13h57 #221Tyranaus0r

-

02/01/2021, 14h59 #222

Il ne faut pas un adaptateur spécifique ?

EDIT : si, nVidia fournit un adaptateur 8->12 broches avec leurs cartes FE, regarde si le fabricant de ton alim ne fournit pas d'adaptateurs...

-

02/01/2021, 15h02 #223

Ba je sais pas, j'avais 2 connecteurs 8 fiches dans ma tour, je les ai branché et voila.

Bon ca a l'air de marcher comme ca, donc je vais laisser avec les 2 connecteurs 8 fiches et basta non ?

-

02/01/2021, 15h10 #224

Seulement pour les FE.

Ou bien un câble spécifique complet, comme ce que je fais avec ma 3080FE et le câble offert par Seasonic.

La carte de darkmanticora n'est probablement pas une FE, de plus selon la conception et l'OC de base elle peut nécessiter 2x8 pins.

Comme il existe des 3080 non FE nécessitant 3x8 pins alors que la FE en utilise 2x8.

Et c'était la même chose avec les RTX2000, et GTX1000 etc

- - - Mise à jour - - -

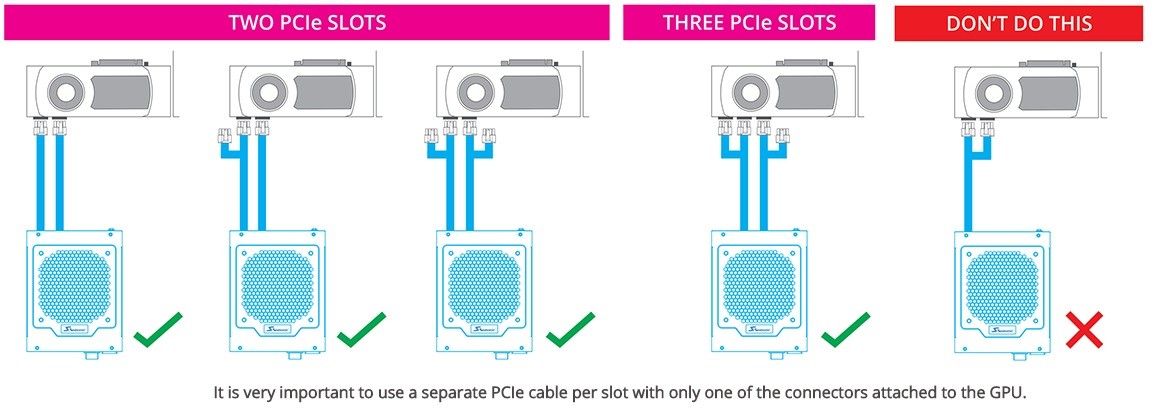

Si ta carte a deux ports 8 pins alors :

- ce n'est pas une FE, donc pas de 12 pins.

- il faut les brancher tous les deux.

- il vaut mieux utiliser deux câbles distincts.

-

02/01/2021, 15h10 #225Tyranaus0r

-

02/01/2021, 16h59 #226

-

02/01/2021, 18h00 #227

Merde pareil, j'ai pas 2 cables distinct et pas sur d'en avoir d'autre !

BOn normalement mon alim 550W a l'air de tenir. Par contre sur 2 jeux que j'ai test (Second extinction et godfall) je monte a plus de 60 fps (mais j'ai activé Vsync car sinon j'ai du tearing) mais ca arrive que les jeux freeze 1 sec et retournent a la normal.

Est ce que ca peut etre du au fait que j'ai pas refait d'install clean des drivers ? Ou d'autre chose dont je n'aurais pas connaissance ?

Edit : question annexe, niveau consommation CPU, y'a une grosse différence entre le ryzen 5 2600X et le Ryzen 5 5600 ?

-

02/01/2021, 19h52 #228

-

02/01/2021, 20h08 #229

Si t'as des petits Freeze ça peu venir de pleins de choses, Thermal Throttle, la carte est trop chaude et réduis ça charge le temps revenir à de bonne température, et vue que les ventilos tourne à fond ça refroidis vite et ça repart aussi sec, mais dans le cas présent ça devrait être répétitif, et arrivé réguliérement, tu peu le verifier avec MSI afterburner, si tu vois que les baisse de FPS correspondent a une baisse d'utilisation GPU et/ou température haute qui chute rapidement.

ça peu être aussi car ta RAM est blindé/trop lente et/ou au fait que le jeu soit sur un disque lent comme un HDD, ou parfois car le jeu est l'OS sont sur le même Disque, c'est qq chose que j'ai subis sur un vieux SSD.

ça peut être aussi la Vram, le fait de demander à ta CG d'afficher des textures trop hautes en qualités fait que parfois t'as des freez le temps qu'elle décharge ce qu'elle n'utilise plus pour charger les nouvelles mais c'est quelque chose qui devrais arrivé surtout lors de changement d’environnement, d'event ou cinématique etc (pas que les textures mais tout ce qui consomme de la Vram, ombre, AO, etc, les textures c'est juste plus facile pour tester et vérifier).

Enfin, oui, ça peu venir du fait d'avoir un seul cable, j'avais une GTX 980 et une Allim Bequiet de 550W mais avec le temps elle à du perdre en efficacité, je n'avais pas pensé à ça avant et j'avais mi un seul câble, et j'avais des drop de perf sans prévenir, sans raison et très aléatoire, quand j'ai eu connaissance de ça, j'ai pris un adaptateur qui passe de 2x3 en Molex vers 2x3 Pin et j'ai mis ça sur la CG, changement radicale!

ça existe de pleins de types ces adaptateur, Sata, Molex, etc.

Sinon les Drivers, ouais, j'en doute quand même, tu peu toujours essayer un fresh instal, t'as peut être fait une bêtise dans tes paramètre ou profils.

(Note: je conseil de mettre "power management" sur "performance optimal", et "filtrage des textures" sur "ultra performance", pour le filtrage des textures tu verras un petit gain et en perf et 0 différences en jeux, tu peu faire le test sur un benchmark comme Heaven pour voir que le gain est réel, c'est une vieille options qui date et qui aujourd'hui ne sert plus à rien vue que la différence et imperceptible en 1080p et au dessus encore plus ... tout comme l’anisotropique qui deviens impossible à différencier entre x8 et x16, mais cette options elle ne consomme rien en ressources, du moins pas assez pour justifier de passé de x8 à x16)

... tout comme l’anisotropique qui deviens impossible à différencier entre x8 et x16, mais cette options elle ne consomme rien en ressources, du moins pas assez pour justifier de passé de x8 à x16)

Environ 30% de consommation en moins pour le 5600x comparé au 2600x de ce que j'ai vue, le miens en benchmark CPU Heavy comme Blender ou Cinebench monte a 70 ou 75w maxi (de mémoire), soit pas grand chose vue les perf du bestiau!

- - - Mise à jour - - -

J'ai une seasonic mais j'avais pas ce petit câble, t'aurais la référence ?

C'est aussi car chaque câble est prévu pour délivré une certaine puissance et que même si "théoriquement" l’alim peu envoyer ce qui serra demander par la CG sur un câble unique, avec me temps ce serra moins le cas, c'est pour assurer une meilleur alimentation de la CG plus sable.

Mais pas que!

En fait, de base, sans rien avoir à configurer, depuis Maxwell (ou avant? ) avec les GTX 900, y'a un petit Algorithme qui fait que tant que la CG n'est pas trop haute en température, alors elle vas appeler plus de courant, et si ont lui donne, alors elle augmente ça fréquence, un genre d'auto OC, et donc elle peu dépassé ça consommation théorique tant qu'elle est bien refroidis et que l'alim suis.

) avec les GTX 900, y'a un petit Algorithme qui fait que tant que la CG n'est pas trop haute en température, alors elle vas appeler plus de courant, et si ont lui donne, alors elle augmente ça fréquence, un genre d'auto OC, et donc elle peu dépassé ça consommation théorique tant qu'elle est bien refroidis et que l'alim suis.

-

02/01/2021, 20h27 #230

Dites, vous savez jusqu'à quand il devrait y avoir des arrivages de nVidia "Founders Edition" chez LDLC ?

-

02/01/2021, 21h46 #231

Merci pour ta réponse tres complete!

Il semble que le fresh install des drivers ai résolu mon problème !

Pour le branchement, j'ai regardé et je n'ai qu'un cable qui split en 2*8 et aucun deuxieme vrai cable

Intéressant pour le cpu ! je pensais que ca allait plus consommer ! Je pense que ce sera mon prochain upgrade, par contre c'est dure a enlever l'ancien CPU pour en remettre un autre ? j'ai toujours fait monter mes pc, a part changer la ram et la cg j'ai jamais bricolé dans ma tour

-

03/01/2021, 09h28 #232

Je fais ça aussi mon 5600X arrive dans quelques jours en remplacement du 2600X. Pour le démonter c’est simple:

- met à jour ton BIOS avant avec la dernière version dispo sur le site de ton fabricant de carte mère

- avant de démonter, fait tourner le PC 5min pour réchauffer un peu le processeur, cela va ramollir la pâte thermique et te faciliter le démontage

- ensuite tu éteins l’ordi et tu débranches la prise d’alim de la tour, l’idéal est de placer ta tour sur le côté pour que le cpu soit à plat et dans une zone bien éclairée pour voir ce que tu fais

- débranche le ventilateur cpu, dévisses le radiateur et retire le, s’il ne vient pas une petite rotation permet souvent de décoller la pâte thermique mais comme tu l’as chauffé un peu ça doit venir tout seul

- sans te brûler, retire le cpu à l’aide du levier de verrouillage sur le côté, pose-le doucement soit dans son emballage d’origine, soit sur un morceau de mousse.

- nettoie le restant de pâte thermique sur le radiateur et le vieux cpu à l’aide de dissolvant à ongles ou acétone

- installe le nouveau cpu de la même manière en le verrouillant avec le levier

- suis les instructions de montage de ton ventirad cpu en oubliant pas de remettre de la pâte thermique et de rebrancher le ventilateur quand tu as fini

Rien de bien compliqué donc! Ça se fait en 10-15min sans se stresser.

-

03/01/2021, 11h41 #233

Ah oui !

Bon ba ça sera mon prochain upgrade d'ici 1 ou 2 mois le temps de remettre les finances flot merci !

Bon sino' je redécouvre la vr avec la 3070 ! Et sur cp2077 elle monte à 90 degré max en tout à fond et le cou a 86.

Ca passe ?

-

03/01/2021, 12h55 #234

aaaah l'insertion de son premier cpu dans la carte mere, la peur qui monte quand tu dois forcer, l'incompréhension quand après avoir forcé tu te rends compte ne pas l'avoir mis dans le bon sens. Souvenirs souvenirs.

Visual novel mélant romance et aventure, dans une Odyssée au cœur des mythologies, essayez Odyssian Blaze !

Prix du jury 2024 des Indie Game Nation !

-

03/01/2021, 13h27 #235

-

03/01/2021, 13h47 #236

Elle n'est pas fourni avec les alims (pour l'instant du moins), je l'ai eu dans le cadre d'une offre temporraire.

https://seasonic.com/request-12pin-cable

Je n'ai pas trouvé de page du produit ni de vente, mais ce sera peut-être vendu plus tard.

Corsair en vend un aussi.Dernière modification par Endymion ; 03/01/2021 à 19h34.

-

03/01/2021, 18h03 #237

Savez-vous si on peut être bottlneck par le nombre de RT core et/ou la puissance de ceux-ci ?

Je suis sur Cyberpunk avec un 2700x avec 32 go de ram et une 3080. Tous les réglages au max, psycho quand c'est possible et full RT en 1440p. DLSS en équilibré.

Certains passages exploitent peu ma 3080. 75 ou 80 % d'utilisation. C'est un cas classique de bottlneck CPU.

Le truc c'est qu'en désactivant le RT sans rien toucher d'autre mes fps augmentent fortement. L'utilisation gpu elle baisse encore un peu. Comme si la puissance RT était trop faible par rapport à la rasterisation et qu'une fois le RT désactivé la puissance de rasterisation s'exprime du mieux qu'elle peu (toujours bottlneck par le 2700x chez moi).

Sinon l'autre hypothèse que j'ai c'est que le RT consomme de grosses ressources CPU et que sa désactivation laisse plus de place au CPU pour préparer les frame de la rasterisation classique.

Autre hypothèse les cores RT ne sont pas assez puissants / nombreux et une partie de la charge RT est basculée sur les cores cuda. Mais dans ce cas pour une charge GPU "basse".

J'ai fait aussi ce post sur le topic des configs de cyberpunk dans Jeux sur PC

-

03/01/2021, 20h25 #238

Dans le même genre de questions techniques.

Est-ce que vous savez si il y a un moyen d’évaluer les perfs de sa CG et de les comparer à des CG équivalentes ? Un soft de bench avec une BDD derrière ?

Un peu de contexte, j’ai une 2070 Super (KFA2), je joue en 1440p et en général je lock les fps à 60 en jeu (écran 160 Hz GSync compatible sinon). Je suis assez étonné des concessions graphiques que je dois faire sur les derniers jeux, à savoir forcément activer le DLSS (Cyberpunk et Control) et désactiver le RTX sous peine de ne pas tenir les 60. Ex Control DLSS activé et RTX Medium, je plafonne à 50 fps en High dans un environnement calme. Pour avoir à peu près 60 sur AC Valhalla, DLSS et Medium obligatoire.

Donc j’essaie de comprendre si c’est normal (début d’année la 2070 super était normalement la CG taillée pour cette réso) et si je veux mieux je dois passer au dessus, ou si j’ai vraiment un problème de perf. A noter que le reste se tourne les pouces : 3700X en général à 20-25%, 32 Go de RAM à 3200 Mhz.

Autre point à noter, en plus de mon écran 2k, j’ai un second écran 1080p 60 hz connecté mais qui me sert en bureautique (ex page web ouverte en jeu). Je ne pense pas que ça impacte de façon significative les perfs en jeu ?

-

03/01/2021, 20h30 #239

Vite fait de tête comme ça le kombustor d'afterburner propose ça si je ne me buse.

-

03/01/2021, 23h20 #240

Répondre avec citation

Répondre avec citation