Normal, si tu va au bout de sa logique, meme une IA parfaitement éthique s'attaquerait à son gagne pain, donc il trouvera toujours un angle pour essayer de les rejeter

Affichage des résultats 4 441 à 4 470 sur 5247

-

23/03/2023, 14h07 #4441Grand maître du lien affilié

-

23/03/2023, 14h08 #4442

Le fond du problème c'est pas que l'on entraîne des modèles avec des images sans l'autorisation de leurs ayants droits, mais que ces modèles servent à générer des images de haute qualité. Si le résultat était pourri, ça ne serait un problème pour personne en pratique.

-

23/03/2023, 14h28 #4443

Ahlala tompalmer je voulais faire plus subtile

Mais oui moi ce que j'entends c'est "ça me fait fondamentalement chier que les machines créent des trucs, donc tous les arguments sont bons pour objecter et tout ce qui en ralentit le développement est bon". On gagnerait à être un peu plus franc et honnête avec soi-même dans le débat.

-

23/03/2023, 14h37 #4444

Exact, la concurrence ne fait pas peur si tous les autres sont pourris

Grand maître du lien affilié

-

23/03/2023, 14h38 #4445

Question qui me vient naïvement en tête (qui a déjà du être posée des tonnes de fois): les réseaux actuels sont balèzes à reproduire certaines capacités humaines, mais sont chacun super spécialisé dans une tâche (discuter, créer une image).

Est-ce qua la techno utilisée permet d'espérer (je sais pas, en faisant x100 à la taille du réseau) à l'avenir des trucs bcp plus généralistes, ou bien non, il y a une limitation intrinsèque à cela et notre cerveau (qui lui est généraliste) ne fonctionne pas du tout de la même manière qu'un réseau de neurones numériques ?

-

23/03/2023, 15h00 #4446Banni

C'est le problème de "l'Intelligence artificielle forte" ou "Artificial general intelligence" en anglais. On en est très très loin. La génération de texte et d'image c'est beaucoup de poudre aux yeux parce que y'a pas d'impératif d'exactitude mais un objectif de vraisemblance, cf. l'algo de compression en JPEG par exemple. Ca a l'air de créer un gros biais chez certains canards car ce sont des tâches "humanisantes" je dirais, qui donnent une impression de complexité alors que ce sont des tâches assez simples.

Donc t'as beaucoup d'entrainements spécifiques aux tâches données, et c'est déjà extrêmement couteux en terme de performance/consommation pour ces tâches, avec des défauts difficiles à corriger, avec des tâches plus générales c'est encore pire.

D'ailleurs on le voit dans ton message "capacités" humaine, y'a une énorme différence entre le "mode de pensée" utilisé pour la génération de texte et d'image et la manière dont tu fonctionnes.

Typiquement les LLMs c'est grosso modo une statistique de vraisemblance token par token (disons mot par mot pour simplifier), mais toi quand tu construis une phrase tu fais un raisonnement logique et tu comprends la nature sous jacente du problème, pas l'AI. De même une AI qui glitche en générant une image, en fusionnant les doigts de la main etc. c'est parce qu'elle définit arbitrairement la structure d'une main, indépendamment de comprendre ce que la main représente (poing fermé ou autre) donc ça n'a rien à avoir avec comment tu dessines par exemple. Et ton sens de la vision est construit sur des déplacements dans l'espace en premier lieu donc un mode de pensée encore différent, sans compter toutes les illusions d'optiques classiques très étudiées pour reverse engineer comment le cerveau process les images. Et qui ne s'appliquent absolument pas à l'IA.

Typiquement une IA ne voit (computer vision) pas comme ça:

-

23/03/2023, 15h07 #4447

On a pas exactement la réponse je pense, j'ai vu des gens arguer des deux cotés, la mode en cours est à multiplier les paramètres pour avoir des résultats bien plus impressionnants donc ça laisse certains à penser #1, mais c'est aussi sur le dos d'une certaine façon d'organiser ces réseaux/un changement d'architecture.

Re des discussion precedentes, on a pas une parfaite compréhension du cerveau humain de toute façon, mais il semble raisonnable de supposer qu'il n'a rien de magique ou de non replicable, que ce soit avec les techniques actuelles ou leurs évolutions futures, donné suffisamment de temps.

Y'a de grodébats ces temps ci auxquels tu m'as fair penser entre les gens qui pensent que les progrès en IA sont dangereux

Un d'entre eux c'est une histoire de FOOM, ou de moment où on invente une intelligence suffisante pour qu'elle puisse s'auto-ameliorer et devenir arbitrairement plus puissante et intelligente, de la vitesse a laquelle ça irait, et de si c'est un scénario vraisemblable. C'est important pour les débats sur la sécurité parce que si demain on invente une IA avec 1000 de QI et que le lendemain elle en a 100000 et est capable d'inventer de nouvelles loi de la physique, y'a assez peu despoir de pouvoir la contrôler par des moyens humains.

De l'autre côté tu as des gens qui font remarquer que y'a aucune raison de croire que ça existe. On a tous un certain niveau d'intelligence et la volonté de s'améliorer, c'est pas pour ça qu'on y arrive. Tu peux par exemple dire que la faculté d'inventer des lois de la physique est bornée à la capacité a expérimenter, donc si il faut construire le LHC pour apprendre de nouvelles choses, ça va prendre un peu plus de temps à la super IA. Tu peux aussi argumenter qu'une entreprise est une forme de superintelligence, Carrefour est capable de faire des choses qu'aucun humain ne serait capable de faire elle-même, elle vise aussi à s'auto-ameliorer, mais reste qu'elle subit des coûts de coordinations et des contraintes qui font qu'elle ne va pas magiquement se mettre à dominer le monde ou le marché.

Bref, ya beaucoup de philosophie non-solvable et de "foi" derrière ces sujets je trouve, tu peux penser ce que tu veux mais ça suscite des interrogations intéressantes.

Un exemple de discussion sur ces sujets: https://richardhanania.substack.com/...youre-going-to

-

23/03/2023, 15h41 #4448

Autant je suis d'accord sur le fait que beacuoup de gens se font berner et que c'est facile de l'être, autant je te trouve vachement présomptueux sur pas mal de trucs.

"Comprendre l'essence d'une main" ça fait très magie pour moi. Mon intelligence c'est aussi l'activité que tu decris comme machine de voir suffisamment de trucs pour en décrire un modèle sous-jacent. Je dérive pas d'une causalité logique exacte ce que c'est qu'une main valide, j'ai juste un modèle de ce que c'est dérivé de la somme de mes experie'ves.

Je trouve que ça se voit sur la transferabilité des competences. Par exemple t'as des LLMs qui deviennent meilleurs pour générer du portugais ou du code en apprenant plus d'anglais. Même chose pour des transferts multimodaux. Ça parle d'une applicabilité universelle qui est pas exactement la revendication que tu prends, et que je trouve assez logique car il s'agit de construire des abstractions et de faire des parallèles, et c'est dans ce sens que je decrirais l'intelligence.

On est bien sûr pas au niveau de répliquer l'intelligence humaine, mais je suis pas sûr qu'on soit en mesure d'affirmer que ce que font ces modèles soit radicalement et fondamentament different. Perso j'en sais rien et je vois pas d'argument qui tue pour l'affirmer.

D'ailleurs les IA generatives de ont arrêté les mains à 6 doigts avec juste plus de paramètres et d'entraînement.

-

23/03/2023, 15h49 #4449Banni

Bah c'est typiquement parce que t'as jamais travaillé avec un parameter space pour les formes, donc la génération de forme ça te parait impressionant. Mais si tu simplifies ça à la quantité de données contenue dans une forme tu verras que c'est pas plus compliqué de générer/parametriser des formes que de générer des couleurs par exemple.

Bref t'façon mon post allait même plus dans ton sens en terme d'optimisme que tu ne vas dans ton sens lol. Y'a d'autres application de l'AI dont on ne parle pas et peut-être plus impressionantes comme ça par exemple: https://www.eejournal.com/article/10...-and-counting/

Les layouts de CPU AI powered

Donc ça montre bien que vous êtes biaisés envers certains types d'applications sans aucune justification autre que ça vous parait impressionant, que c'est grand public, etc. et tout un tas de facteurs, bruit médiatique, qui n'ont rien avoir avec l'essor des applications neural network au sens large.

On sait très bien que c'est fort pour certaines classes de problème et c'est aussi un moyen brute force de résoudre des problèmes sans les comprendre, donc de la puissance de calcul pour faire de l'analyse c'est un concept attirant effectivement, automatiser l'analyse, mais de la à partir dans les délires de remplacement d'emploi etc. c'est préférer être dans l'extrapolation racoleuse que l'analyse objective

-

23/03/2023, 16h27 #4450

Ce qu'on peut dire, à ma faible connaissance du cerveau humain, c'est qu'on fonctionne assez différemment.

Par exemple on a pas besoin de voir 100 000 images de chiens et de chat pour interpréter ce qu'est un chien et un chat. Du coup si je devais raisonner en bayesien je dirais qu'on doit avoir quelque part un "à priori" beaucoup plus fort que l'IA.

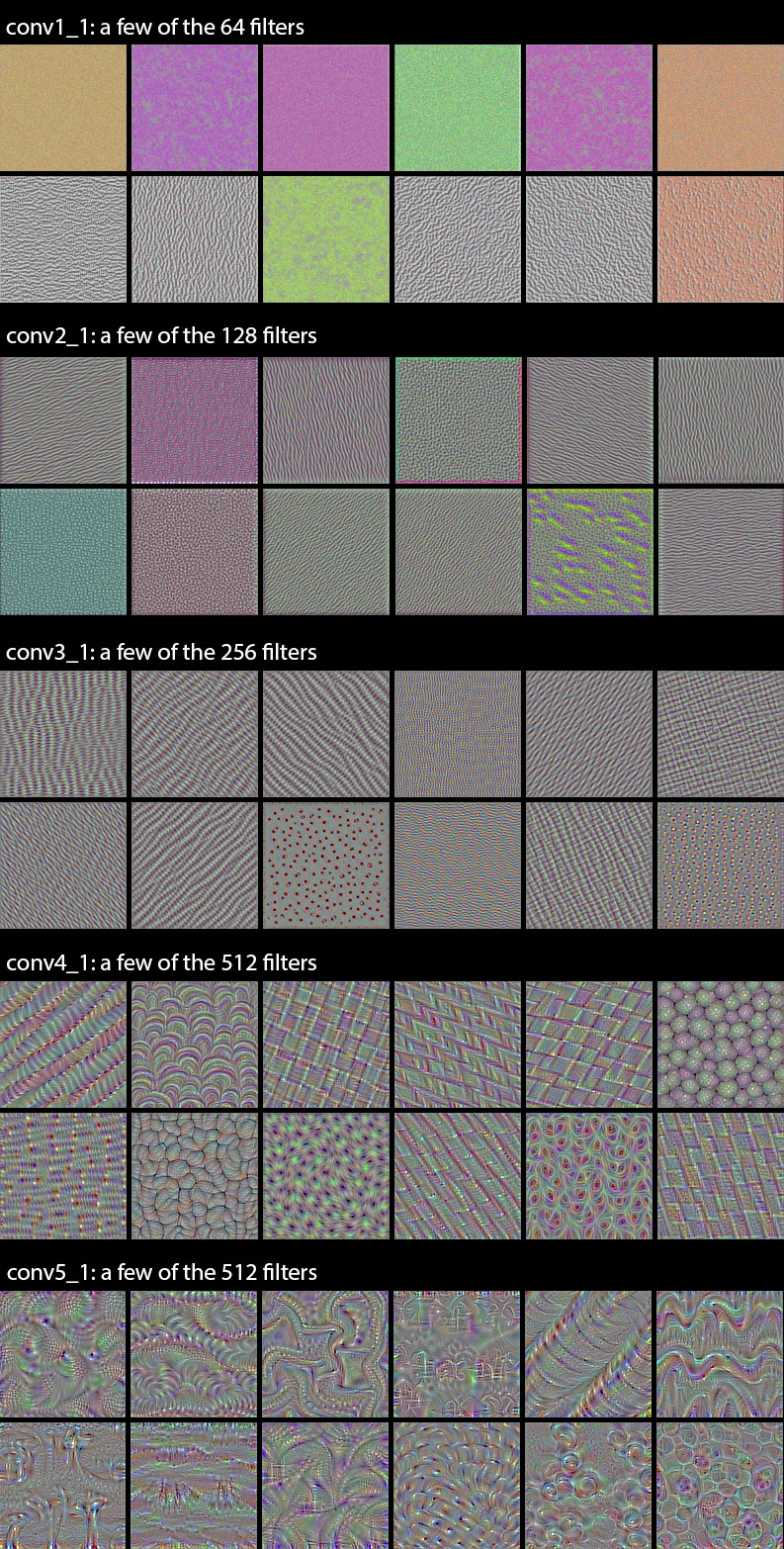

Par contre il me semble que le principe des CNN qui sont en gros des filtres déterminé par la machine de plus en plus fin mime un peu ce que fait notre cerveau (ceci dit je ne sais plus ou j'ai eu cette info )

)

Pour te donner une idée de ce que "voit" l'ordinateur on peut tracer les différentes couches d'un réseau profond, ça donne ça, et on voit bien que les première couche sont des pattern très généraliste et que ça se spécialise au fur et à mesure des couches.

https://blog.keras.io/how-convolutio...the-world.html"Les faits sont têtus."

-

23/03/2023, 16h40 #4451

C'est quand même incroyable d'avoir une réaction épidermique en mode "c'est parce que tu sais pas de quoi tu parles" à quelqu'un qui t'écris "perso j'en sais rien et je vois pas d'argument qui tue pour l'affirmer."

"la génération de forme ça te parait impressionant".. ben euh non? à titre personnel la génération d'image m'intéresse pas vraiment. Y'a quoi dans mon message qui dit ça ou qui utilise la caractère impressionant des résultats comme argument quelconque?

J'ai du mal aussi à voir où tu vois des délires de remplacements d'emploi quand j'écris "on est bien sûr pas au niveau de répliquer l'intelligence humaine", à qui tu parles?

"biaisés envers certains types d'applications", le truc le plus concret que je t'ai sorti c'est les doigts et c'est parce que c'est l'exemple que toi tu as choisi pour argumenter, j'en ai pas grand chose à foutre à vrai dire.

Les LLMs et autres IAs génératives sont intéressants parce que ce sont les exemples les plus ambitieux et pics de l'état de l'art sur la complexité/architectures/paramètres et efforts/données mises dedans mais c'est tout.

Je m'intéressais au ML avant le "grand public et bruit médiatique" que tu manies comme vague épouvantail, je vois pas trop ce que ça vient foutre ici non plus, on s'en branle de ce qu'écrit numerama.

Enfin bref, vu le ton je te laisse discuter avec nilsou entre sachants et sûrs d'eux, ça sera passionant.

-

23/03/2023, 16h55 #4452

-

23/03/2023, 17h23 #4453nul, pas d'avatar

- Ville

- vrette

"Je connais rien au sujet mais je voulais absolument dire que..." c'est pas forcément plus passionnant pour les lecteurs.

D'autant que je ne vois pas de "réaction épidermique" dans le post de kamikaze.

Par contre il y avait pas mal de condescendance envers Ze Pompon, avec les réponses en mode "lol il a peur de perdre son boulot alors il dit n'importe quoi".

-

23/03/2023, 17h42 #4454

Ton raccourci ne fonctionne pas, "perso j'en sais rien" ou pour quoter ma version longue "je suis pas sûr qu'on soit en mesure d'affirmer que..." ça n'est pas "je connais rien au sujet". C'est même tout l'inverse, moins tu sais et plus c'est facile d'avoir des convictions et 0 doute.

En l'occurrence affirmer que c'est trivial que ce que fait le cerveau et ces réseaux neuronaux en sillicone sont fondamentalement différent, c'est loin d'être une preuve d'expertise. Suffit de creuser un minimum le sujet pour voir que ça se débat et ça n'est pas évident, on sait pas. Tout le sens du message c'était de montrer des arguments du sens contraire, comme la transférabilité.

Et me fait pas dire ce que j'ai pas dis sur l'autre sujet non plus, je suis pas tompalmer, je lui ai posé des questions parce que je veux bien qu'on m'explique en quoi "c'est pas bien de le faire illégalement", "c'est pas bien de le faire en zone grise", "c'est pas bien de le faire en demandant la permission" forment un tout cohérent hors de "c'est pas bien de le faire", en l'absence de réponse j'aurais du mal à avoir un avis contraire.

-

23/03/2023, 17h57 #4455

S'il est déjà entraîné sur d'autre images certainement ceci dit ça demande quand même souvent des centaines d'images au moins, plutôt milliers à ma connaissance. Je pense qu'on reste quand même plus économe qu'une machine

. Après c'est toujours difficile à comparer parce qu'on pourrait rétorquer qu'on voit pas mal d'image à la seconde

. Après c'est toujours difficile à comparer parce qu'on pourrait rétorquer qu'on voit pas mal d'image à la seconde  .

"Les faits sont têtus."

.

"Les faits sont têtus."

-

23/03/2023, 18h35 #4456

OpenAI qui lance des plugins pour que ChatGPT puisse accéder à de l'info/lancer des opérations externes: https://openai.com/blog/chatgpt-plugins

- - - Mise à jour - - -

Et un papier de Microsoft hier que j'avais pas link mais ça m'a l'air de bon ton vu aujourd'hui : https://arxiv.org/abs/2303.12712

-

23/03/2023, 21h40 #4457

Salut,

En tant que chercheur sur le sujet, voici ce que je peux te répondre en tentant de vulgariser :

Sur le principe technique déjà : Le cerveau humain fonctionne très différemment des réseaux de neurones à la mode type OpenAI etc. Notre cerveau est constitué de centaines de zones spécialisés dont les règles d'apprentissages et le fonctionnement neuronal varie fortement, parfois constitués de dizaines d’espèces de neurones jouant chacun un rôle, avec énormément de rebouclage interne. Personnellement, je fais pas mal de modélisation neuronale de certaines parties du cerveau humain, ça n'a rien à voir avec des trucs comme OpenAI.

Encore plus fondamental :

Les équations de bases de l'apprentissage profond (utilisé par les modèles comme OpenAi et cie) sont incompatible avec la biologie, ce qui est bien démontré aujourd'hui. Donc on parle de réseaux de neurones, mais la parentés est de plus en plus lointaines. Il s'agit plus aujourd'hui d'outils mathématiques vaguement inspiré à la base des neurones mais ayant abandonné toutes idées de mimétisme sur le sujet depuis belle lurette. Du moins, pour ce type de réseaux de neurones.

Maintenant, ceci ne clôture pas vraiment la question :

En effet, il est tout à fait imaginable qu'une IA qui partagerait un substrats très différent donnent les même résultats qu'une IA qui serait un mimétique du cerveau humain, et de fait on sait reproduire certaines partie spécialisé du cerveau avec des IA à apprentissage automatique utilisant de l'apprentissage profond (deep learning) alors même que ces parties du cerveau n'utilisent pas du tout ça : la vision en est l'exemple le plus flagrant : on arrive à reproduire le fonctionnement des aires visuelles humaines avec du deep learning alors que cette partie du cerveau, qui est bien connue aujourd’hui utilisent des types d'apprentissages très différent dans la vrai vie.

Il faut comprendre que ce type de réseaux généralistes vient en quelques sortes apprendre à mimer ces parties, en interne, durant l'apprentissage qu'on lui demande. On voit émerger des choses très proche des petites parties du cerveau spécialisés, mais dans le réseau global. Le défaut c'est que c'est ... une approche extrêmement bourrine, de fait. Au lieu de pondre des parties spécialisés conçu par des millions d'année d'évolution pour être efficace, tu prends un gros blob et tu lui dit de retrouver le résultat, c'est faisable, mais c'est un peu sale de mon point de vue, et à mon avis, c'est un chemin très inélégant et inefficace (de fait : il faut des bases d'apprentissage énorme, là ou un gamin fait aussi bien avec un nombre ridicule d'exemple, on est vraiment pas sur le même fonctionnement). Chemin bourrin mais un chemin quand même ... raser une foret au bulldozer pour trouver son chemin, c'est une solution ... un brin bourrine et ridicule, mais parfaitement fonctionnelle.

La question c'est : est-il possible de pousser ces IA généralistes à reproduire 100% du raisonnement humain de cette manière. C'est un peu ce que tente des trucs comme OpenAI. Ils se disent que si on fait apprendre une IA en lui demandant : apprends simplement à répondre à ce qu'on te demande. Point à la ligne. En lui demandant donc d'apprendre le futur de ce qu'il faut répondre en fonction du passé, bah on espère très fort qu'elle arrivera à construire en interne tout les concepts complexe qui font l'être humain, sans passer par les étapes qui forment un être humain, et en priant pour que les parties qui émergent soient proche de notre mode de pensées.

Honnêtement, c'est plus raser une foret, c'est raser une planète pour espérer retrouver le jouets perdu d'un enfant. Mais est-ce impossible ? Même moi qui suit très critique sur cette voie, je suis obligé d'admettre que c'est, d'une certaine manière, possible. À partir de toutes les connaissances de l'humanité il doit être possible de construire, par observation et mimetisme parfait, un être qui en sera le fruitet qui réagira comme un humain moyen (ou plutot comme la somme de tout les humains). C'est ce que tente OpenAI.

Le risque :

- Qu'ils atteignent vite un plafond de verre : en effet, même si c'est possible, imaginons, sur le papier, peut-être qu'il faudrait 1 milliards de fois la taille de leur réseau pour l’atteindre

- Que le réseau trouve un « minimum local » acceptable, c'est à dire un comportement qui simule correctement un être humain, mais qui, dans le fond, réfléchis tout à fait différemment : dans ce cas son coté pale copie sera toujours un frein à certaines application.

Mais ma foi, pourquoi pas regarder ce qu'ils essaient de faire.

Le plus dommage dans cette histoire, selon moi, c'est que c'est l'approche bourrine qui va attirer sur elle le maximum de financement et de regard. C'est très dommage et je pense qu'on peut faire pareil avec des réseaux beaucoup plus petit via une autre approche. Mais on ne le saura pas avant très longtemps je pense vu comme ce domaine est moribond par rapport au leur.

L'autre risque c'est de se retrouver avec un outil fort pratique sur tout les points, capable de mimer toutes réponses aux questions que se poseraient un être humain, mais fondamentalement inhumain dans le fond, et qu'on en vienne de plus en plus à se poser sur cet outil. Ce qui peut avoir des effets dramatiques divers.Dernière modification par Nilsou ; 23/03/2023 à 21h56.

-

23/03/2023, 22h28 #4458

C'est quand même légèrement chelou de dire que c'est "incompatible" et que "la parenté est de plus en plus lointaine" alors même qu'on a de plus en plus de neuroscience qui s'inspire de ce qu'on apprend en ML et vice versa avec des gens qui regardent comment marche le cerveau pour améliorer les archis de ML, d'ailleurs tu le fais toi-même dans ton post et t'as pas l'air d'y être étranger.

Genre tu peux pas lire un truc comme ça, qui fait des parallèles dans tous les sens et pointe effectivement les différences entre comment marche le cerveaux et nos archis de deep learning actuelles (difficile de faire plus iconique que GPT-2), mais donne aussi des idées de comment améliorer les archis de ML pour s'en rapprocher plus, et en conclure "ça n'a plus rien à voir depuis longtemps".

On a un nouveau paradigme d'architecture des réseaux neuronaux tous les 3 ans, si la différence avec comment marche le cerveau c'est "des zones spécialisées", "des dizaines d'espèces de neurones" et "énormément de rebouclage interne", pourquoi est-ce que ça pourrait pas être atteint de proche en proche en partant des architectures actuelles? C'est quoi exactement tes "équations de base incompatibles" et pourquoi est-ce qu'elles ne seraient pas adaptées dans la voie de recherche actuelle?

-

24/03/2023, 20h08 #4459

Ce qui est légèrement chelou c'est de venir répondre à un docteur en IA, en étant extrêmement sur de soi et sans remise en question, en mode passif agressif, quand il parle du cœur de sa discipline

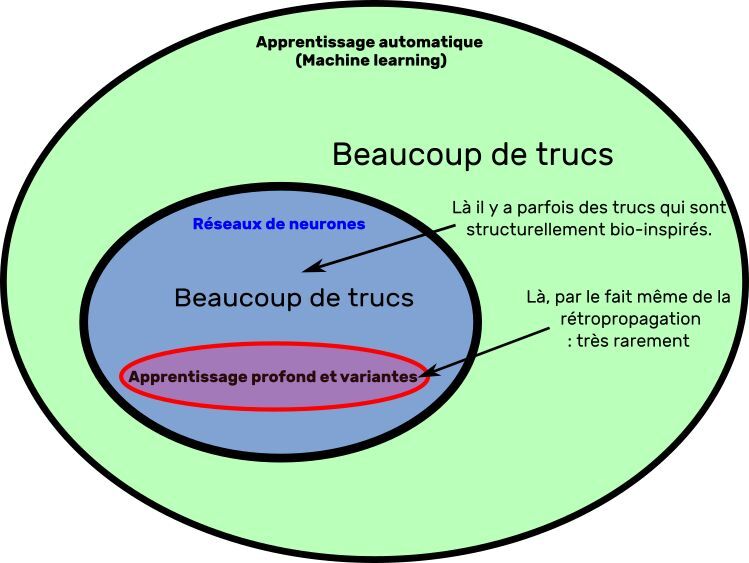

Surtout quand le docteur en question est l'une des rares personnes en France a faire spécifiquement du réseau de neurones bio-inspirés...

Lis en détail mon post avant d'écrire quoi ... je ne parle pas de « ML » (Machine Learning), mais d'un sous ensemble, le deep learning. Apprentissage profond et autres variantes utilisant la rétro-propagation du gradient de l'erreur. Mon post dis explicitement que certaines gamme des réseaux de neurones sont bio-inspirée, et d'autres pas.

Si ça va mieux avec un schéma, en voila un.

Spoiler Alert!

Écoute, à l'évidence, tu es incapable de lire un post pourtant détaillée. Je ne sais plus vraiment quoi faire avec ça...

J'explique en long en large et en travers dans mon posts qu'il y a deux notions bien distinctes :

1) L'aspect bio-inspiré ou non de la structure (lois d'apprentissage, modèles neuronaux, structure du réseau). Il là il n'y a aucune ambiguïté pour n'importe qui capable de lire un début de schéma de réseaux de neurones ou le début d'un papier de neurobiologie de base : la structure des modèles à base d’apprentissage profond est trèèèèèèèèèèèès éloignés du cerveau humain. Et c'est même voulu : on jette volontairement et en toute connaissance de cause toute proximité en terme de modèles neuronaux, avec le cerveau humain, dès lors qu'on emploi la rétropropagation du gradient.

2) L’aspect bio-inspirés ou non des fonctions reproduites par le réseaux. Le papier que tu cite en est un bon exemple, mais tout le deuxième paragraphe de mon post ne parle que de ça !

Je la rappelle à tout hasard :

Parce que c'est impossible, je ne vais pas faire un cours de 270h (puisque c'est le nombre d'heure de cours à peu près nécessaire pour que nos élèves, déjà bien introduit du sujet, commencent à saisir la chose) sur un topic en un post. C'est impossible parce que c'est équivalent à vouloir reproduire un vélo en partant d'une voiture sous prétexte qu'ils ont des roues et emprunte le même type de route pour la même finalité. Il n'y a presque aucun concept de base en commun.« En effet, il est tout à fait imaginable qu'une IA qui partagerait un substrats très différent donnent les même résultats qu'une IA qui serait un mimétique du cerveau humain, et de fait on sait reproduire certaines partie spécialisé du cerveau avec des IA à apprentissage automatique utilisant de l'apprentissage profond (deep learning) alors même que ces parties du cerveau n'utilisent pas du tout ça : la vision en est l'exemple le plus flagrant : on arrive à reproduire le fonctionnement des aires visuelles humaines avec du deep learning alors que cette partie du cerveau, qui est bien connue aujourd’hui utilisent des types d'apprentissages très différent dans la vrai vie.

Il faut comprendre que ce type de réseaux généralistes vient en quelques sortes apprendre à mimer ces parties, en interne, durant l'apprentissage qu'on lui demande. On voit émerger des choses très proche des petites parties du cerveau spécialisés, mais dans le réseau global.

La base même, le point de départ élémentaire, de TOUT les algos de réseaux de neurone par apprentissage profond, c'est qu'on mettre des couches les unes après les autres et qu'on utilise une équation pour propager de la fin jusqu'au point de départ l’erreur commise par le réseau afin de l'améliorer. Ce qui est très pratique puisque ça permets de pondre pleins de couche et de laisser faire le passage d'infos à rebours d'une couche à l'autre, mais ça n'a rien à voir avec le cerveau humain, qui ne dispose pas de tel mécanisme. Comme le cerveau humain ne dispose pas de ce mécanisme de base, ça fonctionne via d'autres mécanismes qui n'ont juste rien à voir. C'est aussi différent que l'aigle et la musaraigne.

Un algorithmique de réseaux de neurone bio-inspirées mimant le cortex visuel humain est ainsi infiniment plus compliqué, et infiniment plus contraint, qu'un algorithmique de réseaux de neurone par apprentissage profond. Ça n'a juste rien à voir de près ou de loin. Il n'y a presque que le mot « neurone » en commun, neurones qui n'ont eux même rien à voir.

Pour aller de proche en proche du deep learning aux réseaux de neurones structurellement bio-inspirées il faudrait faire tout en marche arrière, enlever toutes les propriétés de l'apprentissage profond, toutes les équations en base, toute la structure et les liens entre neurone, ne laisser plus qu'une bulle vide appelée « neurone » et refaire tout dans l'autre sens. C'est comme demander « est-ce que de proche en proche je peux faire un chien à partir d'un gink biloba ».

-

24/03/2023, 20h47 #4460Rien ne me choque moi, je suis un scientifique ! - I. Jones

-

24/03/2023, 21h13 #4461

Tu me réponds que je comprends pas que DL != ML alors que c'est genre le 101 du sujet et j'ai délibérément utiliser les deux termes dans mon message de façon bien distinctes et pour dire des choses différentes. Tu penses que y'a les deux dans mon message parce que j'ai jeter un dé pour choisir lequel des termes utiliser à quel endroit?

C'est pas pour rien que je t'ai sorti un papier qui propose des évolutions de GPT-2 et pas un papier qui n'a rien à voir avec des archis plus bio-mimétiques comme on les a dans certains axes de recherches. Je comprends très bien la différence entre ces approches là et le DL + les transformers auxquels on est arrivé, ma seule remarque c'est que les parallèles n'ont clairement pas cesser pour ceux qui travaillent sur ces archis là, sur un terrain un peu plus détaillé que le plombier qui regarderait le système sanguin pour s'inspirer parce que y'a une convergence de solution et pas d'architecture.

Je sais aussi très bien qu'il y a deux parties dans ton message, et je sais aussi lire. C'est pas pour rien que j'en quote qu'une partie parce que c'est celle qui me semblait douteuse et à laquelle je répondais, l'autre j'ai rien à redire parce que ça me paraissait clair. Tu crois que j'ai jeter un dé pour choisir quelle partie quoter?

Tu ne m'apprends littéralement rien dans ton post, t'es juste complètement passer à côté de ce que je voulais dire. Le problème, comme d'habitude, c'est que tu pars du principe que ton interlocuteur est un teubé incapable de comprendre quoique ce soit du haut de ton "docteur", "unique spécialiste en France", "peux pas discuter sans 270h de cours"; plutôt que de laisser le bénéfice du doute en te demandant "qu'est ce qu'il a bien voulu dire?". Y'avait 29 façons d'interpréter mon messages, et tu choisis celle qui inclue que je comprends pas ce que c'est le deep learning et que j'ai pas lu la moitié de ton message.

Si t'es pas foutu de comprendre ce que je veux dire et de m'expliquer des concepts alors que je peux te confirmer que j'ai passé bien plus de 270h à me renseigner sur le sujet et que je pars de plus loin que tes étudiants, je les plains. Je suis pas "sûr de moi", mon point sur toute cette discussion c'est littéralement de dire que c'est bien présomptueux d'avoir des certitudes, et c'est pas des réponses pareilles qui vont me convaincre du contraire.

-

24/03/2023, 22h08 #4462

Merci pour vos nombreuses réponses, je lirai tout ça ce week-end !

[Edit] bon ce que je retiens c’est que le cerveau ne fonctionne pas pas pareil, que la techno réseaux de neurones actuelle pourraient peut-être réussir à mimer davantage des capacité du cerveau mais qu'elle est pas efficace pour un fonctionnement "généraliste" et que du coup ça demanderait une taille de réseau rédhibitoire.

Sur ce dernier point je me demandais aussi si le fait que cerveau ça soit un truc en 3D alors que les ordi sur lesquels tournent ces réseaux de neurones fonctionnent avec des transistors sur une surface 2D, ça n'avait pas quelque-chose à voir (par rapport au fait que ça demanderai 10^40 "neurones numériques" pour mimer un cerveau qui a infiniment moins de neurones).Dernière modification par Ze Venerable ; 26/03/2023 à 14h39.

-

25/03/2023, 15h04 #4463

La dernière vidéo d'Heu?reka revient sur les tenants et les aboutissants de la faillite de la Silicon Valley Bank.

C'est pas spécifiquement de la tech mais ça touche quand même pas mal le domaine.

C'est la faute à Arteis

-

25/03/2023, 17h57 #4464

Il y a un paquet de docteurs sur CPC accessoirement.

Sans remettre en cause les compétences de si ou mi, les arguments qui peuvent sembler d'autorité passent mal si on ne peut pas vérifier derrière.

Dans un autre registre, j'ai fait cracher ChatGPT au bassinet sur un problème relativement simple de scripts CMake autour des paquets. J'ai pas réussi à avoir une seule bonne réponse sur pas mal d'essais, mais je reconnais que les réponses avaient de la gueule (il fallait produire plusieurs fichiers liés entre eux). On voyait bien que c'était un cran au dessus de la recherche google de base, mais il reste pas mal de progrès à faire.

-

25/03/2023, 18h01 #4465Tyranaus0r

- Ville

- Bordeaux

-

25/03/2023, 18h09 #4466Banni

Nilsou est docteur certes, mais c'est avant tout le créateur du topic de l'IA sur Canard PC

-

25/03/2023, 18h34 #4467

Y'a tellement de couches qui me font chier dans ces arguments là. Même si on était dans un contexte sans pseudos et avec nos vraies identités, je trouve ça détestable.

Comment tu peux faire de l'idolatrie du titre de docteur et croire que ça rend tes idées incontestables quand y'a tellement de contre-exemples. Ca n'est qu'un signal. A la limite t'es RH et tu dois trier 300 CVs pour savoir lesquels interviewer, OK, utilise donc ça comme heuristique. Tu dînes avec ta belle famille pour la première fois et veut faire classe, OK aussi. Mais quand tu parles d'idées, à quoi ça sert de balancer ça à part flatter ton ego? Plus tu connais un sujet mieux tu sais l'expliquer, RAF des credentials, je suis là pour apprendre des trucs, pas pour savoir à qui déléguer mon esprit critique avec déférence.

Suffit de passer du temps en labo pour se rendre compte que y'a de tout dans la population des docteurs, voire même qu'avoir bosser sur un sujet pendant 10 ou 15 ans est pas exactement un signe naturel de compétence ou d'expertise sur tout le domaine. Genre nilsou qui me dit plus haut qu'il consenterait à prendre mon opinion comme un gospel si j'étais "un chercheur en IA de 65 balais", mais affreux, ne faites pas ça, souvent ce sont les pires, y'en a tellement des comme ça totalement largués. Et je parle même pas d'un Einstein qui est compétent mais qui veut pas de la physique quantique.

Enfin bref c'est casse couille, j'ai l'impression qu'à chaque fois que j'essaie de discuter d'un sujet dans CPC ça part en outrage à agent et blessure d'ego parce qu'il est impossible de dissocier ses avis et opinions de son identité. Doit être moi qui suis pas dans le ton.

J'ai fait bosser un petit peu GPT-4 pour du dev web aussi (des chaines d'observables et du tricotage de RxJS), perso il se débrouillait plutôt bien mais faut itérer/lui passer du contexte/bosser des prompts. C'est pas super pratique quand tu dois t'amuser à faire des copier-coller et qu'il connaît pas le contexte de ton projet, j'attends de voir l'intégration dans VSCode avant de vraiment tenter de faire rentrer ça dans la façon dont je développe.

Je suis curieux de voir des comparaisons entre cas d'usage, quelqu chose me dit qu'il serait plus fort pour générer du OCaml que du JS sur le principe mais quelque chose me dit aussi que les données d'entraînement biaisent un peu de l'autre côté.

-

25/03/2023, 18h46 #4468Banni

Lol vous lui tombez trop dessus, y'a l'excès inverse aussi, on a des canards qui balancent des énormités sans rien justifier et sans argument d'autorité. A minima l'argument d'autorité ça permet de faire des raccourcis et d'établir une cohérence dans la discussion. Tu parles pas de la même manière à un enfant qu'à un adulte, l'âge c'est un argument d'autorité? Nan c'est de l'expérience et le respect a priori (des aînés). Chui pas pro argument d'autorité mais vous y allez comme jamais haha

On a une complaisance d'une part pour le discours médiatique tout aussi pauvre autour des IA et de l'autre on tabasse Nilsou sous un pont. Au pire demandez lui d'élaborer.

Le forum se prête pas trop non plus aux trucs trop compliqués car y'a plusieurs intervenants et topics et on se retrouve parfois à se répéter etc. on peut pas répondre comme dans une discussion à l'oral, c'est très lent

-

25/03/2023, 19h10 #4469

Bah écoute, dire "je trouve ça chelou" et présenter des arguments contraire, moi j'appelle ça "demander d'élaborer", avec le résultat qu'on a vu. Je mets pas de gants pour pas froisser les egos des vieux ou des gens avec Dr comme préfixe parce que c'est pas le sujet pour moi, ne pas être d'accord avec quelqu'un ça n'est pas lui manquer de respect.

C'est à partir du moment où tu mets ça sur de l'ego/bataille de CV que ça part en vrille, y'a pas besoin d'y aller. C'est même pas contre nilsou hein, sinon j'essaierais même pas de lui parler. Je comprends bien qu'il puisse en avoir marre de répéter la même chose tous les quatre matins à des gens qui comprennent rien au sujet mais bon, personne ne l'oblige et t'es pas obligé de prendre tout le monde pour un con à cause de ça.

Quand je coach un dev sorti d'école j'lui balance pas du "non mais je fais ça depuis 12 ans tkt te pose pas trop de questions", je lui explique les raisons. Même que des fois ça me met en face de contradictions. Même que ça me force à y réfléchir mieux. Même que parfois il arrive qu'il ait raison sur certains trucs.

Le prendre pour un gamin c'est perdant à tous les niveaux, tu peux faire ça avec ton neveu si tu veux mais bon.

Puis on en a déjà parlé mais j'en ai vraiment rien à battre du discours médiatique, littéralement la majorité de la couverture médiatique grand public de l'IA que j'ai vu passer c'est sur ce topic, je l'écoute absolument pas et je suis totalement déconnecté de ça. J'écoute des gens qui savent expliquer leur point de vue et le justifier, je me construis un avis petit à petit.

C'est pareil avec les canards qui balancent des énormité sans rien justifier, pour moi le choix il est entre les ignorer si tu penses qu'ils sont teubés ou essayer de leur expliquer si t'en as la patience ou si tu penses que c'est utile. Je vois vraiment pas de troisième voie qui serait "un raccourci", pour moi ça fait rien d'autre que rajouter du bruit/faire partir les discussion en vrille/diminuer la crédibilité des arguments.

-

25/03/2023, 19h12 #4470Banni

Ouais ouais, il a juste fait un post peut-être un peu de travers, la fatigue je sais pas, et on a 3 canards qui sautent de la troisième corde, ça va quoi lol, m'enfin on peut passer à autre chose

Répondre avec citation

Répondre avec citation