Intéressant, les Ryzen 7000 sont disponibles avec un mode ECO qui impacte assez peu les performances (quelques %) mais fait baisser la température de bien 10° et permet d'économiser 50-100W selon les modèles. De plus en plus, certains reprochent à AMD de ne pas en avoir fait le mode par défaut pour aller grappiller quelques pouillèmes sur des benchs. Vous pouvez par exemple voir l'impact de ce mode ECO sur comptoir-hardware.

Affichage des résultats 4 861 à 4 890 sur 4947

-

28/09/2022, 10h49 #4861

-

28/09/2022, 11h00 #4862

Je te trouve un peu enthousiaste sur le coup, le comptoir indique -33W sur le Ryzen 7 et -54W sur le Ryzen 9 le plus bourrin. C'est pas négligeable du tout mais ça fait pas 100W, surtout qu'il s'agit ici de deux puces "flagship" et que le reste de la gamme (Ryzen 5, Ryzen 3) qui sortira plus tard verra des gains beaucoup plus faibles.

Possible qu'ils aient besoin de cette surconso pour bien figurer dans les benchs face aux Intel. Possible que, comme Intel a aussi une conso élevée, AMD s'est dit "y'a pas de raison qu'on soit plus vertueux qu'eux". Possible, enfin, que le fait qu'Intel et AMD soient des sociétés américaines ne les incite pas à considérer avec sérieux les aspects consommation et à minorer l'intérêt de leur clientèle pour ceci. Après tout, ici en France et plus largement en Europe, on s'intéresse à ça et encore plus dans le contexte actuel de crise énergétique ; mais quid des marchés en Amérique, ou en Asie? Je n'ai pas assez d'éléments pour répondre.

Il est effectivement souhaitable, de mon point de vue français, de vendre le matériel avec le mode "éco" de base et le mode "hardcore" à activer volontairement. Mais j'ai aussi conscience que mon avis n'est pas partagé, ni en France, et à fortiori pas sur toute la planète. Si suffisamment de testeurs relèvent cela et que les clients crient suffisamment fort, peut-être que cet élément deviendra plus important aux yeux du marketing des fabricants.

On note quand même dans ce même test que ces puces, en mode "éco", ont la meilleure efficacité énergétique de tout le panel. Ca ferait un bel argument marketing ça aussi.

-

28/09/2022, 11h05 #4863

J'ai un 3700X et pour l'usage que j'en fais, je suis plus limité par la CG (GTX 1060 6Go) que le proco...

Donc moi, un mode éco ou "normal" m'irait très bien.

Je pense même que ce serait intéressant de voir du côté de l'undervolting (pour un usage avec les fréquences de base).

-

29/09/2022, 12h46 #4864

Juste une présentation de quelques mobos Gigabyte en B650 et B650E:

https://wccftech.com/amd-b650e-b650-...byte-pictured/

Ce que j'ai noté, c'est ça:

Evidemment, hors taxes, hors conversion.But as we get close to the Intel 13th Gen launch, AMD will finally open to doors to its B650E & B650 series motherboards. The new motherboards are designed for mainstream and budget consumers with prices starting at $125 US or so, as AMD has stated.

Mais ça pourrait laisser espérer des CM à 170-180€ en B650.

-

29/09/2022, 13h49 #4865

Mode ECO qui existe sur le Ryzen 5000 et dont personne n'a parlé ...

Après un test rapide sur ma plateforme : 5800x + B450 + 32 go de ram @ 3200

Mode Eco activé dans le bios (vendu pour du 65w au lieu de 105)

Conso relevée sur hwinfo ligne CPU Package Power

123 W en normal, 89 W en Eco soit -27,6 %

Perf sur R20

5872 vs 5542 soit -5,6 %

D'ailleurs mes score sont bas, je devrait être vers 6100 en normal, mais bon ça donne une idée.Dernière modification par Berk-124 ; 29/09/2022 à 14h18.

-

14/10/2022, 18h48 #4866

Pleurez pas mais nVidia ne sortira finalement pas la RTX4080 12GB.

Apparemment 100% de la presse spécialisée qui leur dit que c'est une honte de sortir 2 cartes avec le même nom et 25% de perf d'écart, ça a fini par les percuter. Attendez-vous donc à revoir ce GPU appelé RTX4070Ti ou 4070. Pour le prix cependant, pas sûr qu'nVidia arrive à justifier 900€ pour une carte de série 70 (ce qui était tout l'intérêt de l'appeler 4080).

-

14/10/2022, 21h43 #4867

C'est un peu étrange quand même comme décision. Il est clair que c'était gonflé d'appeler cette carte une 4080 vu les perfs de l'autre 4080 mais ce rétropédalage est surprenant.

-

20/10/2022, 15h51 #4868

Test du Core i9-13900K. En restant sur le même process (Intel 10nm), et en poussant la formule du 12900K, le résultat est bien un CPU plus rapide mais surtout catastrophiquement gourmand (300W+ pour un CPU

). C'est bien le roi des CPUs de joueurs mais les écarts sont tellement faibles avec un i5 et un i7, ou un Ryzen 7 et Ryzen 5, que je continuerai d'ignorer ce type de CPU outrageusement gourmand pour mes recommandations. Avec un watercooling de 360mm (3 ventilos) ils tapent la température max (=baisse de fréquence) en 17sec.

). C'est bien le roi des CPUs de joueurs mais les écarts sont tellement faibles avec un i5 et un i7, ou un Ryzen 7 et Ryzen 5, que je continuerai d'ignorer ce type de CPU outrageusement gourmand pour mes recommandations. Avec un watercooling de 360mm (3 ventilos) ils tapent la température max (=baisse de fréquence) en 17sec.

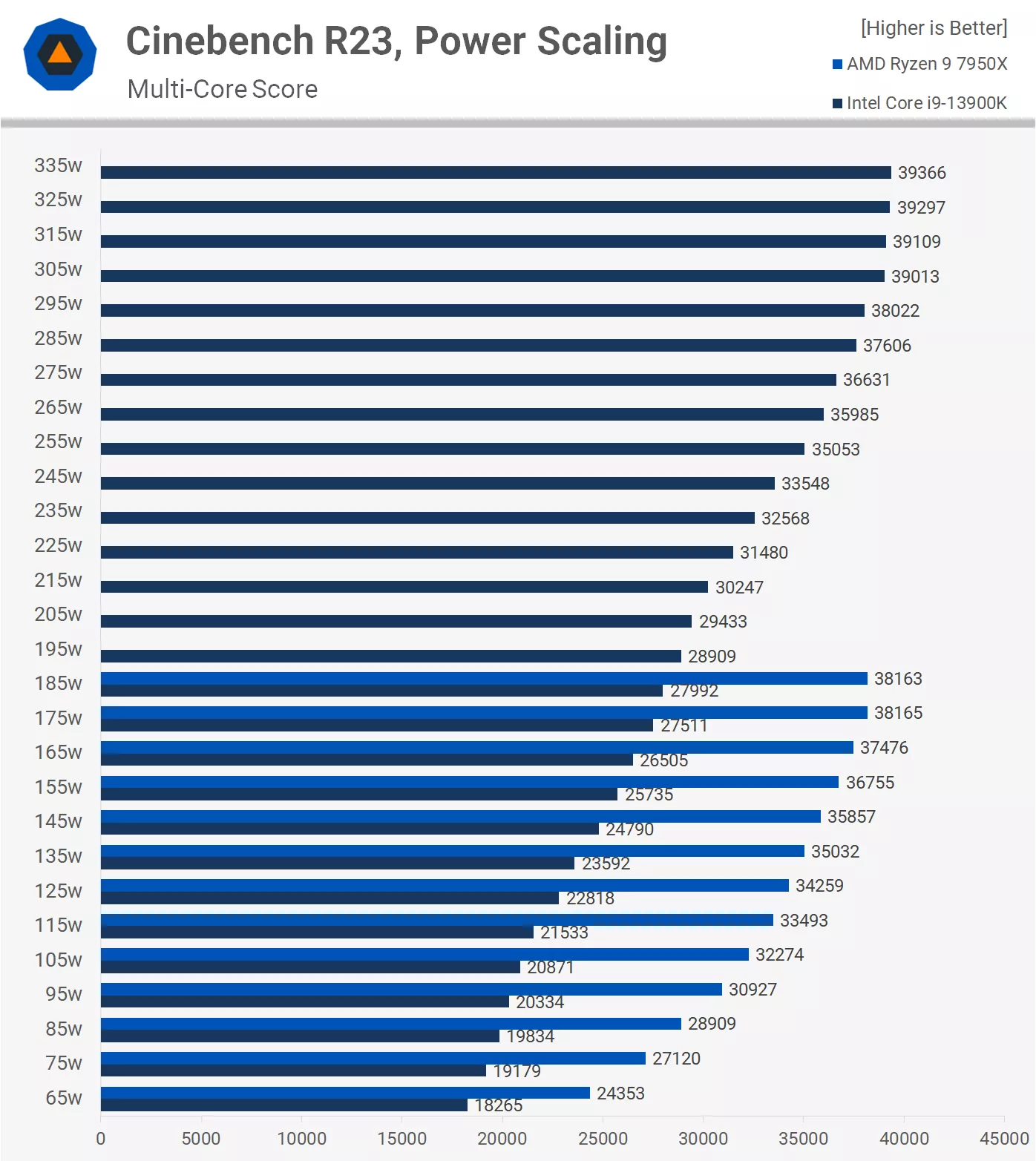

Une comparaison très intéressante des performances (sur Cinebench) par rapport à la consommation, comparé au 7950X d'AMD. On y voit l'avance considérable d'AMD en terme d'efficacité énergétique puisqu'ils obtiennent le même résultat avec 170W au lieu de 300W.

-

21/10/2022, 12h08 #4869

Le 13600K est cependant bien plus raisonnable (160W vs 110 pour le 7600X) et très performant. On y voit plus clair:

- 7600X: 370€ mais plateforme plus cher (à mettre dans la balance si on pense qu'on va la garder sur une prochaine upgrade)

- 13600KF: 430€ mais plateforme moins cher, surtout si tu as déjà la ddr4 (mais dernière génération de CPU dessus)

- 5800X3D: 470€, reste à envisager pour ceux qui ont déjà de l'AM4 et voudrait un dernier coup de boost avant de passer aux générations d’après

Aujourd'hui si quelqu'un monte un nouveau PC from scratch, je lui dirais de partir sur le 13600KF s'il le veut pour Noel (les cartes seront peut-être rebattues dans 6 mois) mais s'il a de l'AM4 et en dessous d'un 5000 (1000, 2000 ou même 3000) guetter les soldes sur le 5800X3D

-

21/10/2022, 13h50 #4870

Attention à considérer un Intel 13e gen avec la DDR4: j'ai vu un gap significatif dans les tests. Alors oui, t'économise la DDR5, sauf qu'une mobo DDR4 n'est pas DDR5, et qu'on a du coup un CPU 10% voire 15% plus lent (ce que j'ai vu sur le test du Core i9). Si après il faut changer mobo + DDR5 pour upgrader sa plateforme en DDR5, c'est pas un bon plan.

Tout venant de sortir, les prix des CPUs et mobos sont encore un peu trop frais. J'attendrai quelques semaines pour voir où chacun va se placer en terme de prix plateforme avant de pencher d'un côté ou de l'autre. 160W pour un i5 ça reste, à mon humble avis, hyper élevé. C'est plus qu'un Ryzen 9 à 16 cores de la génération précédente.

-

21/10/2022, 15h32 #4871

-

21/10/2022, 16h50 #4872

-

03/11/2022, 21h57 #4873

Voilà les prix sont tombés, 999 dollars pour la RX 7900 XTX et 899 pour la 7900 XT. Côté prix c'est une très bonne nouvelle. Niveau conso, ils n'ont pas joué la surenchère non plus, 355W pour la XTX et 300W pour la XT. On a eu qu'une idée assez vague des perfs par contre, mais même si la 7900 XTX n'égale pas la RTX 4090 la différence de prix est telle que c'est un positionnement très agressif.

Par contre ils se sont eux aussi abaissés à l'insertion de frames, le FSR 3.0 comportera lui aussi des images interpolées comme le DLSS 3...

-

03/11/2022, 23h32 #4874

-

03/11/2022, 23h39 #4875

-

03/11/2022, 23h54 #4876Tyranaus0r

La RTX 4090 reste seule pour ceux qui en ont besoin, en attendant une éventuelle 6950 XTXX chargée comme un bœuf aux hormones.

C'est surtout la RTX 4080 à qui ça risque de faire mal. Et la 6950 XT qui a 6 mois, et va devoir être bien bradée aussi.

-

04/11/2022, 07h33 #4877

Plutôt étonné pour ma part.

Je m'attendais au même type de surenchère que Nvidia, plus de perfs, plus de conso, plus de prix, plus de tout. A voir ce que ça donnera en vrai dans les tests, mais même conso, même prix, ça démarre plutôt bien.

Vite, sortez la 7800 !

-

04/11/2022, 07h40 #4878

C’est fou qu’on se réjouisse d’un haut de gamme a 350W et 1000$, c’est sur. N’oublions pas qu’avec le taux de change et la TVA le meilleur prix en FR sera 1200€ quand même. Mais bon, ca reste une carte hyper puissante visiblement, et pour la VR je regarderai attentivement la XT personnellement. Ca va peut-être ramener un peu nVidia a la réalité avec sa 4080 qui coûte le double de la précédente 3080…

-

04/11/2022, 08h48 #4879Tyranaus0r

Ouais enfin ça c'est un coup des génies du marketing. Ils avaient un beau package pour une carte qui décoiffe et voulaient se laisser de l'espace (et/ou tenter de pousser les gens à monter en gamme), mais c'était peut-être pas une bonne idée de l'appeler 4080.

Au final elle se retrouve face aux 7900 d'AMD qui est resté plus cohérent.

Faudra voir ce que ça donne quand ils descendent en gamme, le principal reste que ce soit bien réparti et homogène. L'idéal serait que pour des contraintes données (perf, budget, TDP, taille…) on trouve une carte au mieux des technologies actuelles, et pas un trou ou un piège.Dernière modification par 564.3 ; 04/11/2022 à 09h08.

-

04/11/2022, 10h51 #4880

Le haut de gamme ne dicte pas forcément le reste de la gamme, surtout qu'il suffit de jouer sur les prix à la baisse pour redevenir intéressant. Après il semblerait que les RX7000 coutent moins cher à produire que les RTX4000 grâce à leur modularité donc NVidia a peut-être moins de marge. Reste que ce ne sont pas ces cartes là qui m'intéressent, je suis curieux de voir les annonces au CES pour les modèles en dessous : RTX4070/RX7700.

-

04/11/2022, 14h17 #4881

C'est plus que fou, c'est du délire. J'ai même du mal à pas être insultant puisque tant qu'il y aura des idiots pour payer ce genre de prix le marché restera perché.

Règle de base, une carte graphique ne devrait pas coûter plus qu'une console moderne. 500 balles donc, et c'est déjà beaucoup trop. 300-400 balles pour le quasi-haut de gamme, 200-300 balles pour le milieu de gamme suffisant pour 99% des joueurs.

En même temps il y une vérité qui se dégage de tout cela, malgré la débauche ou est l’intérêt ?

Il est ou le jeu qui éclate les pupilles et qui justifie d'upgrader ? Finalement leurs merdes pourraient être à 5000 balles, c'est de beaux presse-papier...

-

04/11/2022, 14h29 #4882

-

04/11/2022, 16h05 #4883

L’approche d’AMD est intéressante avec son GPU en chiplets sur plusieurs nodes de fabrication. Peut-être cela leur permet-il de meilleures marges dans le haut-de-gamme et ainsi de concurrencer nVidia par le prix sans que ce soit une braderie, c’est à dire un prix inférieur mais une marge identique? Je souhaite que ca leur sourit. Vivement les tests pour voir ce que vaut RDNA3, puis les sorties de modèles plus abordables en effet, et qui concerneront plus de monde pour jouer en 1440p ou 1080p.

-

04/11/2022, 16h35 #4884

Suffit de voir la com' à coups de "4k120fps" et "8k60fps" parce que, comme tu dis, tu n'as rien sur PC qui soit fondamentalement plus fou techniquement que sur une console à 500-550€.

Avoir une config à 4000 balles pour faire tourner un jeu visuellement semblable (une comparaison image par image avec zoom permet de déceler les différences) à ce que tu as sur une Series X mais à 120fps au lieu de 60, faut le vouloir.

Sans déconner, on se retrouve presque dans une situation qui ressemble aux vieux trolls de JV.com avec les "PC gamer à 3000€" (alors qu'on était à ~1000€ pour un truc qui dépote en ce temps-là).

Et si on regarde bien, les dernières claques techniques, hormis MS Flight Simulator, sont carrément des (ex-)exclusivités console avec les Uncharted et The Last of Us, Horizon, God of War, et le dernier Ratchet & Clank.

Là je joue à A Plague Tale Requiem en même temps que ma compagne, elle sur PS5 moi sur PC. Alors, oui, je suis en 1440p/60fps (avec des chutes à 40, le jeu est hyper gourmand) quand elle est à 30fps, mais la 3080 m'a coûté une PS5 et demi.

On n'est plus du tout dans la même situation qu'il y a quelques années.

-

04/11/2022, 16h52 #4885

-

04/11/2022, 16h53 #4886

Et pas en natif. C'est du 1440p/60fps avec des drops ET le DLSS2 activé (en Qualité tout de même). Sinon c'est pire.

De très loin le jeu le plus gourmand auquel j'ai joué. Après, c'est aussi le plus fou visuellement... Gros gros taf au niveau de l'éclairage et des textures notamment.

Mais je pense que ça manque pas mal d'opti.

-

04/11/2022, 17h46 #4887

Je pense qu'il y a mal entendu. Est-ce que 1000 ou 900 balles c'est trop pour une carte graphique? Oui c'est trop, seulement il faut voir où en est le marché. Dans quel monde pensez-vous qu'une multi-nationale comme AMD va vendre son flagship à 700 balles quand son concurrent directe vend ses deux dernières cartes à 1600 et 1200 balles?

-

04/11/2022, 19h33 #4888

-

04/11/2022, 19h41 #4889Tyranaus0r

Pour moi ce ne sont pas des cartes "que" pour jouer. Quel jeu va exploiter 16+Go de VRAM ? Par contre pour certaines applications c'est intéressant.

Après il y a des enthousiastes qui en achètent pour aller avec leur matos VR à plus de 2k€ ou leurs supers écrans.

Voir des PGM qui pensent que plus ils ont de centaines de FPS, mieux c'est. Là AMD sort un beau package avec le display port 2.1 et les fabricants d'écrans qui vont se faire plaisir.

Edit: Ah voilà, ce slide m'avait bien fait marrer. Enfin sur son nouvel écran DP 2.1 flambant neuf, vaut peut-être mieux viser du 4k 480Hz que 833FPS en 1440p (900Hz max théorique).

Dernière modification par 564.3 ; 04/11/2022 à 20h02.

-

04/11/2022, 23h34 #4890

Répondre avec citation

Répondre avec citation