Y a eu un drop LDLC de nVidia ce we au fait.

Affichage des résultats 1 831 à 1 860 sur 6054

Discussion: [Cartes graphiques v5] Discussions et conseils

-

10/01/2022, 13h16 #1831

-

10/01/2022, 13h52 #1832Amateur de Petits-Gris

Les Drops de GPU à prix contenu, la puissance du Marketing ! LDLC LDLC !

-------------------------

FAMINE DE CARTES 3 D

Episode 452 - Une carte 3D dans la MAFIA Viet.

Stolen EVGA RTX 30 cards make their way to the other side of the planet

We have just been informed that a Vietnamese retailer who already appeared on our site as a vendor packing ultra-rare GPUs into minings rigs, is again in the spotlight of the Vietnamese gaming community.

https://videocardz.com/newz/stolen-e...etnamese-store

On sait que les vols de cartes graphiques existent. La preuve en est, nous vous avions déjà parlé d'un vol pour 336 000 dollars de GeForce RTX 3090 dans les usines MSI. Eh bien ce jour, c'est EVGA qui annonce que la cargaison d'un camion de livraison a été dérobée. On parle de centaines de cartes graphiques GeForce RTX 3000, même si la marque ne précise pas le nombre.

Le vol a eu lieu sur le trajet entre San Francisco et un centre de distribution de la marque dans le sud de la californie.

Voilà la communication de la marque à ce propos, en français dans le texte :

https://www.cowcotland.com/news/7952...u-vietnam.html

Le casse :

La prise :

"LORD OF RTX"

Nous vivons une époque formidable.

-

10/01/2022, 14h14 #1833

-

13/01/2022, 16h27 #1834

Un des 1ers test de 3080 12 Go :

https://www.guru3d.com/articles_page..._review,1.html

Je me doutais un peu du résultat. Si vous la voyez dans les graph au dessus de la 3080 ti, c'est parce que on y oppose une 3080 ti FE à une supprim x. Mais franchement c'est proche.

Cependant la conclusion que j'ai de cela c'est que du moment que vous ne donnez pas plus de jus à une carte d'architecture équivalente, vous pouvez ajouter autant de cores que vous le voulez, les perfs seront identiques.

Bref si vous offrez un TGP de 350w (30 w de plus) à une 3080 10 Go, a priori on aura égalité parfaite entre les 3 types de 3080. Sauf si limiter par le manque de mémoire ou la bande passante (ce qui est assez rare in game pour le moment)

Et les 3080 custom de l'enfer à 450 W de TDP sont dans les test équivalentes à des 3090 FE de 450W.

-

13/01/2022, 16h39 #1835

Et dans tous les cas, les écarts (3080 10GB / 12B / Ti / 3090) peinent à justifier les écarts de prix ; c'est de l'ingénierie de prix de nVidia qui cherche à tirer le max de tunes de chaque puce, se gardant bien de fournir à la place ce que les joueurs PC veulent vraiment (des GPUs abordables). A la place limite ils essaient de revendre des GPUs à ceux qui en ont déjà acheté (genre RTX3070 8GB -> remplacée par une 3080 12GB ). Y'a clairement pas de quoi s'enthousiasmer pour ce lancement...

-

13/01/2022, 18h14 #1836

Ils avaient fait une annonce en mode "Les 3080 12Go vont bientôt sortir, il n'y en aura pas pour tout le monde !"

Ben.. Au bout d'1h, elles étaient toujours là.

Moi je comprends pas comment les CG ont pu atteindre 2290€.. J'ai pas eu l'impression d'avoir rater le bus pourtant, je suis au courant de la situation à Taiwan etc mais quand même.

Il y avait une 3070 à 899€ à côté de chez moi, peut-être que c'était le prix normal.

Les occasions sur Leboncoin valent le coup ? Pour choper une 3070 ou autres.

-

13/01/2022, 19h29 #1837

-

13/01/2022, 19h29 #1838

Normalement non, la pénurie est telle que les cartes sont plus chères en occasion qu'en neuf.

Hier sur le topic de vente j'ai demandé une estimation de mon PC. On m'a dit que ma 3080 gaming OC (Gigabyte), modèle V1 donc non LHR, partirait à mini 1800 €.

Le modèle V2 est à 1350 sur LDLC et je l'ai payé 919 en novembre 2020. A l'époque on m'a dit que j'étais pas très futé d'acheté aussi cher ...

Je me rappelle d'un magazine qui comparait les CG en 1999. Il y avait une TNT2, une ATI (je n'ai plus le modèle), la voodoo 3 (2000 et 3000) et la matrox millenium G400 max.

Cette dernière m'avait marqué pour 2 raisons :

- ses performances exceptionnelles pour l'époque. Le test était plus qu'élogieux.

- son prix. Le test disait avec regret : "La barre des 1000F est maintenant dépassée"

1000F en euros avec l'inflation de 1999 à 2022 c'est 207 €. Soit 36 % d'inflation.

Mais sur les CG vu le marché actuel on est à 300 % d'inflation. De la folie.

Alors certe à l'époque on jouait en 800x600 ou 1024x768 avec un framerate dégueux, mais quand même.Dernière modification par Berk-124 ; 13/01/2022 à 19h44.

-

17/01/2022, 00h28 #1839

J'ai vu des annonces de 1050Ti à 300 voir 350€ sur LBC dans mon coin, les types doutent de rien... J'ai pris la même (une MSI) à 130 l'année dernière en urgence et déjà j'avais l'impression de me faire avoir (mais comme j'avais récupéré gratos l'ancienne tour d'un pote ça passait).

Je leur ai laissé un message disant que c'était "un peu" abusé et que ça partirait jamais.

-

17/01/2022, 08h49 #1840

Le marché est drivé par l'extrême en fait.

J'ai une 6900XT sur mon PC à moi et une 1060 3 Go sur le PC d'un de mes garçons.

J'avais déjà fait le test avec Horizon Zero Dawn et je l'ai refait ce we avec God of War.

En vrai en jouant on se rend compte que les tests à base de zoom X4 sur des morceaux de textures choisis pour aller dans le sens du propos, c'est de la flute intégrale.

Sur des jeux comme ca, je suis à 110 FPS en Ultra en 3440x1440 sur mon PC et à 60 FPS en moyennasse en 1080P avec le FSR sur l'ordi du p'tit, l'expérience de jeu est la MEME (une fois passées les 5 minutes à regarder le détail des feuilles le nez collé à l'écran.)

J'ai peut être pas les meilleurs yeux mais clairement je pense qu'on est parti, très docilement en tant que consommateur et moi en tête, sur une course à l'armement complètement dénuée de sens.

Les constructeurs, bien aidés par la presse et notre connerie (je le pense sincèrement) se font des couilles en or sur notre dos et déforment le marché de manière vraiment indécente.Dernière modification par Jeliel ; 17/01/2022 à 09h36.

-

17/01/2022, 09h32 #1841Amateur de Petits-Gris

Que dire de plus. Amen.

STOP AU SUR ARMEMENT, STOP AU CODAGE AVEC LE CUL.

Pour un second ordi, j'ai acheté une rtx 3060 nano, elle passe crème sur du 1080p. Largement.

La 4k toutafond, c'est du pur phantasme. Y'a que la Vr où ça peut être justifié.

Mais Soyez libres d'acheter de la RTX TsarBomba, les résultats boursiers de NVIDIA seront magnifiques.

Apple tartagueule à la récré !

-

17/01/2022, 10h03 #1842

Dans le genre, je lisais la news de la 3090 Ti que "tout le monde attend" qui est décalée de fin janvier à on sait pas quand. Sérieusement, c'est quoi l'utilité de cette carte à part les profits quand nVidia a déjà en haut de gamme une 3080, une 3080Ti et une 3090? Faut vraiment un GPU 3% plus rapide à 2000€ conseillé et 3000€ prix réel??

Je joue en 1440p, je n'ai pas encore constaté l'intérêt de ma 3080 par rapport à mon ancienne 2070S dans cette définition. Tous les jeux passent pareil: super beau et fluide. J'ai constaté un vrai gain en VR pour la simu de vol, et c'est pour ça que j'ai changé de carte alors ça tombe bien. Mais ceux qui upgradent une bonne carte qui fait encore le café en détails élevés vont être déçus à mon avis. Heureusement nVidia et AMD ont trouvé la parade: VSR / DLDSR qui permet de calculer le jeu en définition 2x supérieure, donc de bouffer 2x plus de ressources, pour l'afficher sur la même définition d'écran avec un poil de détails en plus... Ouah.

-

17/01/2022, 10h54 #1843

Je vais modérer vos propos.

Tout dépend de l'écran.

Sur ma tv 4k les jeux PS4 pro ou series X tournant ou se rapprochant du 60 Hz sont hyper fluides. La TV est une KS7000 de samung, recommandée à l'époque par eurogamer / digital foundry. Elle est en mode "jeux" pour réduire la latence et réglée entièrement comme le préconisait eurogamer.

Sur mon PC si je bloque à 60 Hz, clairement c'est pas aussi fluide. C'est pas un souci de config, c'est pas un problème d'écran car c'était pareil avec l'ancien. L'écran est bon, même très bon. AOC agon 241QG (1440p TN Gsync) ayant reçu de très bonnes critiques à l'époque.

Mais alors il se passe quoi ?

Et bien c'est assez simple, à ma connaissance les écrans PC sont totalement dépourvus de traitement d'image relatif à la fluidité. Or sur TV, même en mode jeu, une partie du traitement de fluidité doit rester active et certainement insère des images intermédiaires ou autre. Là je n'ai pas tout le détail, il faudrait en discuter avec des spécialistes écrans et TV.

Donc, et ça va être mon cas perso, sur mon pc, avec mon écran, en dessous de 80 Hz, je trouve que ça rame, au dessus de 100 Hz, je n'ai plus de problème.

Au dessus de 120 Hz, c'est pour le concours de quéquette :

* Oui : franchement en faisant des tests avec des personnes gamers, ne sachant pas quel est le taux de rafraichissement, je suis certains que personnes ne fera la différence entre 120 et 360 Hz, sur la fluidité pure. Les arguments sur l'input lag, sont à mon avis du bullshit (hormis en pro gamers éventuellement, quand il y a des enjeux financiers derrière).

* Non : selon les écrans, leurs capacités d'affichage sont meilleures à haute fréquence. Image plus nette, moins de ghosting ou reverse ghosting, d'overshhot, meilleur temps de réponse. Cependant suivant les réglages d'overdrive on peut trouver une image de qualité en 144/165 Hz ce qui est largement suffisant. Le problème c'est que certains écrans sont simplement dégueux entre 60 et 100/120 Hz.

Donc pour conclure, si j'ai mon arme de guerre actuelle (5800x+3080) c'est pour 3 raisons :

- Ne descendre en dessous de 100 Hz en High/Ultra (en évitant les réglages débiles qui bouffent 30 % de fps) qu'à de rares occasion. Oui ça arrive, lors de gunfight intense dans deep rock galactic ou outriders, cyberpunk, ...

- Assurer un peu le coup sur la Vram car j'ai des doute sur la pérennité des 8 Go de la 3070

- Assurer le coup quand je changerai d'écran vers de la 4k et/ou de l'ultra wide

Pour finir, un PC c'est un ensemble d'éléments qu'il faut choisir cohérents entre eux.

PS : je reviens sur la TV, le traitement d'image en mode cinéma permet d'avoir une image fluide avec un jeu 30 Hz. Problème il crée des artefacts sur certaines images et il implique généralement un gros input lag. Cependant le traitement d'image présent quand même en mode jeux, donne des résultat relativement agréable sur les jeux 30 Hz à 2 conditions :

- 30 Hz parfait avec un frametime bloqué à 33.3 ms

- une implémentation parfaite d'un léger motion blur (per object motion blur évidement). Exemple : uncharted 4 sur ps4 pro. Contre exemple assassin's creed odyssey sur PS4 pro.

- - - Mise à jour - - -

Je pense que tu voulais dire DSR et non pas VSR.

Et dans les 2 cas, DSR et DLDSR sont des implémentations dans le pilote AMD/NVIDIA de techniques d'upscale. Clairement ça va dans le bon sens, puisque cela permet de prendre une carte inférieure à ce que nécessiterait un écran en natif.

-

17/01/2022, 11h01 #1844

Non non: Virtual Super Resolution (VSR) chez AMD, et DLDSR chez nVidia, sont des techniques de downsampling utilisant une définition de rendu supérieure pour avoir une sorte d'über-anti-aliasing, au prix d'un jeu calculé en 2160p pour un affichage 1080p par exemple (donc un GPU qui crache ses tripes même sur un jeu pas hyper gourmand). D'un point de vue écologique, c'est une aberration absolue, puisqu'on va faire bosser la carte pour un affichage en 2160p mais que l'affichage ne se fait au final qu'en 1080p. Ou comment justifier un GPU de 450W pour tous.

Pour la fluidité, je parlais bien de pas voir de différence chez moi en 1440p 144Hz avec G-Sync activé. Que je sois à 80fps ou 120fps en G-Sync, franchement, je vois pas d'écart. Idem entre du Ultra maxi ou du Très élevé, c'est généralement insensible sauf à vraiment rechercher le détail et en sachant ce qu'on recherche à l'écran (une ombre plus douce, un cheveu qui bouge différemment dans le vent...).

-

17/01/2022, 11h12 #1845

OK, j'avais mal lu les news à ce sujet.

Sachant que le downsampling est présent dans les drivers Nvidia depuis des années sous le nom de DSR

https://www.nvidia.com/fr-fr/technologies/dsr/

-

17/01/2022, 11h16 #1846

Oui, le DLDSR est juste la nouvelle version. Déjà le "Rendu de qualité 4K sur écran 1080p" est un putain de mensonge: à la fin rien ne remplace une dalle de qualité, et si tu n'as pas les pixels, le DSR ne va pas les inventer. Je ne nie pas un écart visuel, je m'insurge du prix à payer. En gros on dit à un type "tu as un écran 1080p, tu pourrais jouer tout à fond avec une RTX3060 et consommer 180W pépère, mais non, utilise le DSR, achète une RTX3080 du coup sinon ça va ramer, et consomme 350W à la place". Un superbe outil pour encourager à la surconsommation, et à l'achat de la carte, et lors de son fonctionnement.

-

17/01/2022, 11h19 #1847

Gync activé, je préfère resté au dessus de 100 Hz, et je suis certain de me rendre compte de chaque baisse sous les 80 Hz.

Pour les réglages, ultra est 99% du temps useless. Par contre si on part sur du low/medium/high/ultra, le passage de medium à high à parfois un gros impact. C'est parfois plus visible sur des jeux avec des passage plus "lents". Par exemple la qualité des ombres ça peut vite ce voir dans un jeux avec beaucoup de cinématiques. La distance d'affichage ça se verra beaucoup sur des open world avec beaucoup d'élément qui "pop".

- - - Mise à jour - - -

Depuis le début je ne comprends pas qu'il ne propose pas d'upscale avec ce truc...

-

20/01/2022, 09h18 #1848

La 3090 ti sera semble t'il vendu autour de 3600 €. Et ça c'est sans l'alim de 1000 W qu'il faut derrière.

https://www.techpowerup.com/290999/n...cing-in-europe

Alors bande de gueux vous n'allez pas l'acheter ?

Edit :

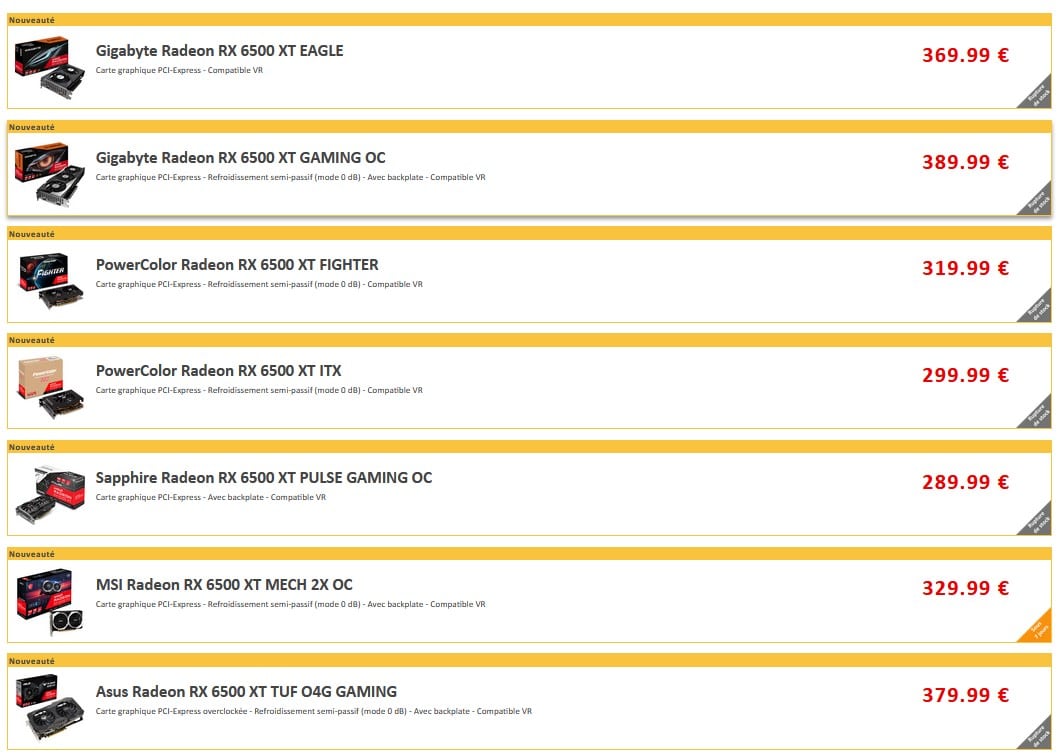

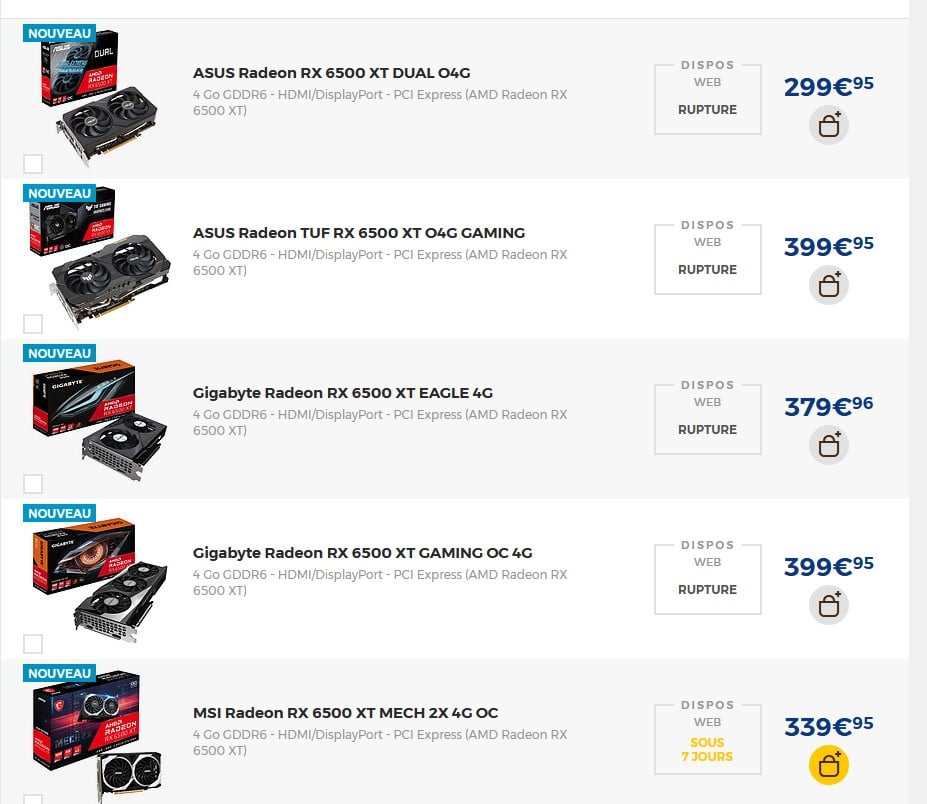

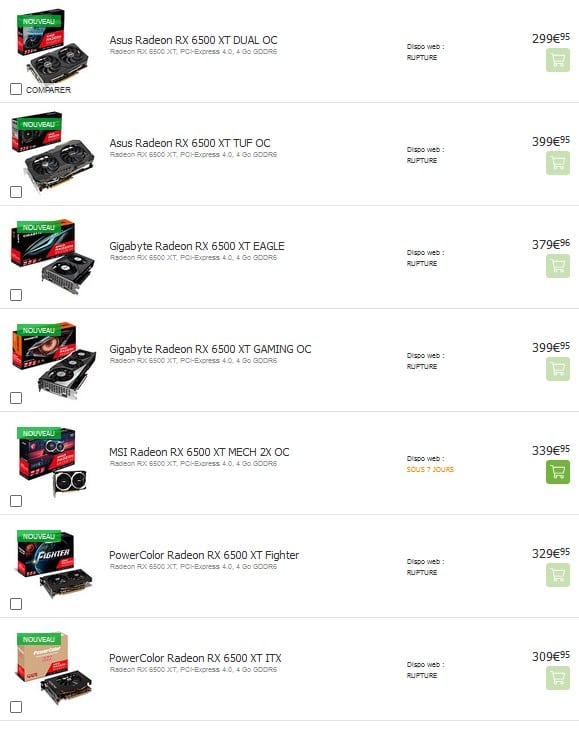

Merci SVP d'alerter au maximum les personnes venant se renseigner sur le forum que la 6500XT 4Go est une carte catastrophique et qu'il faut absolument l'éviter. Dans le meilleur des cas ses performances restent légèrement inférieures à la 5500XT. Généralement c'est très en dessous. En gros on a une carte qui se situe entre une GTX 1650 et une RX 580 ... vendur entre 300 et 400 € sur LDLC.

En cause elle est cablée en PCI-E 4.0 en 4X.

Ca serait un problème mineure s'il elle était équipée de 8 Go de VRAM, mais avec 4 Go, la VRAM est vite saturée et la carte va donc demander appui à la RAM du PC en passant par le port PCI-E. La vitesse de liaison est donc ultra importante.

Surtout s'il est prise comme carte d'upgrade et qu'elle est montée sur une CM en PCI-E 3.0 les perfs deviennent ridicules.

Sur du PCI-E 4.0 c'est pas très bon non plus mais on évite la cata.

On rajoute

- la VRAM sur un bus 64 bit super lent

- l'absence du support de l'encodage matériel

- uniquement 2 sorties vidéo

sources hardware unboxed:

En moins de 50s dans l'intro il arrive à placer les 2 phrases suivantes

"This is the worst GPU release I can remember and i've been doing this job for more than 2 decades"

"The Radeon 6500xt is just so bad that i don't even know where to begin"

Dernière modification par Berk-124 ; 20/01/2022 à 10h15.

-

20/01/2022, 10h35 #1849

Honteux, une conso pas terrible malgré le 6nm, des perfs inférieures à une RX580 ou 5500XT pour la majorité des gens...Ils se foutent du monde.

-

20/01/2022, 10h45 #1850Amateur de Petits-Gris

ASUS TUF Gaming RX 6500 XT, est d'ailleurs annoncée à 349 €, et il est inutile de dire que ce prix n'est pas non plus tenu par les revendeurs...

-

20/01/2022, 10h51 #1851

-

20/01/2022, 10h56 #1852Canardeur

Probablement la même chose que ce qu'il pensait des mauvais écrans freesync : "c'est une bonne chose ça pousse les gens à devoir se renseigner."

-

20/01/2022, 11h02 #1853

-

20/01/2022, 11h22 #1854

Anvil Empires : http://forum.canardpc.com/threads/13...urs-de-Foxhole

Anvil Empires : http://forum.canardpc.com/threads/13...urs-de-Foxhole

-

20/01/2022, 13h39 #1855Amateur de Petits-Gris

La Radeon RX 6500 XT est officiellement indisponible.

Alors que nous évoquions un prix débutant à 299 euros en France, dans son communiqué de presse, AMD annonce un prix suggéré « à partir » de 210 euros. La firme ajoute que la « Radeon RX 6500 XT est dès à présent disponible chez les revendeurs mondiaux, et est signée par les partenaires historiques d’AMD, notamment ASRock, ASUS, Biostar, Gigabyte, MSI, PowerColor, SAPPHIRE, XFX et Yeston« .

Dans les faits, chez trois détaillants populaires comme LDLC, Top Achat et Materiel.net, la Radeon RX 6500 XT est déjà en rupture de stock. Quant aux prix, ils avoisinent les 300 euros, à une exception notable : Top Achat liste bien une Asus Radeon RX 6500 XT DUAL O4G à 210 euros !

Source : https://www.tomshardware.fr/la-radeo...ture-de-stock/

Cette époque !

Ce calibre de prix pour une 6500 TUF GAMING, GAMING ! Nan, mais dégages !

Nan, mais dégages !

-

20/01/2022, 13h46 #1856

On me dit dans l'oreillette qu'AMD lance un bundle pour la sortie de la RX 6500XT. Pas de jeux cette fois, mais un tube de vaseline offert à tout acheteur de la carte. Un second tube est inclus par le revendeur si l'acheteur paie plus de 300€ une carte dont les performances sont inférieures à une carte neuve à 150€ d'il y a 5 ans. On peut dire qu'ils ont le sens du commerce.

-

20/01/2022, 13h55 #1857

Anvil Empires : http://forum.canardpc.com/threads/13...urs-de-Foxhole

Anvil Empires : http://forum.canardpc.com/threads/13...urs-de-Foxhole

-

20/01/2022, 16h37 #1858

Je n'ai eu ni jeu ni mois offert sur une 3080 TI FE, on parle donc d'une double, voire triple douille là non ?

Whatever.

Whatever.

-

20/01/2022, 16h40 #1859

Choper une FE* c'est déjà comme gagner au loto, alors non.

*à son MSRPHow can I be lost, if I've got nowhere to go?

-

20/01/2022, 16h42 #1860

Pareil, pas eu de jeu offert avec ma 3080 Ti OC non FE.

On est trop riche c'est ça ?

Répondre avec citation

Répondre avec citation

Il fallait le voir pour le croire

Il fallait le voir pour le croire