Pour répondre précisément sur cette histoire de système limbique.

En tant que chercheur en IA je ne vais pas forcément rentrer dans le détail car c'est inffffiiiiiniiiie, mais en gros, les émotions vont au delà du simple « système limbique ». Ça c'est la première chose.

Ensuite, toute l'astuce de réseau comme ChatGPT consiste justement à NE PAS construire de zones différentiés (tels que système limbique, cortex moteur, cortex visuel etc.) et à laisser le réseau s'auto-construire ces zones en ne lui demandant que le résultat final.

Il est ainsi possible que ChatGPT s'autoconstruise un genre de système mimant les émotions humaines, sans système limbique.

Ceci étant dit, de mon point de vue c'est un chemin très complexe et peu efficient de laisser le réseau seul sans l'aider en différenciant des parties. Néanmoins force est de constater que sur ce chemin peu efficient ils sont allé plus loin que le reste sur la démonstration. Donc ... je ne mettrait pas un kopek sur le fait que l'absence de système limbique, ou de toute autre partie, empêche ChatGPT et autre réseau du même type, de finir par s'autoconstruire ce type de réseau en interne.

On verra.

Affichage des résultats 1 081 à 1 110 sur 1288

-

03/08/2023, 21h32 #1081

-

03/08/2023, 22h08 #1082

-

03/08/2023, 22h11 #1083

-

03/08/2023, 22h16 #1084

Certes. C'est juste pour mettre un warning au début de certaines réponses sur le fait que je résume mes connaissances sur le sujet. En faisant des analogies, des généralités et des raccourcis, mais que je reste dispo pour plus de détail. Détail que j'ai puisque je bosse dessus.

Par exemple sur le système limbique juste au dessus. Je fais une réponse courte. Mais on peut en faire un pavé détaillé, selon le bon vouloir du canard à qui je répond.

Bref, c'est une introduction, courte, mais certes répétitive et prétentieuse, pour résumer cela.

-

03/08/2023, 22h19 #1085Tyranaus0r

- Ville

- Bordeaux

-

03/08/2023, 22h25 #1086

Pourtant il avance à vitesse grand V avec des résultats vraiment ouf dans chaque conf où je vais. Perso ça m'en mets plein les mirettes dans chaque salon, même mineur.

Bon faut sortir un peu des sempiternelles domaines du traitement d'image, particulièrement chiant (mais majoritaire).

Dans certains salon où j'ai été j'ai pu re-tester le contrôle de bras robot et de jeux vidéo par la pensée . C'était magique.

. C'était magique.

Il commence à y avoir des prothèses pour handicapé avec lecture des impulsions nerveuses via réseau de neurones artificiels, alors qu'on commençait à bosser dessus il y a seulement une poignée d'année. C'est comme donner des coups de marteau dans un univers de polystyrène : partout où on creuse, il y a une grotte qui s’effondre devant nous.

Sinon perso j'adore faire des petits robots qui apprennent à marcher tout seul. J’espère un jour un partenariat avec les Machine de L'ile à Nantes (ou autre atelier de mécanique un peu doué).

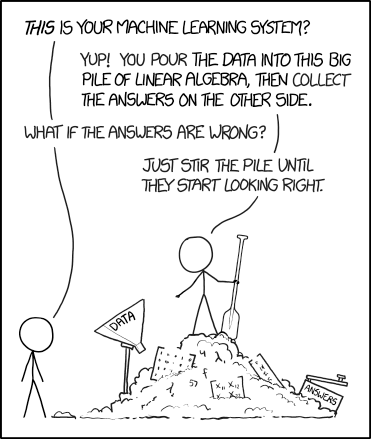

Et oui, tout ça c'est de l'avancement par essai erreur, c'est pas du tout cadré, pas propre et c'est 80% d’ingénierie. Les matheux le deteste . Mais ça marche.

. Mais ça marche.

-

03/08/2023, 22h30 #1087Tyranaus0r

- Ville

- Bordeaux

Sans doute, mais moi je suis arrivé à la science par les maths. Un truc qui "marche" mais sans qu'on puisse m'expliquer comment ni pourquoi, ça m'intéresse pas. TGCM, bof quoi.

-

03/08/2023, 22h46 #1088Banni

C'est le problème de l'argument de la chambre chinoise qui est bancal en premier lieu (s'pour ça que j'aime pas la vidéo, car c'est un peu se choisir un adversaire pour s'indigner gratuitement, alors que la chambre chinoise n'a jamais été un véritable centre d'intérêt scientifique ou philosophique. Alors que les expériences de pensée d'Einstein par exemple, bah si. Toutes les expériences de pensée ne sont pas égales). La compréhension est un des concepts avec la qualia, la considération, la conscience qu'il est difficile de définir.

Si on prend la définition la plus utile (au sens utilisable pour accomplir quelque chose), la plus objective possible pour la compréhension, qui est de dire que comprendre un système c'est d'être capable d'extraire les éléments qui caractérisent le système. Notamment pour être capable d'identifier A comme "le système" et B comme "pas le système"

Par exemple si je fais un algorithme, que ce soit via un réseau de neurone ou une approche classique. Pour distinguer des ovales de cercles, pour distinguer des formes de manière générale.

Dans le cas du réseau de neurone il est assez incontestable qu'il y a une compréhension de la forme cercle vs. ovale que tu peux même facilement analyser en observant la visualisation interne que le réseau en fait (explainable AI), et tu peux comprendre sur quelle feature le réseau se base pour élire Cercle ou Ovale en voyant une forme.

Avec cette connaissance tu peux même introduire des formes ambiguës/fringe qui vont être classées cercle alors que toi en tant qu'humain tu dirais ovale, par exemple si tu commences à introduire des courbes ouvertes, alors que jusqu'ici tu n'avais exposé ton réseau qu'à des courbes fermées.

Donc si vous réfléchissez vraiment au problème, vous verrez que la notion de compréhension est assez secondaire, car il semble vraiment qu'on puisse parler de compréhension en l'absence de conscience. Comment nommer les poids du réseau de neurone qu'on obtient, si ce n'est que par compréhension.

Faire un programme, c'est transférer une compréhension d'un système dans le programme. Donc quand tu fais genre un moteur physique (disons en 2D), tu transfères ta compréhension de la dynamique que tu souhaites avoir pour ton jeu, s'pas physiquement réaliste mais c'est en parfait accord avec ta compréhension intuitive de la physique (je lance une balle sur des quilles).

Y'a un autre argument qui est le classique zombie philosophique. Si on définit la compréhension comme la capacité à interagir avec un système. Par exemple le fameux corbeau qui semble comprendre le déplacement de l'eau, Archimède on y est presque

Il est facile de construire une machine qui va interagir "correctement" avec un système donné, donc est ce que la machine comprend?

Est ce que le corbeau comprend?

J'pense que parler de "compréhension subjective" c'est faire un amalgame.

Parce qu'on peut tous s'accorder à dire que y'a plein de phénomène qui sont compris inconsciemment. Par exemple l'effet de levier est un truc que tu vas utiliser étant gamin assez intuitivement. Sans pouvoir écrire l'équation de l'effet de levier

De même notre perception d'un environnement 3D, s'orienter, tout ça est supporté par tout un tas "d'algorithmes" mis à disposition par notre cerveau qu'on ne comprend pas vraiment (à titre personnel, on utilise tout un tas d'intuition dans la vie de tous les jours, qu'on ne prend pas le temps de comprendre nous même j'entends)

Si je vous demande "Vite! de quel côté il y a plus de balles", vous allez tous donner la bonne réponse alors que la différence de compte est assez minime. Comment t'as su que y'avait plus de balle à gauche qu'à droite? Une compréhension de la densité peut être, c'est dur à mettre en termes propres.

Donc si vous réfléchissez vraiment, je dirais avec une certaine "humilité" vous verrez que quelque soit le phénomène que vous choisissez, votre compréhension est plus floue que l'espèce de certitude absolue qu'on pense avoir parfois. C'est comme quand on explique un truc à quelqu'un et qu'on se rend compte qu'on a soit même pas si bien compris et qu'on arrive pas à transmettre la compréhension qu'on a.

De même si vous prenez un truc que vous compreniez étant petit, genre l'effet de levier ou la gravité donc vous aviez bien sûr une compréhension intuitive (les objets tombent). Et que vous étudiez votre compréhension actuelle, votre compréhension "améliorée"

Si vous essayez de qualifier les incréments qui vous ont amenés de votre compréhension initiale à votre compréhension actuelle, ça sera difficile de faire intervenir la conscience, ça parait vraiment purement mécanique.

Pareil pour les amnésiques, on a toujours la capacité à parler la langue par exemple, donc on a des compréhensions qui "subsistent" et quand on parle on réfléchit pas trop quand c'est notre langue natale.

Tout ça pour dire que je pense que parler de compréhension subjective/objective est assez problématique car c'est mal formuler la question qui ultimement revient au problème de la conscience. Car on a jamais qualifié la notion de compréhension en premier lieu. Indépendamment de l'adjectif qu'on lui affuble derrière.

Donc ce qui suscite mon indignation, pour rester poli, dans la vidéo. C'est qu'il s'invente un adversaire factice, passe à côté de vrais problèmes qui demandent un certain effort et de sortir du divertissement. Tout ça pour être très agressif à la fin (c'est lui qu'à commencé m'sieur!), où il s'invente un interlocuteur imaginaire et lui dit "ta gueule" (je cite la vidéo).

En disant qu'on sous estime les IA (à qui il parle, au contraire il m’apparaît qu'on a plutôt tendance à les sur estimer dans le grand public)

La plus grande force de l'IA, par le design qu'on en a fait, et DE FACTO de l'usage qu'on en fait, c'est ça capacité d'analyse qui permet de comprendre (lol quelque part) des phénomènes à haute dimensionnalité, difficiles à appréhender par l'esprit humain qui n'est pas fait pour ça (AlphaFold, etc.)

On pourrait dire que les humains sont les meilleurs pour comprendre ce qui fait un bon visage. Hors aucun humain au monde n'a programmé d'algorithme classique pour générer des visages humains. On aurait pu techniquement mais pour ça on est passé par un corpus et des réseaux de neurones.

Et pourtant on arrive toujours à dire "ah, ça ressemble à un visage fait par une AI", mais on a du mal à expliquer pourquoi. Est ce qu'on comprend ce qui fait un visage réaliste...? Pourtant on arrive à dire si un visage est réaliste ou non. Intuitivement?

-

04/08/2023, 09h03 #1089Le possible est ambigu. C'est juste une hypothèse ?Il est ainsi possible que ChatGPT s'autoconstruise un genre de système mimant les émotions humaines, sans système limbique.

Ou on a mesuré scientifiquement qu'à tel endroit du système des émotions étaient simulées ?

-

04/08/2023, 11h14 #1090

Il y un a truc qui s'appelle la physique, pas certain que tu aimes ça.

En général on ne comprend rien, on prend rapidement des fonctions avec lequel ça marche bien et on définit après (voir c'est d'autres personnes qui définissent).

La fonction de dirac est un bon exemple de ce processus et par extension probablement une bonne partie de la mécanique quantique au départ, encore aujourd'hui la physique statistique (qui est très proche de l'ia d'ailleurs) n'est pas réellement bien défini (probablement bien plus maintenant mais je doute que tout soit défini)

On te pause, par exemple ,l'hypothèse d'ergodicité et yolo.

C'est souvent vraiment le raisonnement inverse des matheux. On ne définit rien et on voit après coup pourquoi cette fonction marche et comment on pourrait éventuellement la définir.

Pour prendre un exemple de l'IA les fonctions d'activation en IA (lu, relu...).https://en.m.wikipedia.org/wiki/Rect...ural_networks)

On ne sait pas exactement pourquoi l'une fonctionne mieux que l'autre. Du moins pas au départ, et il y a des matheux/théoriciens qui creusent la question (très intéressante par ailleurs).

C'est pas pour rien qu'on dit que la data c'est parfois prendre un grimoire ésotérique et soupoudrer sans toujours bien comprendre, à l'intuition.

Combien de couches, l'agencement des couches, les fonctions d'activation, tout ça c'est assez yolo.

-

04/08/2023, 11h23 #1091

-

04/08/2023, 11h54 #1092

Le truc c'est qu'il y a comprendre et « comprendre »

.

.

Tu as déjà joué à Poly Bridge ? Tu devrais.

On peut comprendre le fonctionnement d'un système (en l’occurrence la construction de pont dans Poly Bridge), sans poser la moindre équation. En clair tu entraine ton esprit à raisonner dans le même univers que le problème posé. Et ... ça marche. On a construit des ponts, des édifices, des cathédrales, des millénaires avant de poser la moindre équations sur le sujet. Pourtant nul doute qu'il y a une forme de compréhension assez élevée du problème : au bout d'un moment tu sais le faire presque à la perfection, tu as l’intuition, pourrait on dire, de ce qui marche ou pas. Et ça va au delà d'une intuition, il serait plus juste de dire que tu ressens et maitrise le système en toi, tu es capable de le simuler à la perfection, donc de le comprendre.

On comprends que les objets tombent, et nul besoin de Newton pour ça.

Il y a des domaines techniques entier qui tiennent la dessus. Encore aujourd'hui en construction on pose bien peu d'équation : on SAIT que tel chose va tenir ou non, parce que le charpentier a tellement l'habitude et le ressenti du bois qu'il est capable d'en prédire le comportement. Idem, je suis technicien en Mesure Physique à la base. J'ai fait pas mal de thermo et de mécanique des fluides. Ce ne sont presque que des approximations assez grossière du réel. Au bout d'un moment on ne les utilise même plus, on sait qu'avec telle pente ça marche, qu'avec tel autre ça ne marche pas, et on est même capable de passer ce savoir « gros doigt », mais précis, à d'autres comparse, tout comme les batisseurs se formaient entre eux pendant des millénaires.

Et je ne te parle même pas de l’électronique (je suis ingé électronique, déso pour le CV) : en tant qu'ingé fonctionnant principalement par ma formation via les équations précises j'ai été surpris quand je suis arrivé dans la vrai vie : aucun technicien en électronique ne pose la moindre équation : il simule le signal éléctrique dans sa tête en fait, il « sait » que le flux passe comme ceci ou cela et se comporte ainsi avec tel ensemble de composant qui va le transformer comme cela. Il le comprends en fait, de manière bien plus profonde finalement que tout ce que j'ai pu apprendre comme équation. (même si c'est pratique, je m'en suis rendu compte, d'avoir la compréhension intuitive du système ET les équations, ce n'est nullement une obligation pour comprendre le système de manière profonde).

Et parfois, en sus de cette compréhension interne on développe des outils non équationnels pour mieux visualiser et aider à cette compréhension, et ces outils sont parfois d'une extrême justesse. (exemple : le modèle inversé de Gaudi pour la Sagrada Familia)

Touuuuuuuuuuuut ceci, c'est de la compréhension, véritable, qui parfois amène même à une bonne précision, et qui permets parfois d'avancer très vite dans la réalisation de choses concrète. Imagine un peu si il avait fallut attendre les équations précise pour comprendre que des arches c'est vachement bien pour construire des structures ... ou attendre la mécanique des fluides pour pondre des systèmes d'aqueduc complet.

Les réseaux de neurones, c'est pareil. Quand tu bosse dans le domaine et que tu es formé, au fur et à mesure tu développe une compréhension intuitive des flux d'information, assez similaire à l’électronique, qui circule dans un réseau. Tu lis un papier de neurobiologie et tu « vois » immédiatement comment le système va se comporter. Du moins, c'est mon cas. Ensuite, tu en extrait les composants qui te paraissent essentiels à la lumière de ta compréhension et tu le simule au fur et à mesure jusqu’à atteindre une compréhension visuelle et intuitive complète de l'élément que tu viens d'extraire de la nature.

Idem pour l'apprentissage, on sait comment le machin se comporte avec l’expérience, on sait vers quoi il va tendre en définitive en fonction du système et des lois utilisées (et on a une vérité terrain par bioinspiration). Nul surprise en général, parce qu'on l'a compris en amont.

Stricto sensu, on pourrait qualifier tout ceci d’ingénierie je pense, dans la mesure ou peu de chose distingue notre activité de la construction d'un édifices, même si on se base sur des prémisse scientifiques et qu'on en tire des conclusions scientifiques : quand on simule une partie du cerveau qu'on pense avoir compris, si il donne le résultat voulu ça donne une information précieuse sur cette partie du cerveau aux neurologues. Information qui pourra être utilisée à d'autres fins.

Je serais peut être plus sévère envers ceux qui ne font que construire des systèmes sans lien avec la neurobio, sans échanges avec les autres disciplines (ce qui est le cas des gens bossant en réseaux de neurone pour la reconnaissance ou dans les domaines tels que ceux attenants à ChatGPT) dans la mesure où on peut clairement dire que ce n'est plus que de l’ingénierie.

Mais ce n'est pas un problème en soit, l’ingénierie c'est cool !

-

04/08/2023, 12h16 #1093Tyranaus0r

- Ville

- Bordeaux

... tout ce pavé pour essayer de me convaincre que j'ai tort, alors que j'ai juste dit que ça ne m'intéressait pas. Et tu ne me feras pas changer d'avis, parce que ça ne correspond pas du tout à ma façon de fonctionner. C'est une position personnelle, pas grand chose de plus.

Je ne dis pas qu'il ne faut pas faire de l'IA, je ne dis pas que ça ne marche pas. Je dis que ça ne m'intéresse pas (un point que je sais que tu es capable de contester, mais tu ne devrais pas), et comme j'ai déjà eu l'occasion de le dire, je suis assez vieux et assez sénior pour pouvoir prédire que je n'aurai jamais besoin d'en faire

(Ça ne m'empêche pas d'accepter de faire quelques heures de TD sur de l'IA pour les jeux, parce que c'est juste de l'algo des arbres, et des réseaux de neurones, parce que c'est un mélange d'algèbre linéaire appliquée et de programmation, donc des trucs que je "comprends" en un des sens évoqués précédemment, à savoir, j'ai intégré un modèle assez complexe du truc pour me sentir prêt à le transmettre)

-

04/08/2023, 12h32 #1094

Ça dépends vraiment quelle définition tu prends. Si tu décide, comme le font pas mal de scientifique, que compréhension = phénomène mesurable. Alors c'est un équivalent de la performance sur une tache donnée, qui peut être de la performance brute (reconnaissance d'image par exemple), ou la capacité à leurrer l'humain (test de Turing). C'est un choix, tu peux ne pas être d'accord avec la définition. Mais c'est clairement celle là qui est usité dans certains domaine.

C'est ce que Mr Phi désigne par compréhension « objective ». Un phénomène mesurable.

Toi tu parle à l'évidence de compréhension subjective. Ou plutôt tu n'accorde de valeur qu'a cette compréhension subjective, du moins me semble t-il.

Si on prends cette définition (qui est la tienne hein, ça ne fait pas du tout consensus) alors ChatGPT comprends : il est capable d'identifier une sous partie d'un système dans une description du-dit système, de l'isoler, de l'utiliser, de la reproduire. c'est pas parfait, mais on ne peut lui nier une compréhension de certains éléments.

Il reproduit ta licorne par exemple, sans en avoir jamais « vu », ni en code, ni visuellement.

Pourquoi ?

Si c'est la notion dont on décide de discuter ? Pourquoi serait-elle assez secondaire ? Parce que le résultat te semble évident ? Il ne l'est pas pour beaucoup de gens. La discussion mérite d'être faites.

C'est quoi la conscience ? Qu'en sais-tu ? As tu une preuve que ton réseau ne neurone n'est pas conscient ? Si ça se trouve la compréhension EST la conscience, on en sait rien, et ton réseau est alors une entité consciente, des ronds et des ovales.

Oui ben tout ça c'est ce qu'on pourrait appeler la compréhension subjective.

Mais c'est ce que fait la vidéo nom de dieu

Elle tente de définir, en utilisant des choses déjà usités en philosophie, la compréhension. Pour se rendre compte qu'il y a deux manière de voir la chose. Soit tu parle du point de vue extérieur : je regarde le résultat sur la copie d'un étudiant et je suis content « il a compris a+b, il sera capable de le refaire », c'est une compréhension objective, un algorithme peut le refaire, je m'en fiche que ce soit l'étudiant qui réutilise a+b ou qui écrivent la copie en fait.

Soit je parle de la compréhension, pour citer Mr Phi et son très bon exemple, comme la compréhension du chaud et du froid (ce que tu décris toi même juste au dessus, la balle qui tombe, tout ça). Dans ce cas le mot « compréhension » signifie « avoir conscience de ».

C'est très simple en fait, le français est juste ambigu. Soit dans ta phrase tu peux remplacer le mot compréhension par « avoir conscience de » soit tu peux le remplacer par « est capable de » .

« Il a compris la résolution de l'équation » -> « il est capable de résoudre l'équation », c’est ce que j'attends de lui objectivement.

« Il a compris que le feu brule » -> « il l'a ressenti consciemment »

Mais on peux vouloir dire les deux dans l'autre sens, c'est juste un autre sens du mot comprendre. C'est juste le mot comprendre qui est ambigu.

De mon point de vue c'est tout le contraire : de un il traite 100% des problèmes dont on discute, tout ce que tu as expliqué dans ton post est précisé et bien précisé, dans la vidéo. Notamment le problème de définition du mot comprendre, le fait qu'on peut l'entendre de deux manière très différentes etc.

Donc il analyse le problème, identifie la source du problème et apport un éclairage (classique, mais pertinent) sur le problème.

Ensuite il ne se choisit pas du tout d'adversaire illusoire. Primo parce que l'argument de la chambre chinoise est utilisé très souvent dans le domaine grand public (dans les journaux, etc, mais également chez les philosophe invités sur les plateaux sur le sujet etc.) et de mauvaise manière, il réagit d'ailleurs à la vidéo d'un de ses collègue/ami (Defekator) en premier lieu, comme le montre la fin de la vidéo. Il ne se choisit donc pas d'adversaire imaginaire, il réponds à une tendance à utiliser de mauvais argument car justement on parle de chose très différente avec le seul mot « comprendre ».

Ensuite il réponds à un courant philosophique qui estime que les IA ne comprendront JAMAIS intuitivement, c'est à dire qu'elles n'auront jamais « conscience » des choses. Ce courant est porté par certains philosophe qui passent souvent dans journaux et plateaux. Il choisit le plus récent et le plus évident, en quoi c'est adversaire imaginaire ? Le mec existe, il passe à la télé, il est écouté. C'est son droit, et c'est justifié, de lui répondre.

Enfin il réponds à un courant qui mélange tout en jouant sur les termes du mot comprendre pour, en gros, édicté que la compréhension OBJECTIVE de ChatGPT et consort (de ce type d'IA en particulier) n’existera jamais et qu'on pourra toujours le mettre en défaut, du fait de la nature même du réseau. C'est le courant porté par Yann LeCUN. Courant très minoritaire dans la communauté IA et qui se plante systématiquement. Là aussi il a raison de pointer et de démontrer que Yann LeCun se plante profondément et totalement sur le sujet. En fait il se plante depuis le début, ça fait genre 5 fois qu'il fait des prédictions « jamais dans 1000 ans » et 5 fois que le machin lui donne tort le mois d'après. Donc voila, au bout d'un moment faut admettre : il a tort, profondément et totalement, il ne maitrise pas le sujet.

Même moi qui ait justement, acquis cette forme de compréhension un peu intuitive d'un réseau de neurone, je peux t'assurer que Yann LeCun a tort, et je pense que la plupart des chercheurs en IA le peuvent.

Donc là non plus, ce n'est pas un adversaire imaginaire, car il a une audience, il a une notoriété qui fait qu'il est écouté dans le grand public. C'est justifié d'en débattre sur une plateforme grand public. C'est informatif pour des gens n'ayant que vu Yann LeCun a la télé et considéré que ce qu'il dit est parole d'évangile.

- - - Mise à jour - - -

Ha ben ... si c'est juste que ça ne t'intéresse pas personnellement, je ne peux effectivement rien y faire.

C'est toutefois fort dommage de mon point de vue. Je trouve que tout est très intéressant dans bien des domaines personnellement ^^.

Puis sur « je ne devrais pas essayer », pas forcément d'accord haha. N'est-ce pas l'essence même d'un forum, et même de l'humanité (!) d'essayer d'intéresser les autres à ce qui nous intéresse

Dernière modification par Nilsou ; 04/08/2023 à 13h01.

-

04/08/2023, 13h12 #1095

-

04/08/2023, 13h28 #1096

Mais ils font déjà des pavés en face, c'est difficile de répondre plus synthétiquement en restant juste

Mais oui, sinon tu as raison.

-

04/08/2023, 13h46 #1097

Ce que j'essai de faire quand je parle des sujets qui m'interessent c'est de réagir que sur un ou deux points saillants.

C'est parfois frustrant parce que t'aurais à dire sur d'autres points, souvent même tous, et c'est pas facile de donner le dernier mot à quelqu'un quand tu penses qu'il a tort (genre au pif les chercheurs en IA qui parlent de la légitimité de certaines revendications chinoises). Mais sinon ça devient vite indigeste.

-

04/08/2023, 13h56 #1098

Je me pose un peu là, j'ai pas tout lu donc il va y avoir sans doute redite, mais je reviens aux moutons (littéralement), chatGPT n'a pas été exercé sur des jeux de données incluant des images ????

Ca ne me semble pas vraiment extraordinaire qu'il puisse reconnaitre un mouton.

-

04/08/2023, 15h27 #1099

Non pas d'image. Par contre potentiellement du code qui fait des moutons.

Mais je n'ai pas l'impression qu'il copie un code déjà appris mais bien qu'il a une sorte de compréhension de ce qu'est la forme d'un mouton. C'est ça qui est effectivement intéressant et pas forcément prévisible.

-

04/08/2023, 15h36 #1100

À partir du moment où le modèle de langage a été entraîné sur une tonne d'encyclopédies, de manuels de biologie, d'anatomie ou d'élevage, de romans et contes qui parlent de mouton, c'est pas très étonnant qu'il puisse décrire en détail ce à quoi ressemble un mouton (d'autant plus qu'il a dû lire des centaines de telles descriptions) et valider si une description correspond à celle d'un mouton.

-

04/08/2023, 18h47 #1101

Suivant de très loin le débat des dernières pages (dont je n'ai même pas compris le désaccord), je suis curieux de comprendre pourquoi tu dis que Le Cun ne maîtrise pas son sujet.

Je ne suis pas particulièrement familier avec ses prises de position, mais a priori il a un solide pedigree en matière d'IA.

-

04/08/2023, 18h59 #1102Tyranaus0r

- Ville

- Bordeaux

Le Cun fait des réseaux de neurones, ce qui n'est pas la branche de l'IA qui plaît à Nilsou (mais bon, c'est celle qui fait qu'on parle d'IA, faut s'y faire).

-

04/08/2023, 20h16 #1103

Il n'a pas reconnu, il l'a redessiné. Pour être précis.

C'est pas « étonnant » dans le sens où on sait qu'on irait de toute manière dans cette direction, oui. Mais techniquement ça veut dire qu'on a réussi à atteindre le point où il a réussi à comprendre le concept « mouton » et à en extrapoler même une image qu'il n'a pas vu, avec ce nombre de neurone donné et ce type d'apprentissage. Ce qui n'était pas forcément gagné (je le répète, l’apprentissage qu'ils font c'est un truc de GROS bourrin).

Techniquement c'est donc impressionnant, même si dans le fond ce n'est pas étonnant.

Et sur le fond plus philosophique ça veut dire qu'il a, d'une certaine manière, « compris », le concept mouton, qu’il est capable de bosser avec dans tout les sens etc. Ça ça en dit beaucoup, autant sur l'aspect philo qu'en pratique.

Hum, je pense que le plus simple comme exemple c'est que tu regarde la vidéo dont on discute depuis le début justement (posté par Orhin ici). Vu qu'on m'incite à rester concis ^^.

Mais sinon, de manière générale, il a fait de trés nombreuses prédictions depuis quelques années, qui se sont toutes retrouvé invalidée à chaque fois dans un très court laps de temps.

Sur le fond, du point de vue de moi et mes collègues où on essai de comprendre - ça va paraitre ridicule - le « flux » de comment fonctionne un réseau de neurone, on a aucun doute sur le fait que LeCun ne le comprends pas. Il dit trop d'énormité pour ça. Après, plus dans le détail, faudrait prendre une à une ses prédictions, ça peut être long. La vidéo donne un exemple concret récent pour exemple.

Ha ben si, je fais des réseaux de neurones moi. Pas forcément multi-couche par contre (je fais du bio-inspiré), mais j'use des réseaux de LeCun assez quotidiennement (bon pas trop quotidiennement dernièrement, trop de cours ).

).

La différence je pense c'est que LeCun est un créateur, plutôt coté matheux, d'outil. Il fait en sorte que ça converge, il démontre ceci etc. C'est là dessus qu'il est fort. Nous on manipule ces outils et de nombreuses autres variantes bio-inspirés (convergence non démontré mathématiquement, bien souvent parce qu'impossible à démontrer actuellement) pour construire des ensemble qui aboutissent à des comportements.

De mon point de vue notre branche a, paradoxalement, une meilleure compréhension « intuitive » des outils créé par LeCun que LeCun lui même . Et ses prédictions continuellement foireuses sur des trucs qui utilise à chaque fois ses travaux comme coeur de fonctionnement, en disent long sur le sujet amha.

. Et ses prédictions continuellement foireuses sur des trucs qui utilise à chaque fois ses travaux comme coeur de fonctionnement, en disent long sur le sujet amha.

Dernière modification par Nilsou ; 04/08/2023 à 20h34.

-

04/08/2023, 20h53 #1104

C'était bien ma question, quelles sont ces très nombreuses prédictions qui se sont toutes révélées fausses ?

Il y a de quoi être a priori dubitatif quand tu répètes plusieurs fois qu'il ne comprend rien aux réseaux de neurones, alors que c'est justement un des pionniers du domaine qui a largement contribué à l'explosion de sa popularité dans la dernière décennie.

Tu as peut-être raison hein, mais l'argument d'autorité ne suffit pas. Tout chercheur en IA que tu es on n'a aucune raison de te croire sur parole là-dessus ou quand tu dis que c'est l'opinion d'une majorité des "chercheurs en IA" (il est aussi chercheur en IA, depuis bien plus longtemps et avec bien plus de reconnaissance dans la communauté de l'IA que toi...).

-

04/08/2023, 23h21 #1105

Bah ce n'est qu'un avis personnel. Quant aux exemples de prédictions foireuses, je ne vais pas les faire par le menu ça fait bien 5 ans qu'il en fait et qu'on en parle au coin café avec les collègues à chaque fois que l'une de ses prédictions est invalidée, c'est devenu un sujet de rigolade ^^ (pour ça que ça me fait marrer que ça dépasse la communauté des chercheurs pour se retrouver dans une vidéo de philosophe). T'imagine le boulot que ce serait que je retrouve tout proprement (faut un sacré brainstorming en plus ...) , et que je source tout ça, dans des contextes à chaque fois bien différent, pour en faire une liste propre ici

Si tu veux un point de départ tu en a un avec un exemple concret très typique (il est toujours un peu sur la même ligne) discuté et tout dans la vidéo posté précédemment dont je t'ai mis un lien juste au dessus, et en plus on a bien discuté de cet exemple précis dans le topic juste avant. Tu peux déjà commencer par là et si tu trouve ça insuffisant on verra après.

Enfin ça n'a rien de vraiment scandaleux ni surprenant contrairement à ce que tu avance. LeCun est surtout connu pour sa conception de l'algo de rétropropagation de réseaux de neurone, c'est pas du tout un spécialiste de mélange de réseaux de neurone pour aboutir à un produit fini ayant un comportement. C'est un peu comme si je te disais que le designer d'un marteau n'est pas très doué en charpenterie, je veux dire ... ce n'est pas super étonnant si ? C'est deux choses bien différentes. Même si le charpentier utilise le marteau.

Après si tu veux, au lieu de te faire la liste à la prevert qui me prendrait des heures à réunir, je peux, après que tu ais vu la vidéo, expliquer la différence fondamentale de paradigme entre LeCun et GPT, qui fait que LeCun nie et niera toujours que GPT puisse faire ceci ou cela. Je peux d'autant plus faire cet exercice qu'à la base je suis plutôt cote LeCun du spectre. La différence, c'est que moi j'ai admis qu'on avait tort de notre coté du spectre : la version bourrine marche et à de bonne chance d'aller bien plus loin. Là où LeCun continue à le nier mordicus.Dernière modification par Nilsou ; 04/08/2023 à 23h34.

-

04/08/2023, 23h44 #1106

Donc un long message pour dire que non, tu ne donneras pas de citation à l'appui parce que ce serait trop long et qu'il faut te croire sur parole quand tu dis qu'il est incompétent. Tant pis.

-

05/08/2023, 02h21 #1107

^_ ^Aurais-je touché à ton idole ?

Déjà je n'ai pas dit qu'il était incompétent.

Ensuite, je t'ai recommandé une vidéo complète (avec interview du bonhomme etc.) sur le sujet comme premier exemple récent pour que tu ais un point de départ permettant la discussion, tu ne veux pas la regarder ...

Je ne vais pas m'amuser à recopier les paroles d'une vidéo complète (commenté en long en large et en travers dans ces 4 dernières pages du topic, passage sur LeCun compris), c'est complétement idiot. Si tu ne veux pas faire un effort, soit de regarder la vidéo, soit de lire les pages du topic en détails (idéalement, les deux), je ne peux rien faire pour toi...

En plus bon, on ne va pas refaire le topic : On a parlé de prédiction foireuse de LeCun (avec citation etc.) plusieurs fois sur ce topic. Ça a souvent été discuté en long en large et en travers depuis que LeCun mène sa croisade contre les capacités des LLM. La dernière fois c'était Charmide qui en parlait de mémoire.Dernière modification par Nilsou ; 05/08/2023 à 02h48.

-

05/08/2023, 09h22 #1108

Tu dis que t'as 15 000 exemples, que t'en discuttes quasi tous les jours à la machine a café. Il te demande pas une liste exhaustive mais un exemple.

Ça devrait même pouvoir etre sorti rapidement puisque c'est le genre de truc que vous evoquez entre deux cafés apparemment.

-

05/08/2023, 11h26 #1109

Mais un exemple a été donné.

Il est justement dans la vidéo de MrPhi qui a lancé la discussion.

Mais si vous avez la flemme de regarder la vidéo (ce qui du coup question la pertinence de participer au débat) :

LeCun dit qu'une IA qu'on entraine uniquement à partir de texte ne peut pas se créer de représentation du monde.

Il prend en exemple le fait de poser son téléphone sur la table puis de pousser la table. Pour un humain il est évident que le téléphone bouge avec la table mais vu qu'aucun texte n'explique cela (toujours selon lui) alors une IA entrainée sur des textes ne pourra jamais apprendre/comprendre ça.

MrPhi démontre le contraire juste après en posant quelques questions sur le problème à ChatGPT.

On a donc bien une prédiction péremptoire qui se révèle fausse au bout d'un an.C'est la faute à Arteis

-

05/08/2023, 11h37 #1110

Déjà j'ai pas dit que j'avais 15000 exemple

. On en a discuté à plusieurs occaz durant les dernières années, c'est plutôt au rythme de « le mec fait des prédictions foireuses tout les X mois ». Et je ne savais pas qu'il fallait prendre des notes ^^. Moi j'ai juste compté les points ^^.

. On en a discuté à plusieurs occaz durant les dernières années, c'est plutôt au rythme de « le mec fait des prédictions foireuses tout les X mois ». Et je ne savais pas qu'il fallait prendre des notes ^^. Moi j'ai juste compté les points ^^.

De plus c'est toujours la même chose, il fait une prédiction parce qu'il n'aime pas « le chemin bourrin », donc il invente un truc que « le chemin bourrin » ne pourra jamais faire au grand jamais (généralement un problème de pensé en lien avec la vrai vie), et c'est fait 2 mois après. C'est toujours la même chose, je ne tient pas l'inventaire des divers exercice foireux type « Die Hard » qu'il a inventé et qui se sont retrouvé résolu 3 mois après.

Ensuite, heuuuuu, crotte à la fin. Le sujet n'a pas vraiment l'air de vous intéresser en fait, vous faites juste comme des journaleux qui exige un mot de quelqu'un pour la forme, je m'y refuse parce que je trouve que vous êtes lourd et flemmard.

Nan mais franchement : on fait 3 pages de discussions sur une vidéo qui contient déjà un exemple typique très précis, tu as un mec qui se ramène à la suite de cette discussion sans regarder la vidéo ni lire la discussion (alors qu'on discute spécifiquement de ce passage de la vidéo à plusieurs occasion) et qui exige une liste d'exemple. Dans une attitude exécrable du type : « T'es pas plus fort que LeCun la célébrité alors hein prouuuuve le qu'il sait pas faire ceci ou cela ». Tout ça sur un topic où on a déjà fait plusieurs pages sur d'autres exemples en plus de celui là.

Bah je lui réponds de manière parfaitement normale : je vais pas me faire chier à réécrire ce qu'on a déjà écrit, si ça t'intéresse tu commence par relire les 4 dernières pages et la vidéo associé, ensuite j'ai été gentil, comme il insiste je lui ait même donné le nom du canard qui a présenté d'autres exemples sur ce même topic, il y a un petit bouton en haut à droite et on retombe en un clic sur les discussions associée, avec citation de LeCun etc. les divers avis des canards associés, dont les miens etc.

Donc voila, si ça vous intéresse allez voir. Sinon tant pis.

PS : merci Orhin ^^

Répondre avec citation

Répondre avec citation