Affichage des résultats 481 à 510 sur 4947

-

28/10/2013, 17h45 #481

-

28/10/2013, 17h59 #482

-

28/10/2013, 18h04 #483

-

28/10/2013, 18h15 #484Banni

- Ville

- Yvelines

Ben voilà mon 2500K à 4500mhz je vais le garder 10 ans je crois.

Sans exagérer.

Ce serait bien qu'amd redevienne competitif aussi.

-

28/10/2013, 21h07 #485

-

28/10/2013, 21h54 #486

Forcément, sous Linpack, Haswell double quasiment les perfs par rapport à Ivy Bridge.

+90% de perf pour +20% de power, moi ça me va...

-

28/10/2013, 23h28 #487

-

29/10/2013, 11h22 #488

-

31/10/2013, 14h25 #489

-

02/11/2013, 09h08 #490

Hello,

Un test qui ne sert pas à grand chose...

Déjà que la RAM est chère en ce moment

A +

-

02/11/2013, 09h24 #491

Photo : Nikon D5100 et Fujifilm X20 Flickr

Photo : Nikon D5100 et Fujifilm X20 Flickr

-

03/11/2013, 11h18 #492

Je case ça ici, j'imagine que c'est à peu près le bon endroit : existe-t-il une possibilité qu'avec la génération de consoles qui arrive et une bonne optimisation multi-cœurs (je sais pas comment appeler ça autrement), les AMD FX (pas ceux avec un TDP de 200W) redeviennent compétitifs par rapport au i5 (voire i7) ?

Sur GameGPU, à propos de BF4, on voit notamment ceci :

Il faudra probablement attendre d’autres jeux pour le dire, mais est-ce que vous semble probable ?i5 3550 (3,3 Ghz) – 16 Go DDR3 – GeForce 1070 8 Go – Crucial MX300 512 Go et M4 128 Go – Creative Soundblaster Z – LDLC-QS 550+ – LG 27GN850 – Iiyama G2773 – Bitfenix Phenom M.

-

04/11/2013, 10h35 #493

AMD a

couchécollaboré avec DICE sur le développement de BF4. Il est pas exclu qu'en plus d'un gain pour les GPUs Radeon on retrouve aussi un gain sur leurs processeurs - soit en optimisant le jeu pour tirer parti des modules Bulldo, soit en bridant les perfs des CPUs Intel.

Quoi qu'il en soit j'éviterai de tirer des conclusions générales sur la base d'un seul jeu sponsorisé. Dans 99% des jeux les processeurs AMD restent à la peine...

-

04/11/2013, 10h38 #494

Après, il faut voir aussi le rapport performance/ conso.

Pas tant dans l'optique des euros épargnés par an, mais plutôt comme un indicateur du bon rendement de puissance de la puce (bonne architecture).

A ce petit jeu, je pense qu'AMD a du retard sur Intel actuellement.

-

04/11/2013, 18h42 #495

Mouais, Crysis 3 permet au FX de foutre une méchante branlée en performance/prix aux Intel, mais c'est vrai que ça reste 2 cas assez isolé. Bien que je pense que l'avenir est vers la multiplication des coeurs avec le développement pour console qui va de facto être pour 8 coeurs.

Et FB74, ça n'est pas une question d'architecture uniquement. Intel a un avantage de finesse de fabrication qui va leur conférer un avantage certain en terme de consommation/performance.

-

04/11/2013, 20h52 #496

Vous achetez des proc sur le fait qu'ils font un bon score sur un jeu vous ? oO

-

04/11/2013, 21h31 #497

-

04/11/2013, 21h34 #498

-

04/11/2013, 23h12 #499

Il est terre à terre le Ragondin, riche mais terriblement terre à terre...

-

05/11/2013, 06h35 #500

Je fais dans le pratique et j'aide l'économie à tourner. Suis un mec bien quoi

-

05/11/2013, 09h05 #501

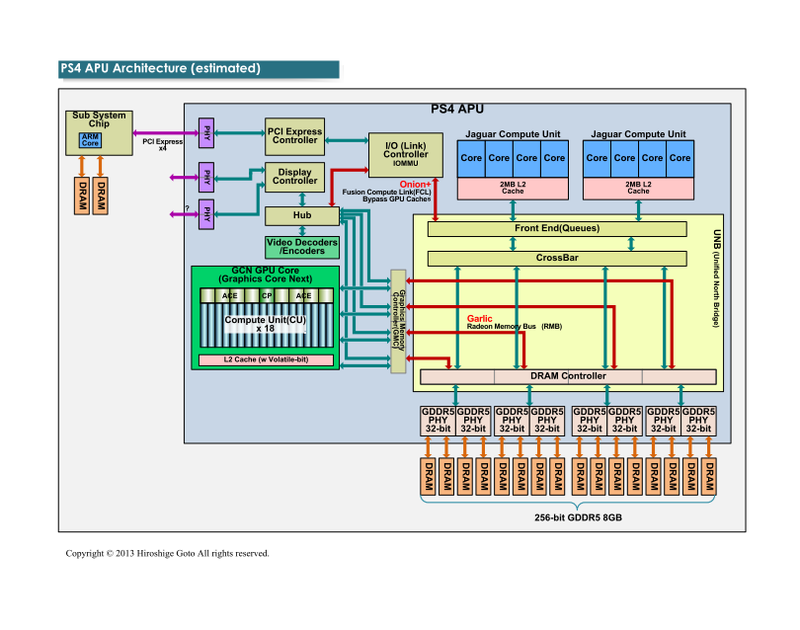

Je sais pas si tu as suivi l'actu sur l'architecture console mais en fait ce serait faux, les consoles ne seraient pas de vrais octo-cores. Ce seraient deux quad-cores gravés sur le même die, si mes souvenirs sont bons. La différence se situe surtout au niveau des caches qui ne sont pas partagés et ne permettent pas d'exécuter un programme en parallèle sur les 8 coeurs en même temps.

Il est donc probable que les jeux doivent se contenter de 4 coeurs (sur lesquels ils seront les seuls programmes exécutés, ce qui est un minimum vu qu'on parle de 4 coeurs basse conso @1,6Ghz), le reste (OS, fonctions d'enregistrement et de partage en ligne, chat vocal, Kinect...) s'exécutant sur les 4 autres coeurs.

-

05/11/2013, 09h19 #502

Alors de ce que je viens de lire, la séparation des cache ne se fait que jusqu'au cache L2, ce qui laisse une communication par cache L3 qui théoriquement permet une certaine communication. Après ouais, c'est sans doute lent, c'est con.

Donc il convient de s'en tenir à l'ancien adage wait and see.

-

05/11/2013, 11h30 #503

-

05/11/2013, 12h58 #504i5 3550 (3,3 Ghz) – 16 Go DDR3 – GeForce 1070 8 Go – Crucial MX300 512 Go et M4 128 Go – Creative Soundblaster Z – LDLC-QS 550+ – LG 27GN850 – Iiyama G2773 – Bitfenix Phenom M.

-

05/11/2013, 13h35 #505

Faudra qu'on m'explique alors - mais pour de vrai hein, pas de mauvaise foi promis juré - comment ils font communiquer efficacement leurs coeurs 1 à 4 et les 5+6. Le fait de ne pouvoir passer que par le cache L3 (lent) ne va-t-il pas poser de sérieux soucis si on essaie de paralléliser sur 6 coeurs? Ou alors on exécute une partie du programme sur 4 coeurs et une autre sur 2?

Et tant qu'à faire si l'idée était de faire tourner les jeux sur 6 coeurs, pourquoi ces cons n'ont-ils tout simplement pas demandé à AMD de leur faire un CPU 6+2 plutôt qu'un 4+4? Paraîtrait qu'ils avaient un budget développement énorme et tout ça, ça devait pas être insurmontable.

-

05/11/2013, 14h19 #506

Il me semble qu'il n'y a pas de cache L3 sur les APU de la PS4 et la Xbox One. Pour communiquer entre les deux clusters, on passe par la DRAM ou par le crossbar :

Les caches sont cohérents. Un core peut lire dans le cache d'un autre. Même le GPU peut lire dans les caches des core CPU.

C'est une archi tout ce qu'il y a de plus classique. C'est au contraire le fait de partager des L2 entre beaucoup de cores (4) qui est atypique. Chez Intel, chaque core a son L2 dédié.

Tu peux voir comme un avantage le fait que les communications coûtent moins cher à l'intérieur des clusters de 4 cores. Même si ça ne change surement pas grand-chose en pratique. Quand tu écris des applis multi-thread qui se veulent un minimum efficaces, tu ne t'amuses pas à synchroniser sur des variables globales à tout bout de champ.

-

05/11/2013, 14h24 #507

Ok je comprends mieux, merci. On verra bien ce que ça donne en pratique, les comparatifs de perfs entre consoles et PC risquent de toute manière de fleurir une fois les premiers jeux multi-plateforme sortis.

-

06/11/2013, 18h09 #508

Héhéhé...

Radeon R9 290(X) : un souci avec les modèles vendus dans le commerce ?

La question des exemplaires envoyés à la presse dans le domaine des processeurs et des cartes graphiques n'est pas nouvelle. La tentation est en effet grande pour les constructeurs de proposer des produits spécifiques, plus performants que ceux que leurs clients pourront acheter. Suite au lancement de la Radeon R9 290X, Tom's Hardware a rencontré quelques soucis. AMD promet un patch.

Acheter tout le matériel testé par une rédaction est quasiment impossible, notamment dans le domaine des nouvelles technologies. Même l'UFC-Que choisir se résout parfois à passer par des exemplaires de prêt, comme c'était récemment le cas avec une analyse d'écrans 4K.

Il faut dire qu'à l'heure où les médias cherchent déjà à financer leurs rédactions, acheter tous les gadgets à plusieurs centaines d'euros qui sortent chaque semaine n'est pas vraiment à l'ordre du jour. D'autant plus que les exemplaires de presse sont disponibles à l'avance, et qu'une semaine ou deux après leur lancement, cela n'intéressera plus grand monde.

Les produits prêtés à la presse : une incitation à la méfiance

Cela a parfois incité les marques à tenter de fournir aux médias des produits sélectionnés, meilleurs que ceux vendus dans le commerce, afin de s'assurer d'une bonne image malgré un produit peu convaincant sur certains aspects. À cela s'ajoutent les références qui ne changent pas lorsque des composants importants sont modifiés, et d'autres pratiques pour le moins douteuses.

Avec le temps, cela a poussé certaines rédactions à chercher à se fournir de temps à autre des produits via le canal commercial, notamment en les achetant afin de vérifier ce qu'ils avaient constaté dans une série de premiers tests. Dans le domaine des cartes graphiques, avec la gestion des fréquences qui a évolué ces derniers temps pour des modèles qui dépendent de la température du GPU, du système de refroidissement, et donc de la capacité de la puce à s'échauffer, le problème est encore plus concret. Hardware.fr s'y était notamment attardé dans le cas des GPU de NVIDIA en mai 2012.

Le cas des R9 290(X) d'AMD encore un peu mystérieux

Mais le débat revient sur le devant de la scène suite à la parution de l'article de Tom's Hardware qui a commandé des Radeon R9 290X d'AMD et a eu la mauvaise surprise de constater des performances moindres que les versions envoyées à la presse, et même parfois inférieures à une R9 290. La raison ? La fréquence du GPU qui tombait parfois à 727 MHz plutôt que les 1 GHz mis en avant. Il faut effectivement savoir qu'avec cette génération, AMD ne communique plus que sur la fréquence maximale, et non pas sur une fréquence minimale, comme peut encore le faire NVIDIA par exemple.

Radeon R9 290X

Dans une réponse adressée à nos confrères américains, le texan a précisé que si des écarts pouvaient exister d'un produit à l'autre (ce qui n'a rien d'inhabituel), ils ne devraient pas être si importants. La société affirme que d'autres journalistes ayant récupéré des cartes dans le commerce n'ont pas constaté de tels soucis et que celles de Tom's Hardware vont être analysées.

Mais dans le même temps, on apprend qu'AMD a « identifié des zones dans lesquelles la variabilité pouvait être réduite, et nous travaillons sur une mise à jour des pilotes qui devrait la minimiser. Nous publierons rapidement une mise à jour ». Bref, il n'y a pas de problème, mais on va tout de même le corriger. Une affirmation qui ne devrait pas franchement lever les doutes, d'autant plus qu'un lecteur de Tech Report indique lui aussi avoir rencontré quelques soucis du même genre.

Il ne reste maintenant plus qu'à attendre que d'autres analyses soient faites à la fois sur les modèles envoyés à la presse et sur ceux disponibles dans le commerce afin d'avoir le fin mot de cette histoire. Quoi qu'il en soit, si vous avez commandé une Radeon R9 290 / 290X et que vous constatez de tels comportements, faites-le nous savoir au sein de nos commentaires.

-

06/11/2013, 20h43 #509

La fréquence diminue jusqu'à 727Mhz avec l'augmentation de la température (ou plutôt la maintenir à 95°C). Cette valeur n'est donc pas anormale.

Je suis allé sur le site de Tom's Hardware pour en savoir un peu plus, et j'ai envie de penser qu'AMD a soigné le travail sur le ventirad (meilleur pâte thermique ?? Mieux appliqué ??) pour celles fournies à la presse que sur celles qui sont produites à la chaine et directement mises en vente. Ça expliquerai que celle qui leur a été fournie tenait bien les 1000MHz tandis que celle qu'ils ont acheté tombait tout de suite à 727. Leur solution via la mise à jour des pilotes va sans doute être d'augmenter encore un peu les rpm de la turbine...

De toutes façons personne ne recommande d’acheter ces cartes avec le design de référence, et ce problème ne devrait plus se retrouver sur les modèles custom (à condition qu'ils soient bien fait).

-

07/11/2013, 08h13 #510

C'est plus probablement un choix dans les puces pour choisir celles qui ont le moins tendance à chauffer.

.

.

Répondre avec citation

Répondre avec citation