Oui, et les 8 DSP peuvent être sérialisés, avec un système de partage/duplication de leur mémoire cache.

cf article de Blachford.

Affichage des résultats 31 à 60 sur 132

Discussion: The Cell

-

08/02/2005, 19h56 #31

-

08/02/2005, 21h44 #32

-

08/02/2005, 22h40 #33Noobz0r

Vais peut-être poser une question très idiote.... mais les 8 DSP sont-ils reprogrammables ? OU bien sont-ils dédiés à une tâche fixe figée ad vitam aeternam dans le silicium (on Insultor il est vrai) ?

-

08/02/2005, 23h22 #34

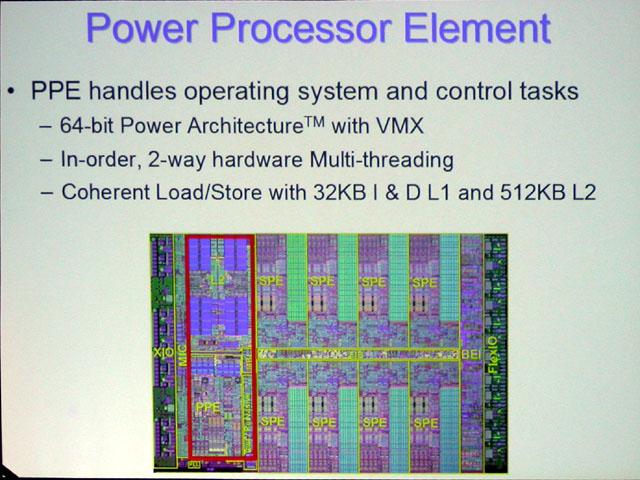

A mon avis, le terme DSP n'est pas très adapté, ces 8 unités s'apparentent plus à des CPU à part entière.

Architecture d'une PU :

-

09/02/2005, 05h57 #35Rookie II

Tout le monde a l'air bien septique pour la frequence... mais quel interet aurait-ils a raconter des conneries?

Je vois bien les cores SIMDs a 4Ghz et le controleur PowerPC a 2Ghz par ex.

Qd mm, les bandes passantes sont siderantes:

Rambus 25.6GB/sec

FlexIO 76.8GB/s

mon pentium M est a 3GB/sec et ma carte 9800XT a 23GB/sec, j'ose pas imagine ce que donnerai un flight simulator porte sur un Cell, si celui si sature ses i/o's ! (ya pas de raison que non)

-

09/02/2005, 08h45 #36Je te rejoint la dessus car effectivement les SPE s'apparente "vachement" à des CPU avec leur propres mémoires certes ils seront bien plus spécialisés qu'un CPU généraliste, mais bon ca y ressemble quand même fortement...

Envoyé par Yasko

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Envoyé par Yasko

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Shin'ichi Okamoto-Chief Technical Officer Sony Computer Entertainment Corporation

-

09/02/2005, 08h51 #37T'as encore rien vus ! La technologie XDR (anciennement Yellowstone) est prévue pour atteindre les 100 Go/sec, elle utilise le principet de l'ODR (Octal Data Rate) bref les fréquences de base ne sont pas de 3.2 Ghz ni 6.4 Ghz mais plutôt de 400-800 Mhz avec du dual channel et l'ODR on atteint ainsi des fréquences équivalentes monstrueuse et des bandes passantes du même genre...

Envoyé par beud

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Envoyé par beud

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Shin'ichi Okamoto-Chief Technical Officer Sony Computer Entertainment Corporation

-

09/02/2005, 11h41 #38CPC Hardware

et les latences équivalentes.

c'est de la technologie rambus, hein. Ca a un gros défaut (a part le prix, qui est pas vraiment un défaut, ca se contourne), les latences.

en débit pur, de la rambus en dual va mieux que de la DDR en dual, mais les latences sont en retrait. et on voit ce que donne si on augmente les latences, un cache de 2Mo qui est pas plus efficace que un cache de 1Mo

Et je ne vois pas vraiment l'utilité de 9 core pour du jeux, mais bon, je suppose qu'ils ont bien une petite idée derrière la tête.

-

09/02/2005, 11h58 #39

Ca fait vraiment envie tous ces GFLOP partout mais la question que je me pose est : qu'en est-il du software ?

A l'heure ou on cherche différentes methodes pour réduire le cout de developpement des logiciels, ils proposent un proc qui se programme quasiment directement. De plus les 8 unites sont des unites vectorielles donc assez specifiques. Ca va surement etre dur a programmer.

D'un cote c'est bien en tout cas pour moi car si le Cell prend et qu'il est vraiment ardu a exploiter de facon logicielle ben j'aurais du boulot.

De l'autre si peu de personnes ne veulent investir dans des logiciels pour lui il se peut qu'il reste cantonné à des apllications spécifiques.

Je penses que le succes du Cell depend plus du bon vouloir des editeurs de logiciels plutot que de ses enormes capacites de calcul. En tout cas pour ce qui est du marché du PC."si tout le monde s'etait dit "pour quoi faire ?" je pense qu'on tournerait encore sur 8086. Si tant est qu'on ait l'electricite ... " Franck@X86

If all goes well will Dell sell Cells?

<°)))><

-

09/02/2005, 12h12 #40

La difficulté va surtout être au niveau du compilateur je pense.

Et d'un autre coté, le fait que l'architecture d'un Cell soit figée (voir article de Blachford), peut contrebalancer les nouvelles difficultés liés aux choix pris.

La difficulté ne va même pas être dans le compilateur (enfin, pas toute), mais dans le microcode (on peut l'appeler comme ça ?) du Cell.If there is a law in computing, Abstraction is it, it is an essential piece of today's computing technology, much of what we do would not be possible without it. Cell however, has abandoned it. The programming model for the Cell will be concrete, when you program an APU you will be programming what is in the APU itself, not some abstraction. You will be "hitting the hardware" so to speak.

While this may sound like sacrilege and there are reasons why it is a bad idea in general there is one big advantage: Performance. Every abstraction layer you add adds computaions and not by some small measure, an abstraction can decrease performance by a factor of ten fold. Consider that in any modern system there are multiple abstraction layers on top of one another and you'll begin to see why a 50MHz 486 may of seemed fast years ago but runs like a dog these days, you need a more modern processor to deal with the subsequently added abstractions.

The big disadvantage of removing abstractions is it will significantly add complexity for the developer and it limits how much the hardware designers can change the system. The latter has always been important and is essentially THE reason for abstraction but if you've noticed modern processors haven't really changed much in years. The Cell designers obviously don't expect their architecture to change significantly so have chosen to set it in stone from the beginning. That said there is some flexibility in the system so it can change at least partially.

The Cell approach does give some of the benefits of abstraction though. Java has achieved cross platform compatibility by abstracting the OS and hardware away, it provides a "virtual machine" which is the same across all platforms, the underlying hardware and OS can change but the virtual machine does not.

Cell provides something similar to Java but in a completely different way. Java provides a software based "virtual machine" which is the same on all platforms, Cell provides a machine as well - but they do it in hardware, the equivalent of Java's virtual machine is the Cells physical hardware. If I was to write Cell code on OS X the exact same Cell code would run on Windows, Linux or Zeta because in all cases it is the hardware Cells which execute it.

It should be pointed out that this does not mean you have to program the Cells in assembly, Cells will have compilers just like everything else. Java provides a virtual machine but you don't program it directly either.

-

10/02/2005, 09h02 #41Les latences seront élevés c'est indéniable cela dit pour une architecture vectorielle qui traite des flux massifs de données le désavantage d'une latence élevé est à relativiser car au final c'est la BP qui prime le plus pour ce genre d'architecture...

Envoyé par dandu

Envoyé par dandu

c'est aussi pour ça qu'un contrôleur mémoire à été intégré sans parler du PPE qui sera là pour gérer les requètes d'accès à la mémoire par les SPE donc au final les latences seront plus élevés certes mais pas forcément dans des proportions extravagantes elles ne devraient pas nuire plus que ça au reste de l'architecture.

Regarde pour la PS2 toute la partie géométrique est assuré par les 2 VPU de l'Emotion Engine alors que Graphic Synthesizer et ses 16 pipelines ne traite que la partie pixel Envoyé par dandu

Envoyé par dandu

Le Cell faira probablement pareil il s'occupera de la gestion polygonale, de la physique alors que la puce graphique (conçus en partie par nVidia) ne gèrera peut-être que les pixel shaders l'anti-aliasing et la compression vidéo... Enfin bref cela serait assez logique vu la puissance du cell en FPU... bref cela permettra de mettre plus de Pixel pipeline dans le GPU (24 voir 32 serait envisageable)."We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Shin'ichi Okamoto-Chief Technical Officer Sony Computer Entertainment Corporation

-

10/02/2005, 09h40 #42Les SPE doivent pouvoir s'addresser directement au DMAC sans passer par le PPE, non ?

Envoyé par EPIC

Envoyé par EPIC

-

10/02/2005, 09h51 #43Pour la programmation des SPE se sera certainement coton cela dit SONY avec la PS2 à de l'expérience aussi dans ce domaine (5 ans) car les nombreuses critiques qui lui était faite était justement sur la difficulté de programmation à cause des VPU notamemnt et de leur gestion mémoire...

Envoyé par jihef

Envoyé par jihef

Tout est possible cela dit dans le projet il y a IBM on sait déja que le proc tournera sous Linux grâce à l'Archi POWER pour le reste je ne doute pas une seule seconde qu'IBM supportera les dévellopeurs comme le font Intel ou encore AMD... Envoyé par jihef

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Envoyé par jihef

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Shin'ichi Okamoto-Chief Technical Officer Sony Computer Entertainment Corporation

-

10/02/2005, 09h52 #44Ben d'après ce que j'avais crus comprendre c'est le PPE qui gère l'ensemble...

Envoyé par Yasko

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Envoyé par Yasko

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Shin'ichi Okamoto-Chief Technical Officer Sony Computer Entertainment Corporation

-

10/02/2005, 11h46 #45CPC Hardware

passer la gestion des polygones au CPU, c'est quand même un gros retour en arrière, non ?

même si le CPU a une puissance géométrique monstrueuse, il atteint pas les perfs d'un GPU dédié avec des fonctions cablées, a priori.

maintenant, Sony a toujours essayé de cacher le nombre de polygne par des gros effets de lumière, et faits la même chose sur la PSP -en puissance brute, c'est assez faible, en traitement d'image, c'est puissant-.

enfin, si c'est bien fait, ca porte pas trop a conséquences, les kyro2 approchaient des geforce 2 GTS en condition réelle, sans T&L et avec une puissance brute nettement moins grandes, mais un système bien pensé.

Reste que pour le Cell, je suis dubitatif, autant de puissances et de complexités dans un CPU qui servira à une console, ca m'étonne.

a mon avis, la version dans la console sera allégée, ou alors ils ont trouvés un truc miracle pour le produire a pas cher. Parce que bon, on peut pas se permettre de mettre des centaines d'€ dans une console.

-

10/02/2005, 12h03 #46

Bah, déjà la gravure à 0.65 (étonnante..) réduit les coùt..

Ceci dit, les premières PS1 était à plus de 1400Fr et pareil pour les PS2.

Ils comptent peut-être aussi enfin faire une console qui peut durer?

-

10/02/2005, 12h10 #47CPC Hardware

Même en réduisant les couts, le processeur reste énorme, donc cher à produire. En plus, a une fréquence pareille, ca va chauffer, donc ventilation, gros boitier, etc. Envoyé par Romuald

Envoyé par Romuald

Une console qui dure, c'est pas viable. On compare automatiquement les consoles aux PC. Même si au début la console est en avance, après 6 mois, elle est au niveau du PC, puis elle y reste 1 an environ (on tire plus du matos de la console que celui du PC, du a l'architecture figée).

Après, la console tient plus la route quand on compare les graphismes, et comme le kéké de base, il regarde les graphismes, ben on doit lancer la rumeur d'une nouvelle console.

Durée de vie moyenne commerciale : 3 ans, parfois un peu plus, mais pas beaucoup.

A part les japonais qui achètent encore des jeux SuperNes, evidemment.

On peut ire ce que on veut de la PS2, mais au niveau graphisme, a tient plus trop la route face a un PC (ou une Xbox, d'ailleurs), même si au nveau gameplay, ca dépasse le PC pour pas mal de jeux (hors simulateur de vol et parfois FPS).

-

10/02/2005, 12h25 #48

Niveau graphisme il faut voir ce dont on a besoin aussi.. pour afficher sur une TV standart en 1024 maximum il n'y a pas autant besoin que sur un PC en 1280 ou 1600.

Et même si ça reste limite encore la PS2 à pas mal à offrir, quand je vois GT4 que j'attend avec impatience.. C'est assez somptueux.

-

10/02/2005, 12h55 #49

dandu, il faut que tu lises l'article du Cell sur Onversity, ou la véritable nature du la cellule macrophage de méchant intel. :sarcastic:

-

10/02/2005, 13h22 #50

Tiens un truc qui me fait bien marrer si on prend au sérieux cette news http://www.macdigit.com/index.php/weblog/more/the_cell/, Samuel devra renommer bientôt le site en PPC-secret.com désopilant...

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

"We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Shin'ichi Okamoto-Chief Technical Officer Sony Computer Entertainment Corporation

-

10/02/2005, 13h31 #51Oulalaaa :sarcastic:Le bus de transfert aussi est fabuleux, avec un taux de transfert de 6,4 gigahertz entre la RAM et le noyau central"La vaseline, c'est un truc que j'utilise systématiquement" - vf1000f24

-

10/02/2005, 13h40 #52Ben je ne pense pas l'idéal serait de faire traiter toute les opérations par la même puce comme ça plus aucun échange GPU <-> CPU un goulet d'étranglement (et pas des moindre éliminé)

Envoyé par dandu

Envoyé par dandu

Par définition un GPU cablé est figé dès lors de sa conception une puce comme le cell pourra être programmé à volonté. Envoyé par dandu

Envoyé par dandu

D'après le brevet il y aurait 4 cell de prévus donc on est loin d'une version allégé pour la PS3... Maintenant les impératifs économiques étant ce qu'il sont...Reste que pour le Cell, je suis dubitatif, autant de puissances et de complexités dans un CPU qui servira à une console, ca m'étonne.

a mon avis, la version dans la console sera allégée, ou alors ils ont trouvés un truc miracle pour le produire a pas cher. Parce que bon, on peut pas se permettre de mettre des centaines d'€ dans une console."We can't wait twenty years to achieve a 1000 fold increase in PlayStation performance : Moore's Law is too slow for us"

Shin'ichi Okamoto-Chief Technical Officer Sony Computer Entertainment Corporation

-

10/02/2005, 13h51 #53CPC Hardware

Pour les graphismes de la PS2, ils utilisent un gros artifices, le nombre de polygone, qui est assez faible (logique, la consoles est pas super puissante), est caché par de beaux effets dans tout les sens. C'est assez efficace comme système. Envoyé par Romuald

Envoyé par Romuald

Pour la résolution, faut pas penser en termes de graphismes actuels, ou la console reste limitée a du 640*480 (même la XBOX), mais penser au futur (qui est le présent au japon) : la HDTV

donc au minimum une résolution de 1280*720, soit pratiquement 4X plus que actuellement.

sans compter que l'antialiasing est nécessaire sur une TV, parce que les écrans sont nettement plus grand que un moniteur informatique à résolution égale.

on peut se passer d'AA sur un 17" en 1280*1024, pas sur une TV 82cm dans la même résolution.

Pour le retard console/PC : c'est pas une question de puissance brute ou pas, mais de technologie. Sur PC, on change de technologie graphique tout les ans environ, sur console, tout les 3 ans au mieux.

Une XBOX a un CPU a 733 et une carte graphique équivalente a une geforce4 Ti (un peu moins en puissance brute) et est donc limitée au PixelShader 1.4 (je crois)

Même si on exploite beaucoup plus la puissance de la XBox que un PC équivalent, on reste limité par la technologie embarquée.

L'analyse de onversity est intéressante, mais je pense pas vraiment qu'il aie raison.

La console restera un loisirs, et le PC, à base de x86, restera un outil de travail qui peut etre détourné.

C'est comme les sites sur les macs qui pensent que si on porte MacOS X sur PC, Apple va casser la baraque. C'est ridicule. Parce que les défauts du système (de tout système d'ailleurs) seront apparents. Si Windows ne tournait que sur 3% du marché et avec un matériel limité, il serait plus performant, et il y aurait moins de virus et de problèmes.

La preuve ? La XBOX utilise un Windows modifié, ca plante pas vraiment, y a pas de réeel problème, et la console est plus performantes que un PC équivalen.

-

10/02/2005, 15h43 #54Oui mais tourner sur ne veut pas forcement dire tirant parti de l'enorme puissance de calcul. Il faudrat des bons drivers et des soft optimisés spécifiquement ce qui va surement prendre du temps et ce n'est pas juste en recompilant les sources que l'on pourra arriver a utiliser toute la puissance.

Envoyé par EPIC

Envoyé par EPIC

Vive l'assembleur !!"si tout le monde s'etait dit "pour quoi faire ?" je pense qu'on tournerait encore sur 8086. Si tant est qu'on ait l'electricite ... " Franck@X86

If all goes well will Dell sell Cells?

<°)))><

-

10/02/2005, 15h55 #55Roxx0r

L'exemple parfait de l'intégriste macintosh, bête et méchant :sarcastic:. C'est con parce que je ne cracherais pas du tout devant un portable mac avec un PPC G4, mais quand on voit des commentaires de cette sorte, ben çà dégoûte un peu ... Envoyé par EPIC

Envoyé par EPIC

-

10/02/2005, 17h05 #56

-

10/02/2005, 17h51 #57Noobz0r

serieusement je trouve ces progresssion de prosseseur bien compliquer pourquoi on ne retournerai pas a des arvhitecture plus simple moi de transistort un pipeline long avec une bonne correction d'erreure et un bonne fréquence vert les 7-8Ghtz ? :??:

-

10/02/2005, 17h55 #58CPC Hardware

le nombre de transistor d'un processeur n'augmente pas tellement depuis quelques années, hein. c'est juste une illusion due au fait que les caches augmentent.

entre un Celeron covington (sans L2) et un Pentium-M Dothan, y a un énorme gouffre en transitors, mais le core est pas super différent.

En plus, les longs pipeline avec processeur rapide, on voit ce que ca donne, hein.

-

10/02/2005, 18h08 #59

-

10/02/2005, 18h22 #60CPC Hardware

ben face a un processeur plus efficace avec un pipeline plus court, ca tient pas trop la route.

le long pipeline, c'est efficace por monter en fréquence, mais pas trop au niveau des perfs.

Répondre avec citation

Répondre avec citation