Ok Ok ça vient de moi alors.

Ceci dit je ne généralisais pas, je voulais juste avoir ce genre de retours.

- Et moi j'ai eu des Asus des années (sur mes config intel, à la P5Q....) j'ai jamais de soucis justement.

Affichage des résultats 1 501 à 1 530 sur 1891

Discussion: [Processeurs] Discussions et conseils

-

23/06/2023, 10h59 #1501

-

23/06/2023, 11h29 #1502

Tiens c'est marrant j'avais une P5Q aussi que j'ai filé à un proche, j'étais dessus hier et elle tourne toujours comme une horloge. Tout comme toi j'ai toujours pris ASUS depuis le début.

En ce qui concerne mes tours montées : ma première était sur AMD (2004 A7N8X-e deluxe), la deuxième et troisième sur INTEL (2007 P5Q / 2011 P8Z68-V LX) et la dernière de nouveau AMD (B650-plus) et mis à part ce petit inconvénient de la durée de démarrage pour test de la RAM lorsque le profil XMP/EXPO est activé sur ma dernière config (on va dire que c'est surtout psychologique car je ne m'amuse à démarrer/redémarrer mon PC tout le temps) j'ai jamais vraiment vu de différence entre les plateformes INTEL et AMD. Mais oui difficile de se rendre compte puisqu'on est confronté à des cas individuels.

-

23/06/2023, 17h22 #1503

On se demande toujours pourquoi lorsqu'un avion s'écrase la seul chose qui résiste c'est la boite noire et dans ce cas pourquoi les avions ne sont pas conçus de la même manière !?

Plus sérieusement j'ajouterais à la réponse de Qiou87, que l' IGPU Amd pour console a une "grosse" conso et est sans doute inadapté à une utilisation sur un laptop, par contre on peut se poser la question sur desktop.

Peut-être Sony et /ou Microsoft ont-ils un contrat d'exclusivité ou alors AMD ne veut pas faire sa propre concurrence voir concurrencer Intel (en étant conspirationiste), une autre possibilité que l'IGPU soit trop cher pour être intégré à un pc offrant un piètre rapport qualité prix...Marionnettiste

-

25/06/2023, 10h11 #1504

Un gros gros roundup de Hardware Unboxed sur les cartes B650 et B650E

D'un côté j'aurais bien aimé l'avoir avant d'acheter la mienne. Bon de l'autre ça n'aurait probablement pas changé mon choix.

En résumé :

- globalement quasiment toutes les cartes B650/B650E sont correctes ou bonnes, il y a très peu de risque de se tromper. Il y a uniquement 3 cartes à éviter à tout prix : la Gigabyte B650M K, l'Asus Prime B650-Plus et l'Asus Prime B650M-A WiFi (mais elle a été remplacée par l'Asus Prime B650M-A WiFi II qui est largement mieux et au même prix)

- dans les cartes à moins de $200, c'est assez simple, les cartes Asrock sont supérieures aux autres, elles sont très bonnes (même si simples en termes de fonctionnalités) et pas chères

- entre $200 et $280, c'est assez compliqué, ça va être une marque à préférer plutôt qu'une autre en fonction du prix et des fonctionnalités.

- entre $280 et $350, ce sont les cartes Asus de la gamme ROG Strix les meilleures pour leur prix.

- au dessus des $350 (Gigabyte Aorus Master et Asrock Taichi), les cartes apportent plus grand chose d'intéressant pour leur prix démesuré

Quelques remarques ou critiques tout de même sur cette vidéo, de mon point de vue

- ce n'est pas une critique, mais l'échelle de prix n'est pas la même en France qu'aux US, donc ça peut fausser la hiérarchie. Par exemple, j'ai l'impression que les cartes Asrock sont beaucoup plus chères chez nous alors que les cartes Asus sont à des prix relativement proches.

- il est peut-être un peu trop focalisé sur le jeu vidéo et oublie d'autres fonctions.

Par exemple il parle de l'Asus ROG Strix 650E-E WiFi, que je connais bien puisque c'est la mienne. Il trouve que c'est une excellente carte (ça me conforte) mais que son seul intérêt comparé à l'Asus ROG Strix 650E-F WiFi, c'est qu'elle a un port m.2 PCIE 5.0 de plus. En fait si j'ai pris cette carte et pas la F, c'est surtout parce qu'elle a un connecteur SPDIF qui me permet de brancher une barre de son SONOS.

Autre remarque concernant toujours cette carte mère, c'est que si on met un deuxième m.2 PCIE 5.0, le port 16x 5.0 passe en 8x, ce qui est un peu bof de mon point de vue et ça il n'en parle pas. Donc pour moi, clairement, de loin l'intérêt principal de la B650E-E par rapport à la B650E-F, c'est le connecteur SPDIF, pas le deuxième port m.2 5.0, et il ne parle absolument pas du connecteur SPDIF dans sa vidéo. Je comprends que certains s'en foutent complètement, mais si on veut être complet, je trouve qu'il faut quand même en parler.

Autre remarque sur une autre carte Asus, la ProArt B650 Creator, pour lui le seul intérêt de cette carte, c'est son look. Non en fait l'intérêt de cette carte, c'est qu'elle peut avoir 2 cartes graphiques en 8x/8x, c'est complètement inutile pour les gamers, mais ça peut être très utile pour du GPU computing, et c'est d'ailleurs pour ça que cette carte est vendue dans la gamme ProArt, pour créatifs et pas dans la gamme ROG, pour gamers (le branding a parfois du sens).

Bon, c'est des petites remarques comme ça, globalement c'est une excellente vidéo, toute personne voulant se faire une config AMD devrait la regarder avant.Dernière modification par Borh ; 25/06/2023 à 10h55.

-

25/06/2023, 10h46 #1505Banni

-

25/06/2023, 10h53 #1506

J'ai fait un commentaire, mais c'est un gros Youtubeur, il a peu de chance de le remarquer au milieu de milliers d'autres commentaires.

-

25/06/2023, 11h26 #1507

Je partage ton idée sur le port SPDIF, on en parle de moins en moins, mais la plupart des home cinema (coucou PC de salon), privilégient se branchement. Rien que sur cette page on est déjà deux à faire attention à ce point, c'est donc que cela intéresse un minimum

D'ailleurs, il suffit de voir la plupart des conversations, ce qui joue assez souvent dans le choix c'est souvent la connectiques, même si dans un premier temps la qualité/fiabilité/suivi du modèle sont recherchés (bonne VRM, prise en charge de..., ne crame mon CPU... ).

).

-

26/06/2023, 12h23 #1508

J'ai une question assez bête.

Ma config actuelle est un 3800X sur une carte 570, DDR4 couplé à une GTX 3080. Il m'arrive dans des quelques jeux d'être légèrement short en CPU (Darktide, CP, ...). Je n'ai pas pour projet de faire une grosse upgrade pour si peu (ca serai vraiment du caprice) mais la possibilité de passer au 5800x3d, qui à l'air d'être très apprécié en AMD4, me fait de l'œil (oui bon ok ca reste un peu du caprice).

La raison ? J'ai d'un coté envi de me faire ce petit plaisir et que sur ma config (AMD4), passer au 5800 me permettra de la pousser un peu plus dans le temps ma configuration (MB, ram, ...) tout profitant du gain.

La crainte ? Que ca soit vraiment un caprice et que la différence soit assez marginale. D'après les recherches réalisées, même si je ne suis pas toujours à l'aise avec les chiffres, ca semble être dans les 20 - 25 %

La décision me revient mais si vous avez un avis sur la question, ca m'intéresse .

.

-

26/06/2023, 12h28 #1509Banni

Je laisse les autres canards répondre, mais on est dans le 15-25% de perf + les bénéfices du X3D.

ça va pas te révolutioner la configuration mais ça peut te donner le petit coup de pouce.

Après le 3800X devrait normalement pas limiter de grand chose la 3080 en 1440p mais ca dépends aussi de ce que tu fais tourner.

-

26/06/2023, 13h43 #1510

C'est assez variable selon ta résolution et le jeu.

Une bonne manière de savoir si tu as un CPU bottleneck important, c'est d'overclocker et underclocker le CPU. Si l'effet sur les FPS est important, tu auras un gros gain à changer de CPU. Certains jeux ont aussi des benchmarks intégrés qui mesurent le CPU bottleneck, par exemple Modern Warfare 2 ou Shadow of the Tomb Raider, mais le résultat n'est valable que pour ce jeu.

-

26/06/2023, 14h06 #1511

J'ai tendance à jouer en 1440p. J'ai l'impression que c'est surtout les option RT qui prennent beaucoup de ressources. Dans le type de jeu c'est notamment Darktide dernièrement qui m'a fait réaliser ca, il semble assez gourmand en CPU comme l'était également Vermintide à l'époque (ca yoyotte autour 45 fps avec cette config, ce qui est jouable).

Tu as raison, je vais en effet essayer d'OC, durant une journée fraiche, pour voir si ca change et ca m'aidera a me décider. l'idée c'est surtout sur la durée, grapiller quelques années avant de renouveler la config et profitez du gain d'ici là.

-

26/06/2023, 14h53 #1512

A noter que l'OC a un effet franchement négligeable en jeux aujourd'hui. Le turbo fait un très bon boulot pour avoir 1 ou 2 cores à très haute fréquence. OC, que ce soit en faisant sauter la limite de consommation ou en forçant une fréquence boost tous les cores, est surtout efficace sur les charges multicores type encodage qui chargent bien tous les cores. Sur un jeu qui n'en charge bien que 2 ou 3, l'OC ne vaut pas le coup, y'a pas grand chose à gagner par rapport aux optimisations déjà présentes. On est plus à l'époque de Sandy Bridge.

Y'a des overlays en jeux, ou même un logiciel comme HW Monitor te montrera la charge par core CPU et la charge GPU, pour voir en temps réel si tu es limité CPU ou GPU. Mais avec une RTX3080 en raytracing, ce sont les tensors core qui vont probablement te plomber la fluidité bien avant le CPU.

J'ai fait un changement similaire (5600X -> 5800X3D) et les seuls programmes où j'ai vu une amélioration sensible, ce sont des simus de vol (MSFS, DCS) fortement monocores dans leur charge CPU, et fortement CPU-limitées (même en VR).

L'argument de la durée de ta plateforme s'entend ; un 5800X3D est quasiment au niveau des meilleurs CPUs du moment, tu peux estimer être peinard avec pendant peut-être ~2 ans de plus qu'avec ton 3800X?

Sur eBay ça se revend autour de 120€ un 3800X. A 300€ en Allemagne (en France il est difficile à trouver à moins de 350€ sauf chez des vendeurs marketplaces peu recommandables) ça te fait 180€ pour 20-25% de gains et ~2 ans de durée de vie supplémentaire de ta plateforme dans un usage jeux. A toi de voir si c'est rentable selon ton budget, la part du jeux vidéo dans tes loisirs, etc.

-

26/06/2023, 15h24 #1513

Je crois qu'à l'époque des Ryzen 3000, l'OC fonctionnait encore de façon assez classique, en tout cas c'était le cas sur mon 3900X avec de vrais gains. Rien que le fait de faire l'OC automatique dans Ryzen Master ou sur l'outil de ma CM, à l'époque MSI Dragon Center, apportait des gains de perfs CPU (au détriment d'une grosse perte d'efficience).

Sur les plus récents, un bon moyen de voir si on est en CPU bottleneck est de passer en mode eco, si les fps s'effondrent, c'est probablement qu'on a CPU bottleneck.

-

01/07/2023, 16h36 #1514

La tentation du 5800X3D

... J'ai la même chose. Sauf que je viens d'un 3600 (pas X, sur un CM B450). Normalement, je devrais voir une différence sauf que je ne suis pas sûr que le 3600 soit à la peine en 1440p (Radeon 5700XT), ou alors je n'ai pas choisi les bon jeux. Shadow of the Tomb Raider n'avais pas l'air de mettre 100% au CPU.

... J'ai la même chose. Sauf que je viens d'un 3600 (pas X, sur un CM B450). Normalement, je devrais voir une différence sauf que je ne suis pas sûr que le 3600 soit à la peine en 1440p (Radeon 5700XT), ou alors je n'ai pas choisi les bon jeux. Shadow of the Tomb Raider n'avais pas l'air de mettre 100% au CPU.

Mais bon, c'est un investissement moindre (par rapport au changement complet de plateforme), et ça permet de gagner 2-3 ans...

On trouve des 5800X3D à un tout petit peu plus que 300€ en Belgique et aux Pays-Bas.

Comme l’ami Jack Pervert... Je ne suis pas encore convaincu... J'ai l'impression que mon 3600 peut encore durer un peu.

Détail intéressant: SI je saute le pas pour un 5800X3D, je vais le refroidir avec mon vénérable Noctua NH-U12P acheté en 2008 et qui s'est retrouvé sur toutes mes machines entre temps. Si ça chauffe trop: Peerless Assassin (ce nom )

)

Objectif moyen terme: nouvelle CG, x2 sur la RAM, S.T.A.L.K.E.R. 2

Dernière modification par fucosyl ; 01/07/2023 à 16h38. Motif: Il manquait un point :)

♫ "When I sin, I sin real good

When I sin, I sin for sure" ♫

-

01/07/2023, 23h42 #1515

-

02/07/2023, 01h18 #1516

-

02/07/2023, 04h44 #1517reneyvaneGuest

Ryzen-5-5600x3d un processeur en version limitée et uniquement disponible aux Etats-Unis.

Un détaillant américain, Micro Center annonce avoir conclu un accord exclusif avec AMD pour la commercialisation du processeur Ryzen 5 5600X3D. Cette référence ne sera disponible que chez ce revendeur et uniquement aux Etats Unis.

Il est précisé qu’il s’agit d’une opération spéciale car il s’agit d’une version en édition limitée. Nous n’avons cependant pas de précision sur la quantité de puce disponible. Le lancement est prévu pour le 7 juillet prochain. Il s’agit d’un processeur équipé de 6 cœurs physiques et 12 cœurs logiques. Il turbine à 3,3 GHz de base contre un mode boost à 4,4 GHz et profite de 96 Mo de cache L3.

Il n’est pas impossible que ce Ryzen 5 5600X3D soit en réalité un Ryzen 7 5800X3D dont deux cœurs sont désactivés en raison de défaillances constatées. Il se dit qu’une « certaine disponibilité » OEM du Ryzen 5 5600X3D est possible mais sans autre précision.

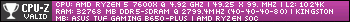

Micro Center annonce un prix public de 229,99 $. Il sera aussi disponible avec une carte mère ASUS B550-PLUS TUF Gaming et 16 Go de RAM G.Skill Ripjaws V pour 329,99 $.

---

https://www.ginjfo.com/actualites/co...-unis-20230630

-

02/07/2023, 14h02 #1518

-

03/07/2023, 10h59 #1519

Bon finalement, j'ai reçu ce weekend en cadeau d'amis un 5800X3D, donc la question ne se pose plus !

Pas encore pu trop le tester mais je pense que ca fera le travailles quelques années.

Finalement je m'étais trompé et était équipé d'un 3700X. A vendre prix canard pour les intéressés.

-

03/07/2023, 11h49 #1520Banni

Simpa tes potes

-

10/07/2023, 22h23 #1521reneyvaneGuest

Le CoreI7-14700K à peine meilleure que le 13700K en monothread mais bien mieux en multithread.

---

https://hardwareand.co/actualites/br...eux-benchmarks

-

11/07/2023, 11h45 #1522

-

11/07/2023, 12h09 #1523

-

11/07/2023, 13h16 #1524

Si c'est le même process et juste 4 E-core de plus, avec des améliorations minimes au passage, c'est tout vu: 250W en pointe, bref watercooling AiO 240mm obligatoire et climatisation de la pièce sauf si tu habites au nord du 50e parallèle (et encore). Intel continue dans son impasse à ce que je vois.

-

11/07/2023, 13h42 #1525

Sur le test de TechpowerUp, le 13700k est déjà à 250W sur Blender et Cinebench MT, donc ce sera un peu plus je pense. Vu que ce sont des core E supplémentaires, on peut espérer que le gain en consommation sera relativement moindre que le gain en perf.

-

11/07/2023, 13h57 #1526

-

11/07/2023, 13h58 #1527

Pas forcément en fait ; le 13700K consomme 250W parce que c'est sa limite de consommation. Il "tape le plafond" si tu veux. Si Intel a maintenu les mêmes limites sur la génération 14 (ça j'avoue on ne sait pas), le 14700K "pleine charge" consommera autant que le 13700K. Simplement il est possible qu'en séparant la charge sur plus de cores, il atteigne des performances légèrement meilleures en multicore sans aller aussi haut en fréquence (ou grâce à un process un peu plus optimisé pour que le CPU tienne sa fréquence avec une consommation par cœur légèrement inférieure). On est typiquement dans l'amélioration incrémentale, c'est juste dommage qu'Intel relance un nouveau socket et plateforme juste pour ça.

-

11/07/2023, 14h12 #1528

Ok, je ne savais pas qu'il y avait une power limit sur le 13700k (et je connais plus trop le fonctionnement des CPU Intel récent). Du coup, quand je vois que l'overclocking, le fait passer au dessus, ça veut dire qu'on peut débloquer cette limite dans le BIOS, j'imagine.

-

11/07/2023, 16h27 #1529

-

12/07/2023, 08h14 #1530

C'est leur stratégie commerciale, c'est tout ; y'a sûrement des raisons techniques mais c'est dommage de voir qu'ils ne font aucun effort à ce niveau, AMD ayant montré qu'une plateforme durable et évolutive était possible sans compromettre les performances ou l'efficacité énergétique, et ça avec un budget R&D nettement inférieur à Intel. Je n'adhère pas, effectivement, mais je trouve ça moins gênant que leur efficacité énergétique pourrie en fait. Je me souviens de la période des AMD FX que tout le monde conseillait allègrement d'éviter comme la peste principalement car ils étaient très énergivores pour les mêmes performances que les Intel Core de l'époque. Aujourd'hui la situation est inverse et bizarrement, tu retrouves malgré tout pas mal de monde dans la presse qui va te dire "achetez Intel ils sont super" alors qu'on conseille un i5 qui bouffe jusqu'à 200W au lieu d'un Ryzen 5 qui en utilise la moitié - même chose avec les gammes au dessus. Et tout ça sur fond d'urgence climatique et de crise énergétique l'hiver dernier qui ont, me semblait-il, mis en avant la nécessité d'être sobre. C'est plutôt cette forme de tolérance laxiste envers Intel qui me dérange.

Répondre avec citation

Répondre avec citation