Y'a encore des failles au niveau des doigts ou du visage, mais super impressionnant quand même

Affichage des résultats 571 à 600 sur 1288

-

03/09/2018, 13h39 #571

-

25/01/2019, 00h32 #572

Déterrage du topic grace à DeepMind qui vient de mettre une branlée aux meilleurs joueurs mondiaux de StarCraft II à l'aide d'une IA dont l'entrainement a commencé par de l'apprentissage supervisé sur des données de parties réelles, avant de continuer au sein d'une ligue "virtuelle" où différentes instances se battent entre elles pour continuer à améliorer leur apprentissage (si je dis pas de conneries).

-

25/01/2019, 00h45 #573

C’est ça. Par contre elle a surtout gagné car elle a un comportement très inhabituel pour un joueur de ce niveau. D’ailleurs je trouve que ce commentaire résume assez bien les matchs contre le premier joueur pro :

Elle a une très très bonne exécution mais pour la stratégie il y a encore de la marge pour rivaliser avec un joueur pro. Dans la dernière partie, en direct, le joueur a précisé avoir pas mal investi pour avoir toujours un espion dans la base de l’IA histoire de voir ce qu’elle faisait.

Ah et le fait que ce ne soit pas le même agent qui joue plusieurs parties contre la même personne enlève une petite partie du jeu.

-

25/01/2019, 10h44 #574

Si les humains ne peuvent pas apprendre de leur adversaire qui leur a tout piqué et a pris le temps de bien le faire, y'a un peu enfumage.

C'est aussi assez moyen de constater que l'avantage est surtout pris sur le micro-management qu'un humain n'a pas la capacité d'effectuer au même niveau pour des questions d'interfacage physique.

Comme le dit Félire, sur plusieurs parties, les humains peuvent trouver des failles, ou simplement appliquer d'autres stratégies qui appelleraient des contre-stratégies moins efficaces.

-

25/01/2019, 17h05 #575Banni

C'est pas les mêmes arguments que ceux que j'avais développés sur le topic, mais y'a des liens et le constat est le même:

"L'intelligence artificielle n'existe pas"

https://www.journaldugeek.com/dossie...ateur-de-siri/Dernière modification par Anonyme20240202 ; 25/01/2019 à 17h30.

-

25/01/2019, 17h18 #576

Je partage entièrement cet avis.

Rien que le terme est trompeur, je lui préfère celui d'apprentissage artificiel qui correspond bien plus à la réalité.Rien ne me choque moi, je suis un scientifique ! - I. Jones

-

26/01/2019, 01h32 #577

Heu, non? Autant sur le nombre que sur la possibilité de le faire.Prenons l’exemple de Kasparov qui se fait battre par Deep Blue en 1997. Est-ce une preuve de l’intelligence de la machine? Pas du tout. Car qu’a-t-on fait fait exactement ici ? On a modélisé toutes les possibilités aux échecs (10^53). Pour un homme, c’est beaucoup. Mais en 1997, c’est possible de le faire sur Deep Blue.

Une version plus récente de AlphaGo a apprise à jouer toute seule sans devoir analyser des parties jouées par des humains.Avec le jeu de Go, c’est un peu différent car on ne peut pas modéliser toutes les possibilités. Une partie d’entre elles ont cependant été modélisées et des modèles statistiques aident à combler les trous.

Un peu comme l'intelligence en fait. Sauf si les neurones ont un fonctionnement qui défie les lois de la physique.Donc il n’y pas d’intelligence, c’est simplement une masse de données et un peu de statistiques.

Religious trigger waring.D’où cela vient, est-ce de l’inné, de l’acquis ? Je n’en sais rien. Mais l’humain a quelque chose en plus.

Un peu comme... Un humain quoi. Qui n'est absolument pas non plus objectif ni omniscient.Si j’utilise volontairement ou involontairement des données orientées dans un certain sens -politiquement par exemple- pour entraîner mon IA, je créé une IA biaisée.

Le principe de l'éducation. Des fakes news. De la manipulation qui existe depuis à peu près le début de la vie sur Terre.

Oui alors là je crois qu'on s'éloigne un peu du sujet spécifique de l'IA, parce qu'à peu près n'importe quel truc consommateur de courant est tout autant un "danger écologique".L’autre problème est celui dont je parlais tout à l’heure avec les 440 kWh : certains systèmes utilisent énormément de ressources. Le danger écologique est réel.

En fait on dirait qu'il considère l'"intelligence" humaine comme un truc bien séparé hermétiquement, toujours le même éternel biais basé sur le caractère divin de l'Homme.

Les mêmes foutaises sur l"âme" entre autres trucs que les machines ne pourraient pas avoir (le nombre diminuant sans cesse), parce qu'il faut bien qu'on garde un trait caractéristique unique pour continuer à penser que l'on domine l'Univers.

C'est en fait l'intelligence (peu importe qu'elle soit humaine ou artificielle) qui n'existe pas, ou du moins l'idée fausse que l'on s'en fait en mélangeant des notions religieuses complètement hors de propos à ce qui n'est que de la mécanique soumise aux lois de la physique, l'IA n'étant qu'une copie plus ou moins grossière.

-

26/01/2019, 03h48 #578

Il ne faut pas non plus tomber dans l'excès inverse à en nier que l'Homme est le résultat de milliards d'années d'évolution, et donc une "machine biologique à penser" assez exceptionnellement adaptée à son environnement terrestre

La simple liste de ses réalisations sans aide extérieure depuis les premier hominidés devraient en convaincre!

La simple liste de ses réalisations sans aide extérieure depuis les premier hominidés devraient en convaincre!

Certes, on est un peu dopés aux énergies fossiles dernièrement. Et ce monsieur a raison de rappeler qu'un cerveau humain fonctionne avec un bol de riz (complet) par jour là ou un cerveau "artificiel" tel qu'on les conçoit aujourd'hui a une dépense énergétique folle, qui n'est probablement pas aussi adapté qu'un humain à la survie long terme dans un environnement terrestre.

Après, en soit et philosophiquement, une IA fabriquée sur Terre avec des éléments terrestres n'a pas de raison d'être fondamentalement différente d'un humain et même accéder à "la conscience" si elle en rejoint le niveau de complexité: nous ne sommes tous après tout que de la poussière de croute terrestre prenant illusion de vie et conscience sous l'action des forces physiques de notre univers

Mais là encore, le bond en complexité nécessaire par rapport aux IA disponibles aujourd'hui pour en arriver à "la conscience artificielle" laisse a penser que le bond énergétique nécéssaire seras tout aussi astronomique!

-

26/01/2019, 09h22 #579

Tout ça c'est du blabla qui dépend de comment on définit intelligence. C'est comme la définition du vivant. Impossible de trouver une frontière claire, il y a tout un gradient, et ce n'est pas une frise 1D mais un espace avec plusieurs types d'intelligence. Intelligence artificille il y a "artificielle" dedans, donc ce ne sont pas les machines à penser robuste que nous sommes qui évoluent dans un environnement très entropique et noisy, mais des petites intelligences ultra-spécialisées qui vivent dans des univers simples.

Il y a quand même un point intéressant, c'est qu'avec les réseaux de neurones profonds, on est dans des modèles à très hautes dimensions et il devient très difficile de dire pourquoi le modèle a dit que c'était un chien et pas un chaut (contrairement à une régression linéaire ou un arbre de décision où on remonte facilement aux "causes"). C'était exactement l'argument pour lequel développer une IA pour la vision était difficile, si tu demandes à un humain pourquoi ça c'est une voiture, il va te dire "il y a des roues, des fenêtres, c'est pas gros comme un camion..." mais il ne saura pas t'expliciter clairement la fonction qui fait que c'est une voiture ou pas, la frontière de décision. Pareil pour un modèle de réseau convolutif, au mieux on peut lui dire c'est quoi les morceaux de l'image qui l'ont "excité" pour dire que c'est une voiture, où lui dire de dessiner des morceaux de voiture, où pour chacun de ses neurones lui dire de chercher dans al base de donnée ce qui l'excite le plus etc... Mais on ne peut plus clairement trouver la frontière décision, surtout pas analytiquement, mais même pas numériquement car l'espace ambiant est en trop grande dimensions.

Pareil un peu pour Alpha-Go. Pour le jeu d'échec il peut descendre sur l'arbre de possibilité et te dire je joue ça parce que si je descend l'abre de possibilité c'est ce qui a le plus de chance de gagner. Pour Alpha-Go il va pouvoir t'estimer la valeur d'un coup qu'il n'aura jamais vu, jamais fait et ça marchera et on ne sait pas expliciter ça.

-

26/01/2019, 11h07 #580Amateur de Petits-Gris

-

26/01/2019, 11h14 #581

Merci pour le topic ! C'est un sujet qui m'intéresse beaucoup depuis que je me penche sur l'utilisation du Big Data pour mieux piloter les administrations publiques.

Là je suis le MOOC de Coursera sur le Machine Learning et je vais bosser sur un premier projet d'application dans mon canton dans le secteur public.

EDIT : en lisant les premiers posts, c'est peut-être pas ce type d'IA dont il est question ici

-

26/01/2019, 11h31 #582

L'ia a fait quasiment la même stratégie à chaque fois (seul le spamm de disrupteurs était vraiment "original", le proxy était une variante de ce qu'elle a fait à chaque fois : innonder le joueur humain sous un flot continu d'unités).

Et comme l'a dit haik, ce qui a fait la différence, c'est qu'elle peut être à plusieurs "endroits" à la fois. Elle a une très bonne macro, elle produit en continue, tout en pouvant aussi attaquer en continue. La ou un joueur humain ne peut pas faire les deux en même temps. Donc c'était très impressionnant, sans l'être vraiment.

Pour la micro pure, plusieurs fois c'était vraiment de la merde (notamment avec une unité qui peut faire du friendly fire). En revanche la macro était top (même si il y a quand même eu des loupés parfois, supply block).

Et si on doit relativiser sa performance, on peut parler du fait que c'était sur un seul match up, et un match up miroir en plus.

-

26/01/2019, 12h04 #583

-

26/01/2019, 12h17 #584

Je sais pas si ça change fondamentalement la donne qu'elle n'ait accès qu'à "un seul écran". Etant donné qu'elle peut tout lancer instantanément, il lui suffit d'un retour base d'1/10e de seconde pour lancer les constructions. D'autant plus que très rapidement, la seule chose qu'elle avait à faire était de lancer des pylones régulièrement vu qu'elle ne faisait que bourrer en continue. Pour la prod en elle même, elle utilise les raccourcis, comme un humain, donc pas besoin de retourner à la base.

-

26/01/2019, 12h41 #585

Faut aussi voir un truc, c'est que des jeux comme Starcraft sont prévus et soigneusement équilibrés pour des affrontements entre joueurs humains.

Les développeurs ont prévu, et continué à équilibrer leur jeu bien après sa sortie dans l'objectif à la fois de présenter des matchs équilibrés entre joueurs humains, mais aussi d’empêcher toute "faille" de type "tactique bateau à répéter ad nauséam mais qui marche" car les joueurs humains sont comme ça: ils cherchent, et s'ils découvrent une stratégie qui marche, aussi ennuyeuse soit-elle, ils vont l'employer parce qu'ils sont là pour gagner Mais évidemment ça va les ennuyer et rapidement plus personne ne regarderas ou ne joueras au jeu. L'équilibrage, et continuer à équilibrer le jeu en fonction des tactiques employées/découvertes par les joueurs est donc très important.

Mais évidemment ça va les ennuyer et rapidement plus personne ne regarderas ou ne joueras au jeu. L'équilibrage, et continuer à équilibrer le jeu en fonction des tactiques employées/découvertes par les joueurs est donc très important.

Si des IAs se mettent à jouer a Starcraft en nombre et gagner avec une stratégie bateau comme ici, les développeurs vont devoir équilibrer à nouveau leur jeu ^^.

Ce que je veux dire par là, c'est que Starcraft, c'est fait par et pour des humains et équilibré avec leurs limitations et leurs découvertes tactiques et évolutions sur plusieurs années de compétition. Y faire combattre une IA, c'est impressionnant, mais clairement les équilibrages ne sont pas prévus pour.

-

26/01/2019, 12h49 #586

Le truc c'est que l'apm ça veut tout et rien dire. Les joueurs les plus bas sont vers 200, puis ça monte facile à 300 400. Sauf que la plupart du temps les joueurs spamm, genre pour un déplacement, au lieu cliquer une fois, ba tu clic 4 5 fois facile.

Ou je veux en venir, c'est que 300 d'apm, pour le convertir en clic utile, tu peux a mon avis le diviser par deux facile. Donc si l'IA se cale sur eux, genre 200 300 mais en ne faisant que du clic utile..

Après la strat est reproductible, mais t'auras jamais la perfection macro de l'IA qui peut faire deux choses en même temps (via les retours éclairs et les raccourcis). Du coup au lieu d'avoir 10 stalkers à 5 minutes devant la base ennemie, t'en auras peut être que 8. Et au lieu d'attaquer perpétuellement sans permettre au défenseur de gérer proprement sa macro, l'attaquant humain fera des pauses pour macro lui aussi. Ce qui fait que le défenseur sortira plus d'unités puisqu'il pourra respirer un peu.

Je sors des chiffres de mon cul, mais c'est pour donner une idée.

En game pro humain contre humain. Jamais un mec en battra un autre en faisant traverser toute la carte aux stalkers après les avoir warp à la maison. A niveau à peu près égal évidemment.

-

26/01/2019, 13h55 #587

C'est pour moi clairement la distinction entre un système que l'on entraine pour résoudre une tâche plus ou moins spécifique et un système qualifié d'intelligent : la capacité à expliquer le problème et pas simplement le résoudre. Il y a un net gap entre l'intelligence de l'humain et les systèmes actuels sur cette capacité.

Exemple avec les échecs. On a bien construit un système qui peut battre n'importe qui. Pour autant, a-t'on progressé sur la compréhension du jeu d'échec avec cette "IA", ou des mécanismes permettant de remporter une partie ? Je ne crois pas. Les système de reconnaissance d'objets basés sur des réseaux convolutifs permettent-ils de comprendre la structure et la grammaire d'une image ? Non plus. Ils sont capables d'apporter une solution, mais ils ne permettent pas de rendre plus intelligible le problème. Forcément, puisqu'ils ne sont pas conçus pour cela.Rien ne me choque moi, je suis un scientifique ! - I. Jones

-

26/01/2019, 14h30 #588

Le joueur humain est surpris pour plusieurs raisons. Déjà l’IA fait des trucs débiles, parfois dans le contexte de la meta du jeu, à laquelle l’humain est habitué mais aussi des choses objectivement débiles. Ensuite, l’humain n’affronte pas une IA mais plusieurs. Le premier joueur n’était même pas au courant. Ça change pas mal de choses. Dans Starcraft la stratégie Jean-Claude Duss est tout à fait valable. Un bon joueur peut gagner une carte face à un joueur pro. Par contre, gagner 3 ou 4 cartes de suite est peu probable car le joueur pro va s’adapter. L’IA ne semble pas capable de s’adapter sur un temps si court.

Ensuite, quand deux très bons joueurs s’affrontent, si l’un d’entre eux est peu connu alors il aura un avantage. Les très bons joueurs, surtout en Corée, sont étudiés par toute une équipe. En Pro League par exemple, un tournoi coréen, le match est connu deux semaines ou plus à l’avance. On sait qui joue contre qui et sur quelle map. Et dans ces conditions tu vois des équipes bosser spécifiquement une stratégie pour battre le joueur X sur la carte Y. Sauf que quand le joueur n’est pas encore très connu, il n’a pas été étudié. Pour cette raison, on a souvent vu des joueurs non-coréens en pleine ascension se retrouver face à un gros joueur coréen et le battre sur un Bo3. Par contre dans les rencontres suivantes, le non-coréen se fait défoncer car, entre temps, il aura été repéré et étudié. C’est moins vrai depuis un ou deux ans car la scéne SC2 en Corée a l’air d’avoir pris un peu de plomb dans l’aile mais il y a deux ans ou plus c’était un cas assez fréquent. "Oh la la, Machin a battu X, ça y est, il va tout défoncer et devenir le premier non-coréen à dominer la scène". Et deux semaines plus tard Machin se prend 0-3.

Ça c’est pour la partie surprise.

L’IA, stratégiquement et tactiquement, n’a pas été supérieure aux humains. Elle a été supérieure dans l’exécution. Pour ce qui est de la variété des stratégies je pense qu’il y a deux sortes de stratégies oubliables. D’abord celles utilisées à bas niveau mais qui seraient abandonnées en cours de route et, ensuite, les vieilles stratégies qui datent d’une version antérieure du jeu mais qui sont passées de mode ou qui, à un moment, sont devenues moins efficace suite à un patch de rééquilibrage.

Le premier cas ne se produit pas vraiment pour deux raisons. La première c’est que c’est l’inverse qui arrive : les gens vont chercher à copier les stratégies de plus haut niveau. La deuxième c’est que l’éventail des stratégies viables dépend de la maîtrise technique du joueur. D’ailleurs cela représente les deux approches principales d’un nouveau joueur de Starcraft. Certains vont essayer de copier une stratégie et l’appliquer en boucle jusqu’à être capable de l’exécuter de façon efficace. Pour d’autres il faut d’abord bosser la partie mécanique jusqu’à être suffisamment solide pour pouvoir appliquer des stratégies de bons joueurs.

Au final on ne voit pas vraiment de stratégie bas-niveau être utilisées à l’identique à plus haut niveau. Par contre on voit des versions améliorées car le joueur devenant plus habile il peut avoir plus d’unités, plus avancées, plus vite.

Ensuite, pour le second cas, celui des "anciennes" stratégies, c’est un point tout à fait valide. On a déjà vu des nouveaux joueurs pros se faire défoncer par des vieux de la vieille. Et on a aussi vu des petits nouveaux tenter une nouvelle stratégie qui, en fait, était un vieux truc que le joueur d’en face connaissait. C’est pour ça que le choix de ces deux joueurs était intéressant. TLO et Mana poncent le jeu depuis la beta, ils connaissent ces vieilles stratégies et ils en ont même inventé un paquet. Je ne pense pas qu’ils aient été surpris sur ce point.

Le problème c’est qu’on a vu plusieurs IA. On ne sait pas si un agent donné applique plusieurs stratégies ou pas. Ensuite, comme je le disais plus haut, l’IA a remporté des parties grâce à sa supériorité technique. Déjà elle avait une caméra reculée, toujours avec le brouillard de guerre, mais permettant d’avoir une vue d’ensemble, précise du terrain de jeu. Le joueur humain lui doit passer par la mini-carte qui n’affiche que des carrés verts (alliés) ou rouges (ennemis). L’avantage procuré est particulièrement flagrant lors de la partie où le deuxième joueur humain s’est retrouvé pris sur 3 fronts.

Un autre soucis, toujours flagrant lors de ce triple front, est celui des APM. Normalement, pour un humain, l’activation d’une touche du clavier ou de la souris est considéré comme une action. Je dis normalement car il semblerait qu’il y ait un bug, qui touche TLO à cause des raccourcis qu’il utilise, qui compte comme une action du joueur comme plusieurs. C’est pour ça qu’on voit TLO faire des pics à 1200 APM. D’ailleurs la moyenne que Deepmind affiche sur son blog est fausse pour cette raison. Bref. Le soucis c’est que l’IA ne passe pas par un clavier et une souris mais par une API. Elle appelle des fonctions du programme Starcraft or un appel d’une fonction peut être équivalent à plusieurs actions pour un joueur humain. Ils en parlent dans l’AMA sur reddit mais en gros quand l’IA est à 300 APM cela peut équivaloir à beaucoup plus pour un humain.

Sur les affrontements on peut voir l’IA sélectionner pile le bon nombre d’unités pour tirer sur une unité adverse afin de la détruire. Il n’y a pas un seul tir en trop. Ce comportement est sur-humain. Un humain devrait sélectionner l’unité adverse (ça demande de la dextérité, bien plus que d’appeler une fonction), regarder la vie restante, calculer le nombre de tirs de Stalkers nécessaire pour la tuer, sélectionner pile ce nombre de Stalker et leur dire de cibler la même unité adverse.

Enfin, cette supériorité dans l’exécution a un impact quant à la stratégie employée. On a vu que l’IA joue avec énormément de Stalkers (les machins bleus à 4 pattes qui peuvent faire de courtes téléportations) ou de Phoenix (les unités qui volent et peuvent en soulever d’autres). On sait que ces unités ont un très fort potentiel avec une très bonne micro-gestion. Les humains ont essayé cette stratégie mais au bout d’un certain nombres de Stalkers/Phoenix, cette stratégie demande trop d’actions par minute pour rester supérieure à d’autres stratégies. Par exemple, celle employée par Mana, en rajoutant les grosses unités jaunes avec deux canons dans son armée, est plus forte qu’un pur groupe de Stalkers quand l’adversaire n’a pas des facultés sur-humains.

Et pour revenir sur le fait que l’IA construise trop de récolteurs. Je doute que ce soit vraiment plus optimal. C’est un point qui est étudié depuis très longtemps dans le jeu, il a été modélisé plusieurs fois et la pratique habituelle des joueurs pros découlent de ces études en plus d’expériences propres. Sur ce point, je trouve les gens de Deepmind un peu trop enthousiastes. Pour finir je rajouterai qu’on a vu un seul matchup, sur une seule carte avec une race dont on sait que le match miroir est assez peu varié. Bref, c’est carrément trop tôt pour dire que l’IA est meilleure que l’humain en dehors de l’exécution.

-

26/01/2019, 15h17 #589Banni

Certains canards ont l'air d'avoir balayé l'article du revers de la main, mais un argument intéressant qui est lié à tout ce qui est évoqué dans les messages au dessus c'est l'efficacité en terme d'utilisation de ressources.

Ultimement en physique tu peux grosso modo tout ramener à de l'énergie (information, matière), donc l'argument énergétique parait très pertinent.

De même, qualifier l'intelligence est effectivement difficile, mais y'a quand même un grand nombres de métriques pertinentes. Complexité en temps/en espace, notation grand O: https://fr.wikipedia.org/wiki/Complexit%C3%A9_en_temps, https://fr.wikipedia.org/wiki/Complexit%C3%A9_en_espace, https://en.wikipedia.org/wiki/Big_O_...ndau_notations

On voit très clairement que "l'intelligence" humaine est fondamentalement différente de "l'IA" sur la simple comparaison de leur efficacité.

Comme on l'a dit sur le topic et comme le dit le mec dans l'article, les IA actuelles sont fondamentalement stupides et brutales, le coeur de l'affaire c'est l'efficacité algorithmique et sûrement d'autres éléments plus complexes (le "quelque chose en plus").

Pour reprendre sur votre discussion un truc intéressant à faire ça serait une IA qui joue a Starcraft en ayant la même limitation en terme consommation energétique qu'un humain, là faudrait sortir les algos et ranger les unités de calcul, la "vraie" intelligence.

Si y'a pas de cadre en terme d'exécution la comparaison entre intelligence demeurera toujours trop floue. Mais de toute façon on est clairement encore très loin d'une véritable intelligence.

Ce qu'on a de mieux c'est des algorithmes spécialisés puissants de pure conception humaine, et l'aspect apprentissage généraliste qui parait encore bien faiblard. Quand on combine les deux ça donne un truc cool, mais on n'y est pas encore.

-------------------

Sinon un point relativement important, toujours dans cette idée de comparaison, c'est que y'a beaucoup d'opérations effectuées par l'humain qui sont pas prises en compte.

Dans le cas de Starcraft, la machine ne perd vraisemblablement (je connais pas l'implémentation) pas de temps à identifier une unité, en tant qu'humain ton cerveau fait des opérations à chaque fois que tu vois l'écran pour identifier ce qu'il voit, de la même manière y'a l'interactions de tes mains avec le clavier, etc. etc. Tout un tas de difficultés supplémentaires.

Et là où je veux en venir c'est que je pense que ça serait très intéressant d'égaliser au maximum le terrain de jeu, de simplifier à l'extrême le défi pour identifier fondamentalement ce qui fait l'intelligence humaine.

C'est intéressant de faire ce genre de défi sans restriction en terme d'implémentation, de puissance de calcul, etc. Mais je pense que ce serait également extrêmement intéressant de viser une égalité parfaite sur une opération en particulier pour pouvoir proprement comparer.

Une tentative d'expérience toute conne ça serait la reconnaissance:

Tu as deux écran, chacun affiche une couleur, et le sujet doit toujours choisir le blanc.

Tu prends en comptes le temps de réaction musculaire, l'interaction avec l'interface et tout un tas de connerie du genre. Et tu alignes la machine là-dessus. Ensuite tu te limites en terme de consommation energétique au niveau de l'humain. Et là tu compares qui est le plus efficace.

Un autre exemple pour cerner l'idée, le dénombrement:

Tu donnes un écran avec un certains nombre de point, et tu demandes au sujet de dénombrer en base 10 par exemple. Pareil tu égalises l'homme et la machine et tu regardes le plus efficace.

-------------------

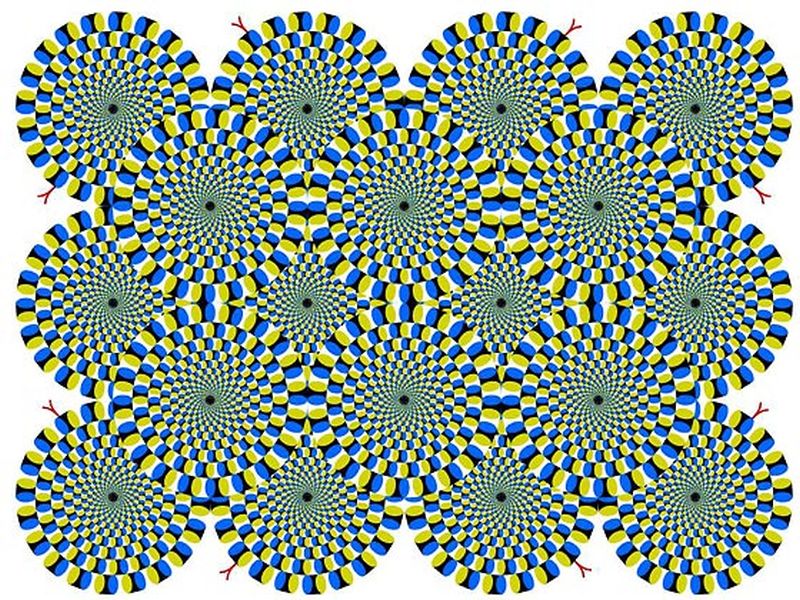

Ça peut paraitre idiot, mais l'homme utilise assez clairement des algorithmes spécialisés (en plus du "reste"), on le voit bien avec les illusions d'optiques, une machine avec un algorithme "standard" ne serait pas soumise aux illusions d'optiques. Les illusions d'optiques soulignent le fonctionnement sous jacent du cerveau, et essayer de répliquer ça avec une machine serait un pas intéressant vers la compréhension.

-----------------------

Tout ça pour dire que simplement essayer de battre l'humain à un "petit" jeu donné est vraiment un pas minuscule vers la compréhension de quoique ce soit en terme d'intelligence. Car c'est encore pire que faire un chateau de sable avec un bloc de pierre et un lance roquette, tu vas arriver à un résultat mais ça n'a rien à voir avec le sujet. Faut éviter l'écueil de la comparaison là où elle n'a pas lieu d'être. On voit quand même assez clairement que le véritable intérêt survient quand ces joueurs de Starcraft commentent sur le comportement de l'IA et comme vous l'avez dit sur le topic, c'est la reflexion, l'expression d'un sens, d'une idée sous jacente qui a un véritable intérêt. Pas la bête machine qui a pondu mécaniquement un oeufDernière modification par Anonyme20240202 ; 26/01/2019 à 15h29.

-

26/01/2019, 15h21 #590

Je ne suis pas tout à fait d'accord, toi en tant qu'humain tu n'es pas non plus capable d'expliciter de façon formelle comment tu reconnais une image, tu pourras tenter de dire "parce que ceci et parce que cela" (ce qu'une IA peut faire à sa façon) mais ça ne donnera pas une grammaire et un ensemble de règle qui permet de déstructurer l'image et de construire un ensemble de règles. C'est une forme d'intuition et c'est ça qui est intéressent avec le Deep Learning, comparé à des systèmes experts ou des modèles statistiques simples.

D'ailleurs pour le Go c'est pareil, il y a un côté intuitif à ce jeu, à part sur la partie plus "transactionnelle" et les joueurs qui ont joué avec l'IA ont progressé car ils ont appris des coups.

L'IA qui apprend toute seule de A à Z est plus intéressante à ce niveau, dans le cas du Go et des Echecs elle a inventé des coups qui n'étaient jamais vu, elle découvre sa propre méta. Mais en fait on a souvent ce problème qui se pose quand l'IA apprend seule, c'est qu'elle peut se retrouver bloquée dans une meta sous-optimale car elle trouvera des techniques qui marchent bien contre elle-même et sera bloquée dans une sorte de méta optimale localement. Il y a des solutions à ça, on peut la faire jouer contre des versions antérieure d'elle même, où alros préserver plusieurs "branches" d'entraînement (un peu comme pour les algos génétiques même si c'est pas le même type d'apprentissage.

Un autre avantage, qui est valable surtout pour une IA qui a appris sur une base de donnée mais aussi sur une IA qui a appris seule, c'est qu'elle peut garder en mémoire plusieurs métas. Si elle appris sur une base de donnée c'est comme tu l'as dit, mais même si elle a appris toute seule contre plusieurs version d'elle-même elle saura contrer différentes métas et styles de jeu.

Donc oui, à mon avis il est tout à fait possible voire très probable pour un jeu compliqué que l'IA trouve des façons de jouer qui soient complètement différentes que celles des humains et qui pourra battre des humains à haut niveau. Par contre est-ce qu'elle sera exécutable pour un humain qui la copierait? Cela dépend des contraintes qu'on donne à l'IA, ce qu'on l’autorise à faire ou pas. Si on lui met des handicaps humains et que malgré ça elle arrive à exécuter des stratégies techniquement faisable par des humains ce sera impressionant.

Oui le MOOC c'est plus de l'aprentissage supérvisé classique, là on est sur du Reinforcement LEarning, mais je pense qu'ils en parlent dans ce MOOC. Ou alors plutôt le MOOC de Deep Learning.

-

26/01/2019, 15h28 #591

-

26/01/2019, 15h30 #592

Il existe des illusions d'optiques pour les modèles de vision et ça s'appelle des "adverserial examples" ! Sinon il faut distinguer deux choses en terme d'efficacité, l'une selon moi plus importante que l'autre. La première c'est la quantité de donnée nécessaire pour apprendre, et ça c'est le gros problèmes des technos actuels et c'est pour cela que le coeur de la recherche actuelle pour passer un cap (one shot learning, meta-learning, self-supervised learning etc...). Et sinon deuxième critère d'efficacité, la décision et la taille du modèle, et ça pour moi c'est un peu moins critique... il faut savoir qu'on peut compresser facilement un modèle crée même si il y a peu d'intérêt à le faire (car finalement ça prend pas tant de place que cela, quelques mb) grâce à une méthode de "distillation" où le gros réseau apprend son modèle à un petit réseau. Cela veut dire qu'au final, on apprend beaucoup beaucoup de bruit et que la capacité du modèle (en terme de quanttié d'information en d'entropie qu'il est capable d'exprimer) est beaucoup beaucoup plus importante que ce qu'il a besoin pour comprendre ce qu'il comprend, et on ça, on pouvait s'en douter étant donné la capacité du cerveau humain, mais surtout par rapport à ce qu'il utilise de sa capacité! C'est comme si pendant l’apprentissage il avait besoin d'énormément de marge et qu'au final il en utilisait une fraction.

- - - Mise à jour - - -

Cela m'intéresse tu as un exmeple à me donner? Parce que même dans le cadre du language où les chercheurs en NLP sont allé loins dans le cadre de la déconstruction et l'explication du langage, on n'arrive pas à apporter des explications et une logique, et les modèles "intuitifs" fonctionnent mieux.

-

26/01/2019, 15h36 #593Banni

Ouais c'est un point très intéressant, mais dans ce cas là il ne faut pas oublier que l'humain est issu de 4 milliards d'années d'évolutions. Est ce que ça rentre en compte dans la comparaison? Ça serait injuste d'en attendre autant d'une pauvre unité de calcul artificielle quelque part.

De la même manière qu'un GPU est plus spécialisé pour certaines opérations qu'un CPU, il faudrait égaliser au maximum homme et machine pour avoir une comparaison pertinente sur quoique ce soit. Notre cerveau est assez clairement spécialisé pour un certains nombre de tâches, mais y'a aussi la magie du raisonnement abstrait et tout un tas d'autres trucs "impossibles" (dur en tout cas) à qualifier comme la conscience.

D'où le fait que je pense qu'il est toujours important d'isoler clairement l'objet de la discussion. L'entiereté de l'humain ça fait un peu trop comme point de départ, et c'est un peu ce qui est fait actuellement même dans le cadre apparemment restrictif d'une partie d'échec ou de Starcraft.

-

26/01/2019, 15h45 #594

Pour trouver des théories de la perception, il suffit d'aller voir chez les psychologues cognitivistes. Cela fait pas mal de temps qu'ils essaient d'apporter des modèles de la vision. Cela a commencé avec la Psychologie de la forme (Gestalt : https://fr.wikipedia.org/wiki/Psychologie_de_la_forme). On y trouve des modèles mathématiques comme chez Tversky ou Krumhansl.

Rien ne me choque moi, je suis un scientifique ! - I. Jones

-

26/01/2019, 16h18 #595

Alors oui tout à fait! Et en plus on dit qu'un humain sait reconnaître un chat après avoir vu 3 images de chat, quand il faut au moins 1000 pour un algo (ordre de grandeur), mais l'humain lui depuis sa naissance, donc sans compter les restes de l'évolution qui donnent à des a-priori à sa structure cognitive qui lui font gagner un temps fou, passe son temps à apprendre juste en observant l'univers. Donc sa connaissance des formes, de la lumière de la couleur etc... est déjà bien établi quand on lui montre son premier chat, il sait déjà ce qu'est un être vivant, un œil, que cela évolue dans un univers 3D, ce qui facilite la façon dont il imagine à quoi il peut ressembler vu de derrière etc... il transfert beaucoup de connaissance! Ce qui contraste avec l'algorithme dont l'univers se limitera à ses 1000 images de chat et 1000 images de chiens, moins riche en information que seulement quelques minutes de vie humaine. C'est un peu la piste explorée par le self-supervised et c'est très intéressant, trouver des algorithmes qui peuvent apprendre sur toute l'information qu'on leur donne, sans but ou mission précise, juste bouffer de l'information, de l'observation.

- - - Mise à jour - - -

D'accord je connais ça, c'est intéressant mais au final ce sont des théories qui postulent des structures globales et reposent sur des "toy-examples", aujourd'hui rien ne permet d'expliciter ce qui en terme de percetion humaine fait qu'on appelle ceci une voiture et ceci un chat de façon détaillée comme fonction analytique qui va de l'espace des pixels de l'image sur l'ensemble {chat, voiture}. C'est de ça dont je parle, il y a une forme d'intuition, au sens de processus analytique inconscient et non intentionel qui tourne en arrière plan pour générer les catégories mentales ("roue", "oeil", "poil", "portière"...) que notre cognition est capable de traiter consciemment.

Et d'ailleurs c'est marrant, les cas d'école donnée par la psychologie de la forme peuvent être appris par des algos de visions, ils ne se tromperont pas, comme les humains ils sauront regrouper les points selon les critères pertinents pour nous.

-

26/01/2019, 16h33 #596

Il ne faut pas rester sur la Gestalt, il y a encore des travaux actuellement.

Mais cela ne change pas mon propos qui est que la plupart des algos d'apprentissage ne sont pas fait pour tenter d'expliquer mais pour résoudre un pb donné. Ce qui sépare l'intelligence d'une boite noire. Cet effet boite noire est accentué avec les trucs à la mode actuellement, comme le deep learning.

Il est théoriquement possible de décortiquer un système entrainé pour voir comment il construit sa réponse, mais c'est un boulot assez conséquent et encore très très rarement fait.Rien ne me choque moi, je suis un scientifique ! - I. Jones

-

26/01/2019, 16h40 #597

Je suis d'accord avec tout ce que tu dis en fait, mon point c'est que parfois il y a des taches difficiles où l'humain non plus ne peut pas expliciter sa réponse (quand il croit le faire il tente de rationaliser après coup mais ça ne veut pas dire que c'est vriament comme ça qu'il a procédé.)

-

26/01/2019, 16h47 #598

Tope là on est d'accord. Cela a d'ailleurs été l'écueil des systèmes experts.

A titre perso, je galère d'ailleurs souvent bien lorsque je bosse avec des médecins ou autres et qu'il s'agit de leur faire expliquer comment ils procèdent pour décider qu'une tumeur doit être enlevée, pourquoi il choisissent de faire passer la frontière de la tumeur sur l'image à tel endroit et pas tel endroit, etc ...Rien ne me choque moi, je suis un scientifique ! - I. Jones

-

26/01/2019, 16h59 #599

J'ai lu en diagonale, mais petit bémol à ce que vous dites cependant, dans le monde de la recherche les deux approches existent. Il y a tout un pan de l'IA qui vise à étudier le pourquoi du comment du cerveau humain et qui vise donc à comprendre (en reproduisant souvent certaines chose certes) mais non à résoudre un problème pratique (même si le but à la fin c'est évidemment de comprendre comment l'humain résout des trucs pour mieux les résoudre via l'IA). Cette branche, qu'on dénomme grossièrement les "sciences cognitives" fait de fréquents aller-retour entre Neurobio, robotique et psycho. Il y a un très bon forum des sciences cognitives à paris chaque année d'ailleurs, si vous voulez aller y jeter un coups d’œil.

Cette branche de l'IA est l'une des plus dynamique en recherche, et il ne faut donc pas confondre le dynamisme des branche de la science avec l'aspect publicitaire. Car il est vrai qu'a première vue on a l'impression que la branche Deep learning/boite noire/big data et cie ... 'est très largement dominante, mais c'est surtout car elle a la puissance de communication de la hype, de google et consort derrière. En réalité c'est probablement la branche qui progresse le moins en pratique.

Il faut donc tempérer le propos "la plupart des algos d'apprentissage ne sont pas fait pour tenter d'expliquer mais pour résoudre un pb donné". En vrai c'est complétement faux. La plupart des nouveaux algos, d'un point de vue quantitatif et qualitatif, sont plutôt dans l'autre branche ou ils visent à comprendre, et non à résoudre un problème donné. Par contre la plupart des algos qui sont au contact du grand public sont exclusivement dans la branche deep learning et cie... mais c'est un état de fait purement artificiel, une hype maintenu par une immense bulle spéculative et énormément de sous au niveau com.

Voila voila, ce n'est que mon avis, mais en plusieurs année en recherche dans le milieu c'est ce que j'ai observé.

D'ailleurs à chaque fois je me dit que je devrais montrer les truc sympa récent sur ce topic chaque fois que j'en croise dans mon taf, histoire d'apporter une vue interne sur les trucs sympatoche qui ne sont pas propulsés par google et consort et échappe complétement à la branche "boite noire" ... mais à chaque fois j'ai la flemme .

.

Dur de se remettre à faire des trucs en rapport avec son taf à la maison ...

Par ailleurs dans cette branche "non deep learning" il y a à mon avis bien plus de choses sympa pour l'IA dans les jeux vidéo que dans la branche "deep learning". Surtout dans la branche robotique/simulation/neurobio qui fait de sacré progrès sur les comportements des bestioles et leur simulation avec très peu de neurone et tout pleins d'apprentissage sympa de partout, qui à mon avis serait tout à fait applicable à l'IA des JV sans aucun soucis. Avec un peu d'astuce.

L'avantage c'est que ça donne une IA crédible, avec ses faiblesses, et non une IA basé sur une optimisation de bourrin qui ne vise qu'a gagner et qui est tout simplement imbattable (et donc peu fun finalement en dehors de la démonstration technique). Les mecs vont en revenir aux soucis que les JV avaient eu avec l'IA à l'origine : ils vont devoir la pénaliser volontairement pour qu'elle abaisse sont niveau pour le joueur. Visez un peu la logique derrière : faire des machine de guerre mais qui finalement sont tellement trop performante qu'il faut leur tirer dans les pattes pour les ramener à un niveau "sympa" pour qu'elles soient utilisable.

-

26/01/2019, 17h14 #600

Tout à fait, j'en ai d'ailleurs parlé (rapidement) quelques messages plus haut. Même ça me surprend vraiment que tu classes les sciences cognitives dans l'IA.

Là par contre, je veux bien des refs parce qu'en vingt ans de métier à utiliser et développer des algos d'apprentissages, je suis rarement tombé sur des approches avec apprentissage dont l'objectif n'est pas de résoudre un problème.

Quant à la hype deep learning, elle n'est pas que dans le grand public. Pas moyen d'avoir une conf de traitement de signal ou d'image sans une section deep learning ou sans qu'après ton exposé un type pose la question : "vous avez essayé avec le deep ?".Rien ne me choque moi, je suis un scientifique ! - I. Jones

Répondre avec citation

Répondre avec citation