Oui mais attention, j'ai l'impression que ce que tu décris comme "quantique" est simplement une machine de Turing probabiliste. Le calcul quantique est bien plus que du calcul probabiliste type Monte-Carle, c'est l'intrication quantique et les interférences qui font marcher le truc.

Dans tous les cas tu peux simuler tous les états possibles de ta distribution de probabilités avec une machine de Turing déterministe, donc toutes tes sorties possibles avec leur probabilité respective. Après, tu peux tirer à pile ou face pour en choisir une si tu veux. En connaissant tous les états possibles tu as au moins autant d'information que si tu en connaissais un au hasard.

On est d'accord que c'est une vue de l'esprit et que cette simulation prendrait un temps voire un espace irraisonnable. Mais c'est calculable.

Si on parle d'ordinateur quantique, les choses sont mieux définies. La classe des problèmes solubles en temps polynomial sur une babasse quantique, BQP, contient la classe des problèmes solubles en temps polynomial sur une bécane probabiliste BPP : P ⊆ BPP ⊆ BQP ⊆ PSPACE. On conjecture que BPP≠BQP (il y a plus que du hasard qui joue), mais on n'est pas près de le montrer.La seule façon de simuler de façon exacte un phénomène quantique c'est en fabriquant un ordinateur quantique, et il me semble que c'est une des raisons qui pousse à vouloir tant les mettre au point. Et si un jour une véritable IA devait être mise au point, je parierais davantage sur un ordinateur quantique que sur un ordinateur classique.

Dans tous les cas, avec un algo en temps exponentiel et en espace polynomial sur une brouette déterministe classique (PSPACE), tu résout au moins tous les problèmes de BQP.

La différence (si elle existe) entre ordinateur classique est quantique est au niveau de la complexité du calcul, pas de la calculabilité.

Au passage, sur ta conjecture que le cerveau humain est (au moins) stochastique, comment expliques-tu qu'on soit infoutu de tirer un nombre au hasard sans outil comme une pièce, un dé ou un ordinateur ? Si le comportement observable du cerveau est déterministe et que ses opérateurs de base sont déterministes (chimie et électricité macroscopique), pourquoi penser qu'il y a de l'aléatoire dedans ?

Tu as des refs là-dessus ? Ça me parait chelou une superposition pseudo-quantique à l'échelle macroscopique...

Affichage des résultats 391 à 420 sur 1288

-

15/06/2016, 10h44 #391

-

15/06/2016, 12h15 #392

J'ai conjecturé ça moi ?

Bon,

Tout d'abord le cerveau humain n'est effectivement pas très bon pour générer de l'aléatoire, ce qui pourrait être vu comme un argument en faveur du déterminisme. L'évolution a manifestement jugé que le rapport bénéfice/coût d'un générateur de nombre aléatoire neuronal était assez modeste.

Petite expérience amusante: demande à une personne de penser très vite à plusieurs choses: à une marque de voiture, à une marque de parfum, à une console de jeux... puis très vite tu enchaîne et tu leur dit d'écrire au hasard sur une feuille une couleur et un outil. "vite vite vite, ne réfléchit pas, écrit".

Après, tu sort théâtralement une feuille de ta poche sur laquelle tu auras écrit au préalable les motsqui sont la réponse donnée "au hasard" dans l'écrasante majorité des cas. Succès garanti!Spoiler Alert!

Ensuite, plus que "stochastique" je préfère penser au terme de "calculable" ou "non calculable". Or il se trouve que tout n'est pas calculable.

- Le Théorème d'incomplétude de Gödel a démontré que certains énoncés sont indécidables: on ne peut démontrer s'ils sont vrais ou faux. En pratique, cela veut dire qu'il n’existe aucun algorithme, aucun programme informatique et aucune machine de Turing qui permettra de le déterminer.

- Les mathématiciens ont aussi déterminé que certains nombres, bien que définis rigoureusement, n'étaient pas calculables pour autant. Exemple: le nombre Oméga de Chaitin (la page Wikipédia m'informe cependant que ce nombre bien que non calculabe est "approchable")

- Et, enfin, du point de vue physique, certains phénomènes ne peuvent pas non plus être calculés: on ne peut pas "calculer" si un atome particulier de carbone 14 existera encore dans une heure, juste donner une probabilité.

Tout cela pour dire que si la PENSEE entre dans une de ces catégories, alors il sera à jamais IMPOSSIBLE de la reproduire par un simple processus calculatoire par une simple machine de Turing, car celle-ci ne pourra jamais calculer, par définition, que des processus calculables.

La grande question qui se pose est donc: la pensée est-elle un processus calculable (et donc que l'on peut "résoudre" avec un ordinateur classique) ou non (auquel cas aucun ordinateur classique, serait-il de la taille d'une planète, ne le pourra jamais) ?

J'aurais tendance à soutenir la seconde hypothèse.

-

15/06/2016, 14h08 #393

Cette hypothèse de non-calculabilité est encore plus difficile à défendre que la précédente d'aléatoire/quantique.

Encore une fois, en ce qui concerne la calculabilité, tous les modèles de calcul non-triviaux sont équivalents : que ce soit une machine du Turing déterministe, des fonctions de Church, une machine de Turing probabiliste ou quantique ou non déterministe, ou un circuit quantique, tous peuvent résoudre le même ensemble de problèmes si on leurs donne assez de temps et d'espace (ils peuvent tous se simuler mutuellement en temps fini).

La différence entre ces modèles, elle est uniquement quantitative, au niveau du temps et de l'espace nécessaire. Qualitativement ils sont équivalents.

Les problèmes qui ne sont pas décidables ou calculables, c'est ceux qui ont un problème d'auto-référence, comme le paradoxe du menteur. L'interprétation de ces théorèmes d'incomplétude/incalculabilité, c'est qu'un système ne peut pas être omniscient sur un ensemble de questions qui inclue celles qui le concerne lui-même. Une machine de Turing ne peut pas calculer si une machine de Turing s'arrêtera sur un programme donné. La théorie des ensembles de Cantor ne peut pas définir l'ensemble des ensembles qui ne s'incluent pas eux-même.

Il est donc théoriquement possible que les machines appartiennent à un "univers" (au sens mathématique) clos, et les humains à un univers strictement plus grand qui inclue celui des machines. Les humains pourraient alors résoudre tous les problèmes se rapportant aux machines, y compris ceux que les machines ne peuvent pas résoudre par elles-même. Mais c'est une hypothèse très forte qui nous amène au rang de dieux de tout ce qui est régi par les lois connues de la physique sur Terre. Ça implique aussi que l'intelligence humaine fasse appel à des lois inconnues de la physique (pensée magique).

Malheureusement, notre expérience quotidienne contredit cette hypothèse. On n'a jamais réussi à résoudre le moindre problème indécidable par une machine. On a déjà bien du mal à résoudre plein de problèmes parfaitement décidables et même pas très complexes.

-

15/06/2016, 14h32 #394

Pour moi, c'est l'hypothèse de calculabilité que je trouve difficile à défendre

Je veux dire, il n'y a aucune raison qu'un problème de la nature pris au hasard soit forcément calculable, simplement parce que ça nous fait plaisir, et que c'est plus simple à modéliser. De même qu'une loi de la physique prise au hasard ne sera pas forcément linéaire, et qu'une équation mathématique prise au hasard n'admettra pas nécessairement une solution analytique exacte.

Ici on discute du phénomène potentiellement le plus compliqué de l'univers, la conscience. C'est quelque chose de bien plus compliqué que l’effondrement d'une étoile en supernova, la collision de deux trous noirs ou la dynamique d'un superamas de galaxies. Plus sans doute que le fonctionnement d'une cellule vivante.

Je ne vois pas en vertu de quoi on devrait exiger que ce phénomène soit simple à modéliser ni même calculable par un bête programme informatique. Bon, ok, cela permet de demander des milliards de plus à Google et Facebook pour mettre au point une IA, ce qui est sans doute une raison en soi, mais ça ne veut pas dire que cette approche soit forcément la bonne.

-

15/06/2016, 15h38 #395

Deux trois réflexions générale qui me viennent en lisant ta phrase (et sachant que je ne connais rien aux concept des domaines de problèmes) et que j'aimerais bien vos avis :

- je ne suis pas un matheux, mais il me semble que l'on a pas encore tranché sur le fait de savoir si les maths sont circonscrit au "réel" ou s'ils le dépasse

- du coup par calculable tu veux dire "non calculable avec des chiffres parce que pas la puissance de calcul pour" ou bien "non calculable car pas possibilité de l'abstraire mathématiquement" ?

- je me rappelle aussi avoir lu un papier, jadis, qui disait qu'en gros la puissance de calcul disponible dans l'univers était forcement fini (du fait de la quantité de matière/energie dispo, et aussi par rapport à nos connaissances) et qu'en gros il était "logiquement" impossible qu'un ordinateur à la taille de l'univers puisse se modéliser/simuler parfaitement lui même.

Oui, je m’éloigne un peu de l'IA

-

15/06/2016, 16h04 #396

Ni l'un ni l'autre : non calculable veut dire qu'il n'existe pas d'algorithme qui donne le résultat en un nombre fini d'étapes :

https://fr.wikipedia.org/wiki/Calculabilit%C3%A9

Mais j'ai l'impression que les fonctions non calculables sont la réponse à des problèmes du "second ordre" (ou plus) alors que les problèmes physiques sont des problèmes du premier ordre

-

15/06/2016, 16h08 #397

-

15/06/2016, 16h25 #398

Ça c'est une question philosophique plus ou moins profonde sur le sens des lois de la physique. Il y a des interprétations sérieuses qui considèrent que le calcul est à la base de tout, et que notre "réalité" en est une simple conséquence (à la Matrix).

Mais la question des problèmes calculables ou pas avec un ensemble de règles de base, elles est définie de façon précise et elle admet une réponse précise, même si elle s'oppose à ton intuition. Les lois de la physique connues sont calculables, y compris la physique quantique (si tu prends l'interprétation multi-univers, tu peux simuler tous les univers possibles, et grâce à la causalité et la transmission d'information limitée par la vitesse de la lumière fait que tu peux même te contenter de simuler un espace-temps fini). Citer Gödel ou la mécanique quantique fait bien dans une théorie newageuse, mais ça n'a aucun rapport a priori. Il est bien plus crédible que la conscience soit simplement un phénomène émergent de la complexité du cerveau ©.

Même dans ce cas, il y a toujours des arguments vraisemblables pour réfuter la possibilité d'une IA, par exemple :

1. Le niveau de complexité menant à l'émergence de la conscience est totalement inaccessible à notre niveau de technologie. (Ça a pris 4 milliards d'années d'évolution d'une planète entière, et on voudrait recommencer en partant de zéro en quelques décennies ?)

2. Même si on atteint ce niveau de puissance de traitement brute, il faudrait encore savoir quoi mettre dedans et programmer l'ordinateur pour en faire une IA, ce qui est inaccessible à notre intelligence collective (Idem, après 4 Gannées.planète d'évolution on n'est toujours pas foutu d'écrire un programme de traitement de texte sans bug, donc c'est sans espoir.)

-

01/07/2016, 19h26 #399Caneton

Il y a un dossier dans the economist sur l ia et les consequences economiques et autres.

http://www.economist.com/news/specia...-it-cause-mass

Bonne vue d ensemble mais assez superficiel, le dossier de Humanoid etait mieux sur beaucoup de points.

-

08/06/2017, 20h39 #400

Sujet dont on a déjà débattu plusieurs fois mais la vidéo est vraiment bien foutue.

-

08/06/2017, 21h00 #401

Ah ouais, superbe la vidéo, ça explique très simplement ce que j'essaie d'expliquer de temps en temps à des gens qui me sortent le discours habituel que c'est comme la révolution industrielle, qu'on crééra plein de nouveaux jobs etc.

Alors que dans la boite où je bosse, quand je vois toutes les possibilités qu'on offre aux entreprises... c'est juste impressionant tout ce qu'on est déjà capables d'automatiser, et ce qui arrivera dans le futur proche

Merci Orhin !

-

08/06/2017, 22h07 #402

-

20/06/2017, 12h24 #403

Il est surtout qu'il est complètement à la rue sur bien des points, amha. Déjà le titre : "The return of the machinery question" ... Sauf que ce n'est pas un "retour". Depuis l'automatisation, les sociétés occidentales n'ont jamais comblé le trou, on est resté à de haut niveau de chômage (edit : ou de précarité, peu importe comment c'est reparti) due à la disparition des métiers de production.

L'autre point c'est que comme les sociétés modernes se sont de plus en plus tournées vers une exploitation des pays pauvre proche de l'esclavage (faut être honnête), ils ont peu à peu laissé tomber la sur-automatisation au profit de l'exploitation d'humains bien moins chers ... Et bon, même si dans certains vieux pays exploités comme la Chine ça risque de changer, ils vont juste migrer ailleurs (genre en Afrique :rolleyes). Donc ce n'est pas comme si on avais une masse de production automatisée et que l'IA va encore plus faire perdre du taf à ceux qui reste... c'est faux dans la grande majorité des cas vu que vu la situation démographique mondiale, l'humain restera moins cher que la maintenance de bras robotique

Enfin, la plupart des tafs restant sont soit des boulots manuels en environnement complexes (genre éboueurs, fermiers etc...) qui nécessiteraient des robots bien trop cher pour que le remplacement des petites mains vaille le coups. Soit des boulots de contacts dans le tertiaire (tenu de magasin, service client, vente etc...) qui là également sont loin de se voir remplacer par l'IA puisque ce sont justement des boulots "interfaces" entre des processus quasiment tout automatique (la téléphonie par exemple) et le client humain. Il y a un minimum non supprimable au bout d'un moment

Allez, pour être honnête, il y a de fortes chance que tout les futurs metros (peut être pas les trains cela dit) et services de taxi, soient automatisé à l'avenir. Mais ça ne fait pas un très grand nombre de personne dans la population qui en dépendent ...

Bref, à mon avis les challenge de la société moderne sont très loin d’être des problèmes causés par l'ultra-automatisation si on fait le compte à la fin... Et je trouve que ceux qui prétendent le contraire et mettent trop l'accent dessus tentent bien souvent (pour nos politiques par exemple) de cacher des problèmes bien plus fondamentaux... l'IA comme cache-misère utile politiquement, j'ai l'habitude dans mon labo

L'un des problème fondamentaux étant qu'au lieu d'avoir peur de l'automatisation on devrait s'en réjouir à mort ... dans un monde ou les richesses produites par l'automatisation irait à la caste qui "perds" son ancien métier ... sauf que c'est tout l'inverse qui se produit... c'est l'unique problème fondamental derrière l'automatisation : la redistribution des richesses produites par les processus automatisés... et ça devient un problème car la redistribution n'a pas lieu et au contraire l'automatisation permet à quelques uns d'accumuler encore plus sans devoir redistribuer ... Long sujet de débat dans mon labo régulièrement

On voit d'ailleurs, que ce soit dans la vidéo ou l'analyse plus haut, qu'ils évitent soigneusement le sujet de "pourquoi c'est un problème encore ?" ni toute tentative de solution. Il ne font qu'énoncer un fait ... qui découle principalement d'une organisation de chie de la société. Au lieu de proposer d'y remédier ou, tout du moins, d'en faire l'analyse, ils se cantonnent dans le "Olala olala" ... c'est bien pratique

Ajoutons à cela qu'en général le diagnostic est inutilement alarmiste, va trop loin, et ne prends guère en compte certains phénomènes qui font le chemin inverse. L'IA n'est pas suffisamment au point pour toute une gamme (large) de métier qui sont fantasmés comme remplaçable dans la décennie à venir. Quant à l'ancienne automatisation, notamment agricole, pas mal d'état font le chemin inverse en revenant à des exploitations plus petite, permaculture et cie, qui évite l'appauvrissement et la mort des terres fertiles à long terme, mais qui demande plus d'employés. Et sur ce point, même les réticents (dont notre pays actuellement) vont devoir faire machine arrière quand certaines plaines agricoles subiront la désertification due aux traitements des dernières décennies (ce qui arrivent aux USA en ce moment). Cet exemple parlant pour dire qu'il y a de très nombreux emplois dans certains domaines qui vont réapparaître de facto si les états souhaitent garder leur population en vie Et ça, ça fait rarement partie de leur diagnostic alarmiste, cette vague annoncée de "desautomatisation" partiel, tout du moins, de certains secteurs.

Et ça, ça fait rarement partie de leur diagnostic alarmiste, cette vague annoncée de "desautomatisation" partiel, tout du moins, de certains secteurs.

Bref, tout est à relativiser dans cette histoire...Dernière modification par Nilsou ; 20/06/2017 à 14h27.

-

20/06/2017, 12h28 #404Banni

- Ville

- Dolanvill

Le chômage structurel de masse est une exception française.Depuis l'automatisation, les sociétés occidentales n'ont jamais comblé le trou, on est resté à de haut niveau de chômage due à la disparition des metiers de production.

The Economist est anglais, il y a pas de chômage en angleterre (moins de 5%.)

L'IA et l'informatique en générale est à même de remplacer énormément d'emplois tertiaires "administratifs" et des centaine de milliers de fonctionnaires.

-

20/06/2017, 12h44 #405

Ça dépends de ta définition du chômage (la définition, non seulement varie par pays, mais est juste risible dans certains cas. En Angleterre il faut rappeler qu'il y a le contrat 0h, avec 0h de garantie dans le mois, donc, mais non compté dans le chômage. Sans parler du grand nombre d'auto-emploie façon Uber, qui peuvent ne rien rapporter et ne constituer aucune heure effective travaillée, mais non compté dans le chômage non plus etc etc... Les taux sont donc difficilement comparable) . Il y a un grand nombre de temps partiels TRÈS partiel en Angleterre.

Difficile d'obtenir des chiffres précis sur le nombre d'heure travaillés. Mais à même niveau de vie tu peut comparer le taux de pauvreté, plus grand en Angleterre.

- - - Mise à jour - - -

Pas totalement faux pour les trucs VRAIMENT répétitif. Mais sauf qu'il y en a finalement peu (peu restant actuellement). La plupart demandent de l'improvisation en fonctions des conditions.

Je souhaite bon courage au pays dont la structure de fonctionnaire dépendra d'IA. A la moindre catastrophe naturelle ou autres situations d'exceptions le pays agonisera dans son jus ... Pour exemple, régulièrement le japon dit tenir sur ses fonctionnaires d'élites en cas de catastrophe... rien ne remplace une structure ultra-adaptable faite d'humain capable de juger en fonction d'une expériences et éducation de plusieurs dizaines d'années quand il s'agit de determiner quand suivre ou non, respecter ou non, appliquer ou non, certaines règles, quand en inventer de nouvelles sur le tas dans l'urgence même si ce n'est pas très légal etc...

Ne parlons pas des services de police ou de pompiers et autres ...

Donne des exemples d'un poste précis remplaçable sinon

edit : je n'arrive plus à retrouver mais de toute façon il n'y a pas photo, j'avais un document il y a peu qui montrait clairement que le nombre d'heures travaillées en occident a été quasiment divisé par 2 ou 3 en 100 ans alors même que la population à augmenté. Il a même servit de biblio a l'un de nos papier, je retrouverais ça. Donc sans entrer dans le détail on a pas "remplacé par magie" les heures de travail perdues durant la première vague d'automatisation... comme je le disait dans mon premier post.

reedit : trouvé : Stats de l'OCDE, période depuis 1950 (seulement, faudra que je trouve des chiffres pre-revolution indus).

https://data.oecd.org/fr/emp/heures-...ndicator-chart

Il suffit de tirer la période en bas de 1950 à nos jours dans la catégorie "heures travaillés" . C'est déjà divisé par le nombre de personnes effectuant ces heures. En France on est passé de 2293 à 1500, par exemple. C'est plus smooth aux royaume unis, 1937 à 1650 en gros. Mais la période de donnée est plus restreinte. Faudrait avoir une estimation pre-revolution industrielle pour estimer la perte globale... mais si c'est une courbe du même ordre jusqu'en 1850 ça fait beaucoup ...Dernière modification par Nilsou ; 20/06/2017 à 14h30.

-

20/06/2017, 13h06 #406une balle, un imp (Newstuff #491, Edge, Duke it out in Doom, John Romero, DoomeD again)

Canard zizique : q 4, c, d, c, g, n , t-s, l, d, s, r, t, d, s, c, jv, c, g, b, p, b, m, c, 8 b, a, a-g, b, BOF, BOJV, c, c, c, c, e, e 80, e b, é, e, f, f, f, h r, i, J, j, m-u, m, m s, n, o, p, p-r, p, r, r r, r, r p, s, s d, t, t

Canard lecture

-

20/06/2017, 13h37 #407nul, pas d'avatar

- Ville

- vrette

L'ironie c'est que sous Thatcher, les fonctionnaires anglais ont été les premiers à rationaliser la gestion de service en informatique, pour garder leur boulot alors que miss Maggie voulait tout refiler au privé pour que ça leur coûte moins cher.

Ils ont défini des processeurs de gestion de service qui sont toujours utilisés par toutes les grosses boîtes de toutes nationalités aujourd'hui, après quelques mises à jour.

https://fr.wikipedia.org/wiki/Inform...ucture_Library

-

20/06/2017, 14h18 #408

Ha tient je savais pas ça, petite histoire sympa

-

20/06/2017, 15h10 #409Banni

J'espère que ça a pas déjà été posté

J'ai pas eu le temps de lire tout le topic, mais j'aimerais intervenir sur un point que je trouve important (et pas encore vu évoqué)

(et pas encore vu évoqué)

J'ai fait un peu de programmation d'IA, notamment réseaux de neurones artificiels/machine learning et reconnaissance d'image.

Et un truc qui me dérange pas mal c'est le gros flou autour de la définition même d'IA. Sujet très vendeur, mais peu de substance quand on en parle. (J'ai l'impression que c'est un peu comme la physique quantique, sujet mal compris du coup on s'imagine n'importe quoi)

Personellement je vois très peu de valeur ajoutée aux IA, et j'ai l'impression qu'on en parle comme un changement majeur, une révolution contemporaine alors que c'est un outil lambda où il n'y a pas eu tant d'innovations, enfin justement c'est là ma question!

Est-ce qu'il y a vraiment eu quelques avancées majeures concernant les IA? Genre une année 1905 en physique pour les IA? Y'a des exemples concret où une avancée a permis de résoudre un prob existant?

Je vais prendre quelques exemples mais pour moi la valeur ajoutée est systématiquement non liée à l'IA. La valeur ajoutée c'est toujours l'heuristique/la compréhension fondamentale du problème, et non l'IA en elle même.

La vraie magie derrière la reconnaissance/analyse automatique d'image (genre reconnaissance faciale, ou numérisation d'un texte manuscrit avec détection des charactères) c'est ce genre de truc:

https://en.wikipedia.org/wiki/Sobel_operator

https://en.wikipedia.org/wiki/Hough_transform

Là est le vrai génie je trouve et non pas l'IA qui en soit n'est que de la force brute et l'utilisation de la puissance de calcul. Genre pour moi la valeur ajoutée des algos "IA" c'est juste d'être un peu plus généraliste, de la même manière que tu peux faire des calculs monstrueux en Monte Carlo alors que la solution se trouve sur un bout de papier. D'ailleurs je vois ça assez souvent en ce moment, un mec pose une question de proba simple et l'informaticien débarque pour simuler tout ça et trouver un résultat qui se calcul directement avec une formule fermée.

TL;DR: Pour moi actuellement l'IA c'est taper sur sa télé jusqu'à ce qu'elle remarche au lieu de comprendre le problème fondamental. Et la seule avancée concernant ce domaine c'est l'augmentation de la puissance de calcul qui permet de taper plus fort sur sa télé ("deep learning").

Avis d'inculte ou je suis pas loin de la vérité?

Quand on voit l'article wikipédia ça irait dans mon sens, mais je connais pas la recherche qui se fait concernant les IA: https://fr.wikipedia.org/wiki/Intell..._syst.C3.A8mes

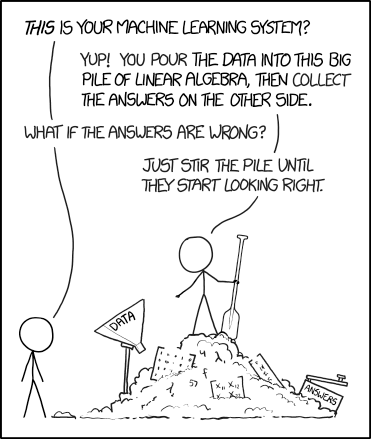

Mise à part l'ingéniosité initiale d'utiliser la force brute de calcul pour faire un simulacre d'apprentissage et pouvoir résoudre un problème général qu'on comprend mal (cf le comic d'xkcd) je connais pas les problèmes théoriques fondamentaux et avancées actuelles dans ce domaine.

----

Et pour ceux qui s'inquiètent pour leur emploi rassurez-vous, j'ai travaillé dans de grandes boites ou le pôle R&D en informatique consiste en une grappe de serveurs surpuissants dédiés à l'éxécution d'une dizaine de feuille excel/code vba (oui). Mais on avait des confs sur le machine learning et "la blockchain" tous les jours.

D'où ma relative aigreur concernant le sujet

Dernière modification par Anonyme20240202 ; 20/06/2017 à 15h23.

-

20/06/2017, 15h47 #410

En fait tu devrais lire mon post d'intro, ou les premieres pages qui font un résumé.

Ce dont tu parle c'est l'IA "machine learning/deep learning" qui n'a d'IA que le nom et qui correspond bien à la BD que tu a linké.

Et on fait en effet beaucoup de foin autour pour pas grand chose, pour la simple raison que les matheux et les gens en traitement d'image, ou encore les analystes financiers ont eu des paillettes dans les yeux quand on leur a vendu un anticipateur universel en kit de tout en fonction de tout dés lors qu'il y a suffisamment de donnée à manger. (et pour les images, dés lors qu'on leur a vendu un categorisateur de tout un peu malin façon Kohonen, Kmean, fonction noyaux et cie) Le rêve pour eux. Mais qui n'aboutit à rien d'autres qu'a améliorer l'existant, sans grandes nouveautés. En tout cas, si ça apporte pour le traitement visuel ou autre, ça n'apporte rien pour l'"intelligence". (Sobel ou Hough sont par contre clairement des pré-traitements qu'on retrouve aussi en neurobio dans les premieres couches de la vision (quand ce n'est pas directement un traitement retinien), meme les mecs en IA "fumiste vendeur" ne considèrent pas ça comme de l'IA en general )

)

Les recherches intéressantes en IA ne se situent clairement pas là, mais au niveau de ce qu'on fait dans mon labo par exemple (mais ce n'est pas très objectif, j'admets ) ou on s'inspire de la neurobio simplifiée pour essayer de créer des agents qui se devellopent eux meme un peu comme des gamins, découvrent leur environnement etc....

) ou on s'inspire de la neurobio simplifiée pour essayer de créer des agents qui se devellopent eux meme un peu comme des gamins, découvrent leur environnement etc....

La recherche dans le domaine actuellement est juste complètement ouf. J'ai vu des trucs sidérants pour un début (on arrive à faire des robots qui se mettent à jouer naturellement avec leur environnement par simple effet émergeant de réseaux de neurones simple inspiré de la neurobio, à faire des réseaux chaotique apprenant la structure de la grammaire par simple essai erreur en discussion et en action etc... ). Malheureusement elle est encore balbutiante, parce que ça vend moins bien que la bruteforce des autres qui te le matine de big data et cie pour le vendre aux grosses boites. L'IA qui créé des agents intelligents en leur permettant des erreurs n'est que très peu utile pour les industriels car un humain fait mieux.

Donc on bosse avec des psychologues, des neurobiologistes et quelques militaires qui se foutent des erreurs dans certaines applications (pigeon voyageur simple, chien "intuitif" porteur de sac etc...

Je peut te faire un historique, mais pfffiou, il me faut du courage.

edit : Pour l'IA "foin autour" l'historique est simple sinon : Minsky en 68/69 prouve que le perceptron sert à rien pour toute une gamme de problème. C'est le truc le plus connu, mais "destructeur" et non "constructeur" car il met fin à tout les financements pour des plombes. Puis on invente, en parralele, tout ce qui est [fonction noyau et autres categorisateur + perceptron] ou [Perceptron multi-couche] permettant d'approximer toute courbes.

Ou trouve toute une gamme d'application à tout ceci, généralement pour remplacer des tuning "à la main" ou des résolution analytique complexe. On gagne grandement en temps dans pas mal de truc.

En parallèle a débuté l'IA d'action, qui est mon domaine. Qui étudie le développement d'IA comportemental bio inspirée dans un milieu réel (on parle d'IA incarnée et qui nécessite d’être incarnée), la communauté est encore petite, mais les trucs les fou du moment sont toujours dans notre branche . Le potentiel est assez monstrueux et pour l'instant c'est surtout du défrichage tellement il y a de voix et de truc à faire. Donc plutôt des dizaines de mini révolution plutôt qu'une grosse. Ce qui va aussi avec la méthode de travail, puisqu'on décortique partie par partie des boucles ou des parties spécifiques du cerveau et que les comportements sont particulièrement "additif", chaque petit avancement améliore un peu le comportement de nos robot et nous fait encore plus de parallèle avec la neurobio. Mais bref...

. Le potentiel est assez monstrueux et pour l'instant c'est surtout du défrichage tellement il y a de voix et de truc à faire. Donc plutôt des dizaines de mini révolution plutôt qu'une grosse. Ce qui va aussi avec la méthode de travail, puisqu'on décortique partie par partie des boucles ou des parties spécifiques du cerveau et que les comportements sont particulièrement "additif", chaque petit avancement améliore un peu le comportement de nos robot et nous fait encore plus de parallèle avec la neurobio. Mais bref...

En gros il y a des trucs assez fou, mais ça ne fait pas encore la unes des journaux ^^

Je devrait peut-etre mettre quelques videos ici de temps à autres ...

edit : Petit exemple simple qui explique le "non buzz" autour. Imaginons que tu simule à 100% le cerveau d'une souris. Un truc fou quand meme d'un point de vue avancée. Tu simule son comportement robotiquement, tu a tout qui est similaire, tu a meme des souris qui interagissent avec et tout. Bref, le max de ce que tu pouvait esperer, tout est OK rien à signaler.

Normalement, tu serais en droit d'esperer une interview sur tout les plateaux, un buzz de fou et un rdv à l'ONU dans la minute suivante pour débattre du risque d'aller plus loin ou non . En vrai pas du tout.

. En vrai pas du tout.

C'est contre-intuitif mais assez simple une fois compris : je fout cette souris dans un JV, va tu faire la différence avec une IA de chie un peu tuné ? Ben en général pas trop, tu ne la remarquera peut etre meme pas ... (ça a d'ailleurs été prouvé dans pleins d'application)

Et c'est là le soucis... hormis le truc qui marche ou qui parle (qui dans les deux cas peut etre con comme ses pieds malgré sa spécialisation dans ce domaine) créer de l'intelligence ne va pas faire le buzz tout simplement parce que ça ne saute pas aux yeux ... dans un forum d'IA on n'y prêterais même pas attention en fait... car l'intelligence, le fait d’être malin, d'apprendre, de s'adapter, ça peut être aussi discret et banal que le comportement d'un pauvre cloporte...

Donc rien à faire, ça ne buzzera pas. Et seul une interaction attentive, et non une video, pourra emmener l'observateur à se rendre compte de la profondeur de la realisation.

Sur ce point d'ailleurs, je ne fais que répéter les prédictions d'Asimov, qui avais prédit une chutte de l'IA blingbling humanoïde, puis une remontée douce et sans heurt via les jouets pour enfants, entres-autres. Tout simplement parce que : quoi de mieux qu'un jouet et l’appréciation d'un enfant sur le long terme pour jauger de la oufitude d'une bébête artificielle et ramener de la thune dans le secteur, l'attention des parents, des décideurs, puis boule de neige et c'est bon ? Un grand homme cet Asimov...Dernière modification par Nilsou ; 20/06/2017 à 16h28.

-

20/06/2017, 15h59 #411

Je suis pas trop d'accord avec une de tes conclusions, j'ai vu pas mal de cas industriels où les SMA (forme basique d'intelligence collaborative) font bien mieux que l'humain (principalement grâce à leur puissance de calcul, mais tout de même).

Ou alors, je n'ai rien compris, ce qui n'est pas impossible non plus.Allez au diable Square-Enix Co. Ltd., Character Development, Marketing Division, et autres Online Business chaipasquoi.

-

20/06/2017, 16h06 #412

La résolution de problème par système multi-agent est une branche à part. Souvent elle tient plus de l'optimisation génétique que de l'IA proprement dites ...

Neanmoins, elle reste en effet très efficace dans bien des domaines. Mais ça n'apporte rien à la construction d'intelligence artificielle en soit.

Ce sont deux trucs clairement séparé, qui peuvent interagir dans certains domaine de recherche, mais pas forcement (nous on fait des SMA avec des trucs à base de réseau de neurones, mais c'est un cas exceptionnel)

edit : sinon tu parlais de cette conclusion ci ? :

"L'IA qui créé des agents intelligents en leur permettant des erreurs n'est que très peu utile pour les industriels car un humain fait mieux. "

Sauf que va proposer à un industriel un SMA qui incluent des agents capable d'erreur . Bien souvent il va t'envoyer paitre si ça implique un risque quelquonque ...

. Bien souvent il va t'envoyer paitre si ça implique un risque quelquonque ...

Le plus souvent les SMA indus sont des formes de résolutions de problème parallèle mais dont on a une bonne certitude sur le résultat, on ne leur permet, (en tout cas de ce que j'en sait) ni d'apprendre, ni d'évoluer etc.. on les conçoit de but en blanc pour leur tache et c'est tout. Ce qui ne constitue pas vraiment une IA sympa à mon sens si aucune évolution n'est possible. C'est juste un traitement algo simple, malin certes, un peu chaotique certes et qui donnent donc l'impression d'une certaines "vie" certes, mais figé tout de même.

Ou alors sur des problèmes non critiques peut-être ? Mais ça m’étonnerais, l'apprentissage + multi-agent reste une combinaison assez expérimentale et non appliquée de façon pratique pour le moment hors labo ...Dernière modification par Nilsou ; 20/06/2017 à 16h17.

-

20/06/2017, 16h19 #413Banni

Ah bah je connaissais pas le perceptron tiens, merci ça va me faire une bonne pelote/un bon point de départ à dérouler sur wikipedia!

-

20/06/2017, 16h24 #414

Je ne m'y connais pas assez mais je crois qu'on peut intégrer une forme d'IA dans les agents d'un SMA, au moins du type neuronale (renforcement?). Ce qui ne change effectivement rien à leur fonction/rôle mais constitue une forme d'évolution.

Pour ce que tu dis dans l'industrie, il y a plein de problèmes où avoir une solution rapide et pas trop déconnante rapporte (comparé par exemple à des algo dédiés conçu par un expert - non CPC - pour des scénarios qui ne sont plus valides), par exemple la planif des écrans de pub sur les chaînes de TV. (bon, en l'espèce, je ne crois pas que ce soit fait avec des SMA, mais ça pourrait).Allez au diable Square-Enix Co. Ltd., Character Development, Marketing Division, et autres Online Business chaipasquoi.

-

20/06/2017, 16h28 #415

"Mise à part l'ingéniosité initiale d'utiliser la force brute de calcul pour faire un simulacre d'apprentissage et pouvoir résoudre un problème général qu'on comprend mal ", j'ai du mal en quoi cela n'est déjà pas en soi une percée majeure qui pourrait suffire à rendre la machine apte sur pas mal d'emplois.

Quand le simulacre d'apprentissage permet de faire mieux qu'une recherche exhaustive,d'un point de vue résultat,comment le distinguer d'une intuition humaine.

-

20/06/2017, 16h29 #416

-

20/06/2017, 16h30 #417Banni

Oui je suis d'accord c'est pour ça que j'ai dit "mise à part" cette percée majeure. Je parle des évolutions qui ont suivi la naissance de ce concept

-

20/06/2017, 16h34 #418

Tu peut le faire en effet, nous on le fait donc c'est bien possible

. Mais dans ce cas tu suppose que tu permet des erreurs (sinon il n'y aurait rien à renforcer ou dérenforcer, il faut que tu permette l'essai erreur pour chaque agent) donc tu dit exit à toute application critique; ET tu suppose au passage que tu ai de quoi apprendre ... ce qui n'est pas toujours le cas.

. Mais dans ce cas tu suppose que tu permet des erreurs (sinon il n'y aurait rien à renforcer ou dérenforcer, il faut que tu permette l'essai erreur pour chaque agent) donc tu dit exit à toute application critique; ET tu suppose au passage que tu ai de quoi apprendre ... ce qui n'est pas toujours le cas.

Bref, pas mal de conditions qui font qu'a ma conaissance ce n'est pas utilisé ainsi dans l'industrie actuellement. On ne le fait qu'en labo pour le moment.

Sinon la planif des écrans de pubs c'est difficilement parallélisable comme problème je dirais, comme ça à première vue

- - - Mise à jour - - -

Dans ce domaine précis pas grand chose, puisque une fois que tu a fait un truc qui peut tout approximer, tu ne peut que le raffiner de plus en plus, ce qu'ils ont fait, en grattant des pouilleme de pourcentage. Pas très intéressant amha.

Dans le reste de l'IA, et surtout en comortementale, pas mal de chose. Je vous trouverais des videos la prochaines fois que je vais en conf J'ai tellement l'habitude d'en voir des expés sympa dans mon milieux restreint que je ne pense que rarement à les garder pour les partager ^^.

J'ai tellement l'habitude d'en voir des expés sympa dans mon milieux restreint que je ne pense que rarement à les garder pour les partager ^^.

-

20/06/2017, 16h39 #419Banni

Y'a computerphile qui a fait de très très bonnes vidéo sur le sujet (en anglais).

Il faut cherche sur le channel mais beaucoup de sujets concernant l'IA ont été postés

https://www.youtube.com/user/Computerphile/videos

J'aime beaucoup celle là (une bonne première approche pour voir comment modéliser un problème pour le donner à manger à une IA):

-

20/06/2017, 16h42 #420

Généralement ce n'est qu'un approximateur linéaire au doigt mouillé qui en ressort. Ça ne remplace pas les anciennes méthodes, c'est juste plus rapide. Auparavant tu faisait de la simulation numériques ou de la régression sur les données pour faire fitter les courbes. Au pire avec suffisamment d'exemple tu établissait des abaques. Tu connais les abaques ? Ces tableaux de courbes qui ne sont, finalement, que des succession d'exemples connu relié par des points et qu'on consulte pour résoudre le problème sur les points intermédiaire en supposant que c'est suffisamment linéaire ?

Bon ben voila, le deep learning, ça te pond une abaque de façon automatique au lieu de la faire à la main et ça te la trouve peu importe le nombre de dimension, ce qui est cool.

C'est sympa, ça permet d'économiser des matheux et des ingés sur les problèmes simple qu'on pourrait résoudre analytiquement, ça t'économise de la soufflerie ou autres simulation numerique/pratique quand tu le résolvais de cette manière auparavant, et dans quelques rares cas ça te trouve des liens entre des trucs que tu n'aurais pas imaginé lier.

C'est cool, c'est sympa. Rien de tout cela ne te permettra de construire une IA qui se lèvera un jour pour te dire coucou, qui établira des stratégie "humaine" dans un JV, qui aura des comportements animaux crédible et persistants dans un MMO ou un robot, qui chassera des insectes en y croyant fermement à sa nourriture sous forme de drone ou qui sera capable, avec n'importe quel corps, d'apprendre à l'utiliser malgré ses défauts pour explorer son environnement, agir avec etc...

Bref, en fait, rien de ce que tu attends d'une IA au sens sympa du terme

Répondre avec citation

Répondre avec citation